PowerFlex 4.x HCI 노드에서 NVMe RDM을 교체하는 방법

Summary: 이 문서에서는 NVMe 디바이스를 교체하고 SVM에서 RDM 구성을 수행하여 ESXi 호스트에 올바르게 매핑하는 방법을 단계별로 설명합니다

Instructions

단계

1- 드라이브 속성

찾기iDRAC 유틸리티를 사용하여 NVMe 드라이브에 대한 정보를 수집합니다.

- 인터넷 브라우저에서 http://< iDRAC_IP_address>로 이동합니다.

- DELL Console Login 창에서 사용자 이름과 암호를 입력하고 Login을 클릭합니다. Integrated Dell Remote Access Controller 화면이 나타납니다.

- 탐색 창에서 스토리지>개요를 선택한 다음 물리적디스크를 클릭합니다. iDRAC에 서버에 설치된 물리적 드라이브 목록이 표시됩니다.

- Status 열에서 Failed 상태의 드라이브를 검색합니다.

- 의 NVMe 정보 표에 드라이브의 이름, 슬롯 번호 및 일련 번호를 기록합니다.

드라이브이름, 드라이브슬롯 및 드라이브일련번호행

2 -하이퍼 컨버지드노드에서SDS정보 수집

PFMP(PowerFlex Manager Platform)를 사용하여 하이퍼 컨버지드 노드에서 NVMe 드라이브에 장애가 있는 PowerFlex SDS에 대한 정보를 수집합니다.

- 웹 브라우저에서 PFMP IP 주소를 입력하고 관리 사용자로 로그인합니다.

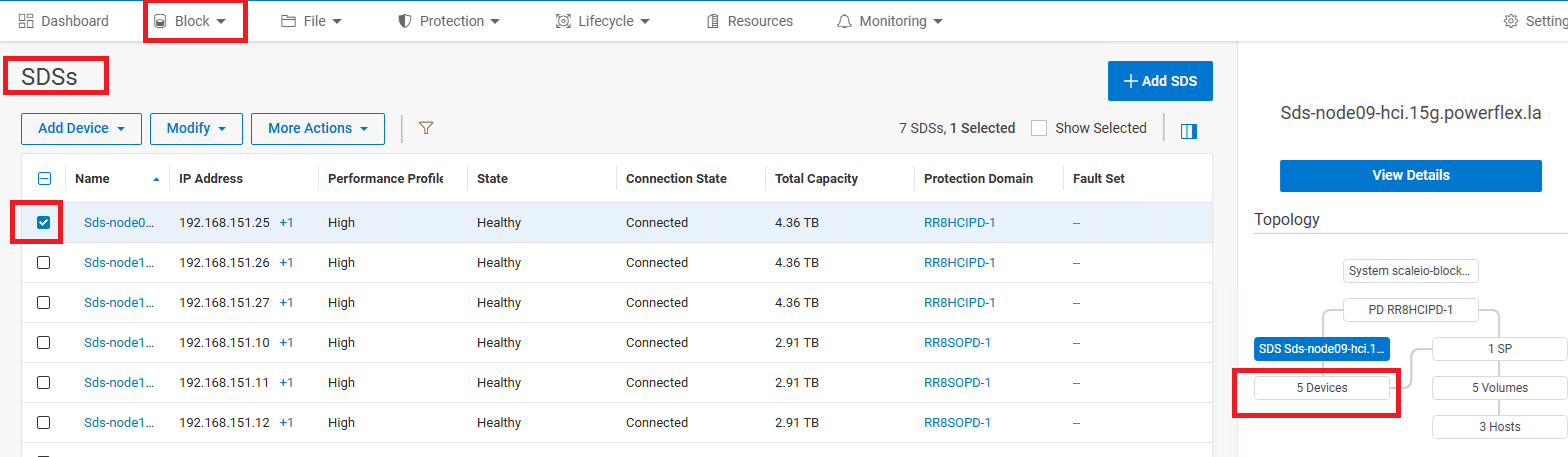

- Block > SDSs.를 클릭하고 장애가 있는 NVMe가 있는 영향을 받는 SDS 노드를 선택합니다.

- 오른쪽 창에서 선택한 SDS 아래의 Devices를 클릭합니다

- 장애가 발생한 디바이스 경로와 SP 이름을 기록해 둡니다.

예를 들어 다음과 같습니다.

SSD => /dev/sdX

NVMe => /dev/nvmeXn1 -

CloudLink로 암호화된 디바이스의 경우 디바이스 경로는 다음과 같이 표시됩니다.

SSD => /dev/mapper/svm_sdX

NVMe => /dev/mapper/nvmeXn1 - SSH를 사용하여 ESXi 호스트에 연결

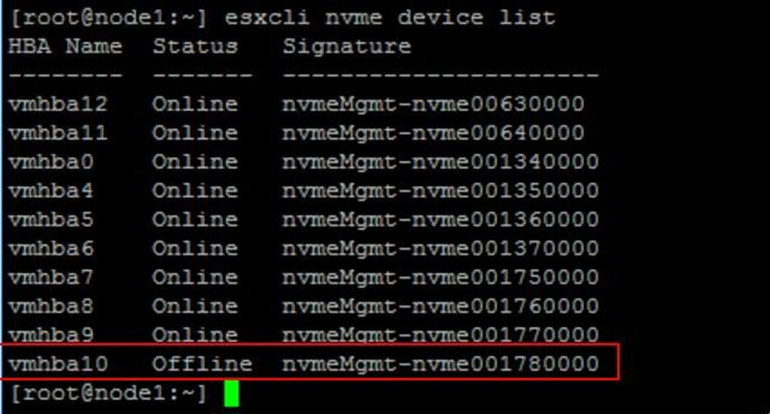

- 다음 명령을 실행하여 장애가 발생한 디바이스의 이름을 찾습니다.

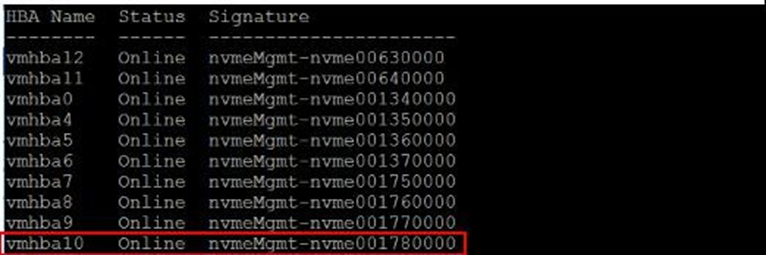

esxcli nvme device list그러면 다음과 유사한 출력이 표시됩니다.

-

장애가 발생한 디바이스는 디바이스 목록의 Status 열에 Offline으로 표시됩니다.

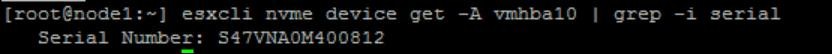

디바이스 이름을 기록해 둡니다(예: vmhba10). - vmhbaX 디바이스의 어댑터를 찾아 일련 번호를 찾습니다.

예:esxcli nvme device get -A vmhbaX | grep -i serialesxcli nvme device get -A vmhba10 | grep -i serial출력에는 일련 번호를 포함한 드라이브의 세부 정보가 표시됩니다.

3 - 하이퍼 컨버지드노드의PowerFlex에서결함이 있는NVMe드라이브제거

- PFMP에 아직 로그인하지 않은 경우 로그인합니다.

- PFMPGUI 왼쪽 창에서 Block >SDSs를 >클릭하여 오른쪽 차트의 디바이스 하이퍼링크에서 SDS 디바이스를 나열합니다.

- 장애가 발생한 디바이스의 확인란을 선택합니다. 선택한 스토리지 디바이스가 2단계에서 적어 둔 디바이스와 동일한지 확인합니다

-

위쪽 메뉴에서 More ActionsRemove > 를 클릭합니다.

-

RemoveDevice대화 상자에서 Remove를 클릭하여 확인합니다.

- 장애가 발생한 드라이브가 CloudLink를 사용하여 암호화된 경우 디바이스의 암호화를 해제하거나 CloudLink를 사용하지 않는 경우 이 단계를 건너뜁니다.

- SSH를 사용하여 노드에 연결합니다.

- 다음 명령을 실행합니다.

- 장애가 발생한 드라이브가 CloudLink를 사용하여 암호화된 경우 디바이스의 암호화를 해제하거나 CloudLink를 사용하지 않는 경우 이 단계를 건너뜁니다.

-

svm -y erase /dev/nvmeXn1

여기서 X 는 숫자로 된 드라이브 식별자입니다.

4 - SVM에서 결함이 있는 디바이스의 RDM을 제거합니다.

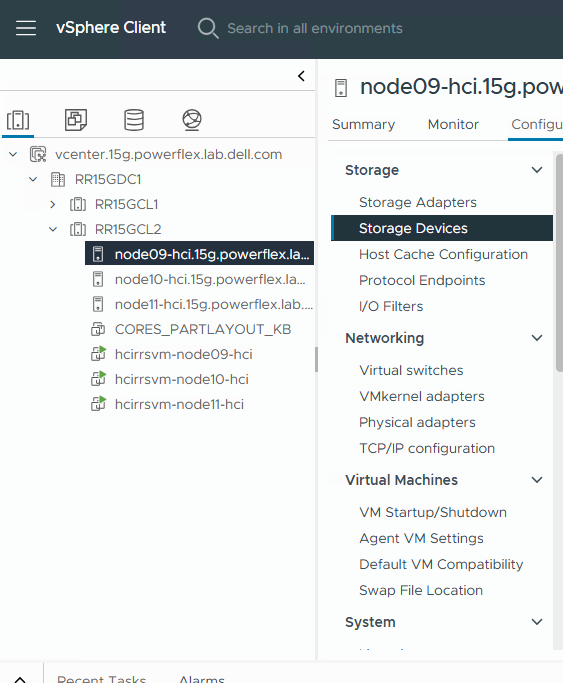

- vCenter에 다시 로그인합니다.

- 인벤토리창에서 호스트및클러스터를 선택합니다.

- 탐색 창에서 영향을 받는 ESXi HCI Server를 선택합니다.

- 구성탭에서 스토리지> 스토리지 디바이스를선택하여 호스트의 스토리지 디바이스를 확인합니다.

- 작동 상태가 Dead 또는 Error인 NVMe 디바이스를 찾습니다. 자세한 내용은 아래의 "ESXi server에서 디바이스 슬롯과 OS 경로의 상관 관계 분석"을 참조하십시오.

- 디바이스 세부 정보 >속성 탭에서 디바이스의 PowerFlex 드라이브 이름과 NVMe 식별자를 찾아 기록해 둡니다.

-

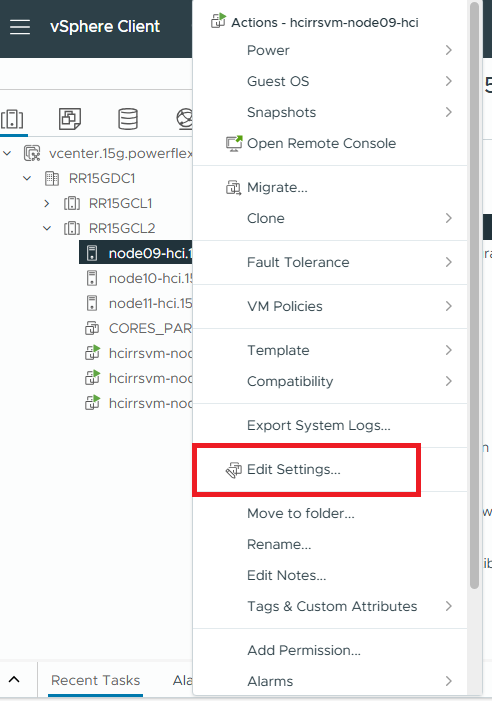

탐색 창에서 영향을 받는 HCI ESXi 호스트에 있는 SVM 을 마우스 오른쪽 버튼으로 클릭하고 Edit Settings를 선택합니다.

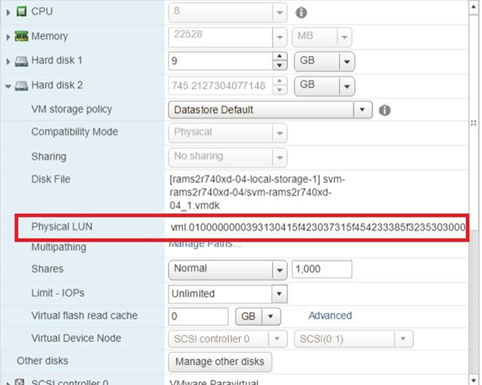

Edit Settings 창에 Virtual Hardware 탭이 표시됩니다. SVM 세부 정보에는 하드 드라이브가 포함됩니다. 흐리게 표시되는 모든 하드 드라이브는 RDM 디바이스입니다.

- 각 RDM의 속성을 확장합니다.

Physical LUN 필드에서 이전 단계에서 얻은 NVMe 디바이스의 식별자 값을 찾습니다.

-

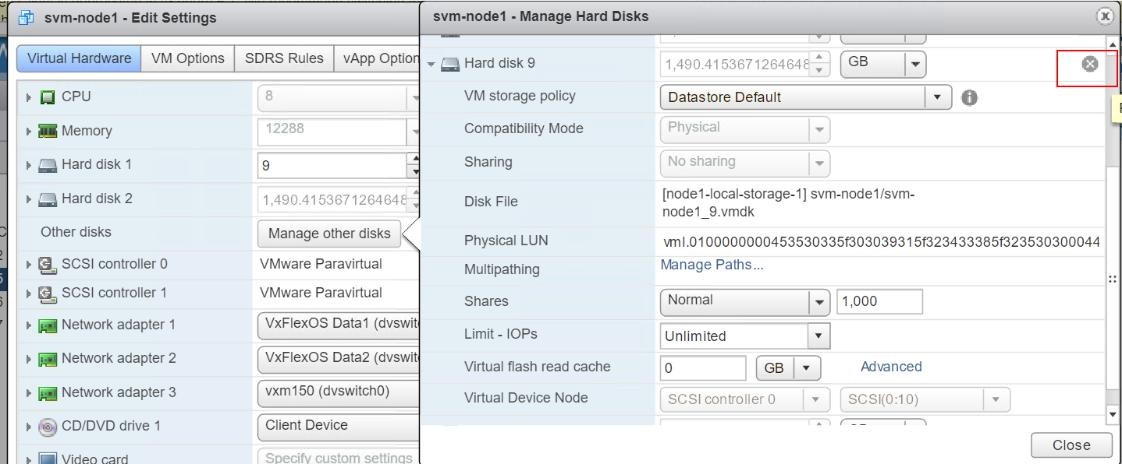

식별자 값이 물리적 LUN 값의 일부로 표시되면 장애가 발생한 디바이스입니다. 그렇지 않은 경우 Manage other disks 를 선택하여 SVM의 다른 하드 드라이브를 보고 해당 물리적 LUN 값을 확인한 다음 Manage Path 를 클릭하여 장애가 발생한 디바이스를 식별합니다.

-

물리적 LUN 값을 사용하여 장애가 있는 디바이스가 있는 하드 드라이브를 식별한 경우 하드 드라이브 오른쪽에 있는 X 를 클릭하여 디바이스를 제거합니다.

Delete files fromdatastore를 선택한 다음 Close를 클릭합니다.

5 - 결함이 있는 NVMe 디스크를 정상 상태의 새 디스크로 물리적으로 교체합니다.

PowerFlex노드에서NVMe디바이스작업중지

- iDRAC에 로그인합니다.

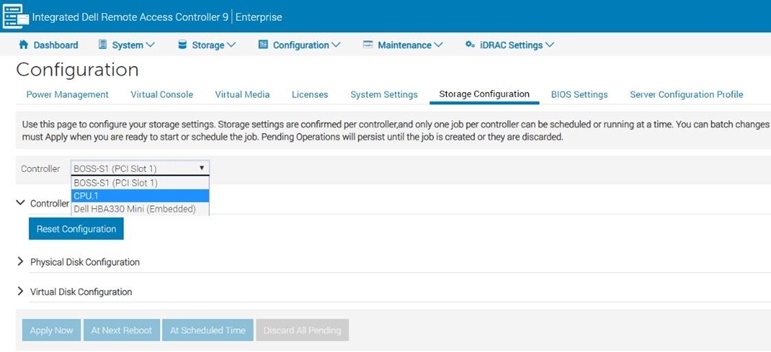

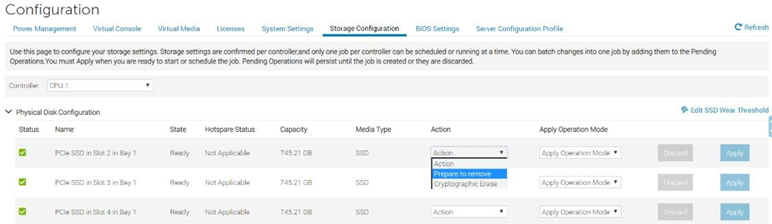

- 기본 메뉴에서 ConfigurationStorage>Configuration을 선택합니다.

- Controller 필드의 서버 모델에 따라 목록에서 적절한 컨트롤러를 선택합니다.

- PowerFlex R650 노드: CPU

- PowerFlex R750 노드: PCIe 확장기

- PowerFlex R6525 노드: PCIe 확장기

- 해당 컨트롤러와 연결된 물리적 드라이브 목록이 있는 새 페이지가 열립니다.

- 교체해야 하는 물리적 드라이브를 선택한 다음 제거 > 준비를 클릭하고 지금 적용합니다.

이제 장애가 발생한 NVMe 디바이스를 서버에서 물리적으로 제거할 수 있습니다.

6 - NVMe 디바이스를 준비하여ESXiserver의PowerFlex시스템에추가

다음 작업을 사용하여 NVMe 디바이스를 사용할 수 있도록 준비하고 ESXi 기반 서버에서 디바이스 슬롯과 작동 경로의 상관 관계를 파악하여 PowerFlex 시스템에 추가합니다.

- 인터넷 브라우저에서 http:// <iDRAC_IP_address>로 이동합니다.

- DELL Console Login 창에서 사용자 이름과 암호를 입력하고 Login을 클릭합니다.

- 기본 메뉴에서 Storage>Overview를 선택한 다음 Physical Disks를 클릭합니다. iDRAC는 서버에 설치된 물리적 드라이브 목록을 표시합니다.

- 슬롯 번호가 방금 교체한 드라이브의 슬롯과 일치하는 행을 찾습니다.

- 왼쪽 열에서 더하기 기호를 클릭하여 드라이브의 고급 속성을 표시합니다.

- 새 드라이브의 일련 번호를 검색하여 기록해 둡니다. 예: 50000396DC89A872입니다.

참고: iDRAC에 드라이브의 일련 번호가 표시되지 않는 경우 교체 드라이브가 잘못 설치되었을 수 있습니다.

- SSH를 사용하여 SVM 에 로그인합니다.

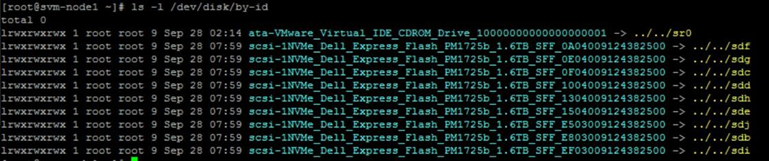

- 다음 명령을 실행하여 운영 체제 디바이스 경로를 확인합니다.

ls -l /dev/disk/by-id/

그러면 다음과 유사한 출력이 표시됩니다.

- 끝에 sdX 가 있는 줄을 찾아 SFFxxxxx번호를 기록해 둡니다.

- 다음 명령을 실행하여 교체 디바이스의 상태를 확인합니다.

esxcli nvme device list그러면 다음과 유사한 출력이 표시됩니다.

- (선택 사항 ) 다음 명령을 실행하여 교체 디바이스의 펌웨어 버전을 확인합니다.

esxcli nvme device get -A vmhbaX | grep -i Revision여기서 vmhbaX 는 새 NVMe 디바이스의 이름입니다.

예를 들어 이전 단계의 이미지에 표시된 교체 디바이스의 경우 명령은 다음과 같습니다.

esxcli nvme device get -A vmhba10 | grep -i Revision실제 펌웨어 버전과 함께 다음과 유사한 출력이 표시됩니다.

펌웨어 버전이 RCM 또는 IC를 준수하는지 확인합니다.

- vmhbaX 디바이스의 어댑터를 찾아 일련 번호를 찾습니다.

esxcli nvme device get -A vmhbaX | grep -i serial예:

esxcli nvme device get -A vmhba10 | grep -i serial출력에는 일련 번호를 포함한 드라이브의 세부 정보가 표시됩니다.

|

7 - (선택 사항)PowerFlex 노드에서새NVMe디바이스를 암호화 합니다. Cloudlink를 사용하지 않는 경우 이 단계를 건너뜁니다.

교체한 NVMe 드라이브가 CloudLink를 사용하여 암호화된 경우 다음 단계를 수행하여 새 NVMe 드라이브를 암호화합니다. 장애가 발생한 드라이브가 암호화되지 않은 경우 이 작업을 건너뜁니다.

- SSH를 사용하여 SDS 노드에 연결합니다.

- 다음 명령을 실행하여 새 드라이브를 암호화합니다.

svm encrypt /dev/nvme<xxx>여기서 NVMe<xxx>는 방금 교체한 디바이스의 이름입니다. 예:

svm encrypt /dev/nvmeXn1약 60초 후에 새 장치가 암호화됩니다.

- 다음 명령을 실행하여 새 디바이스 위치를 확인합니다.

svm status다음과 유사한 출력이 표시되어야 합니다.

State: Connected (server 192.168.150.32)

Group: MG-12 Policy: Manual

AES-NI HW acceleration: Yes

Volumes:

/ unencrypted

/home unencrypted

Devices:

/dev/nvme0n1 encrypted (sds SN:9486948577248625 /dev/mapper/svm_nvme0n1)

/dev/nvme10n1 encrypted (sds SN:948694857725248625/dev/mapper/svm_nvme10n1)

/dev/nvme11n1 encrypted (sds SN:948694857725258625/dev/mapper/svm_nvme11n1)

/dev/nvme12n1 encrypted (raw SN:948694857725268625/dev/mapper/svm_nvme12n1)

/dev/nvme13n1 encrypted (raw SN:948694857725278625/dev/mapper/svm_nvme13n1)

/dev/nvme14n1 encrypted (raw SN:948694857725288625/dev/mapper/svm_nvme14n1)

/dev/nvme15n1 encrypted (raw SN:948694857725298625/dev/mapper/svm_nvme15n1)

/dev/nvme16n1 encrypted (raw SN:948694857725308625/dev/mapper/svm_nvme16n1)

/dev/nvme17n1 encrypted (raw SN:948694857725318625/dev/mapper/svm_nvme17n1)

- /dev/nvmeX 디바이스를 찾아 암호화되었는지 확인한 다음 드라이브 정보 테이블에 새 디바이스 경로를 기록합니다.

예:

/dev/mapper/svm_nvme17n1

8 – 하이퍼 컨버지드 노드의 PowerFlex 시스템에 디바이스 추가

새 NVMe를 RDM으로 SVM에 매핑한 다음 PowerFlex 시스템에 추가합니다.

- 영향을 받는 HCI ESX 호스트에 대한 SSH 세션을 엽니다.

- 다음 명령을 사용하여 ESXi 호스트에 연결된 디스크를 나열합니다.

# ls -l /vmfs/devices/disks- 목록에서 RDM으로 구성할 로컬 디바이스를 식별하고 디바이스 이름을 복사합니다.

참고: 디바이스 이름 앞에 t10이 붙을 가능성이 높습니다. 그리고 t10과 비슷하게 보입니다 . F405E46494C4540046F455B64787D285941707D203F45765 - 디바이스를 RDM으로 구성하고 선택한 대상으로 RDM 포인터 파일을 출력하려면 다음 명령을 실행합니다.

# vmkfstools -z /vmfs/devices/disks/ /vmfs/volumes///_x.vmdk예:

# vmkfstools -z /vmfs/devices/disks/t10.F405E46494C4540046F455B64787D285941707D203F45765 /vmfs/volumes/Datastore2/SVM-1/svm-1_1.vmdk참고: 새로 생성된 RDM 포인터 파일의 크기는 매핑된 원시 디바이스와 동일한 크기로 나타납니다. 이 파일은 더미 파일이며 스토리지 공간을 사용하지 않습니다.

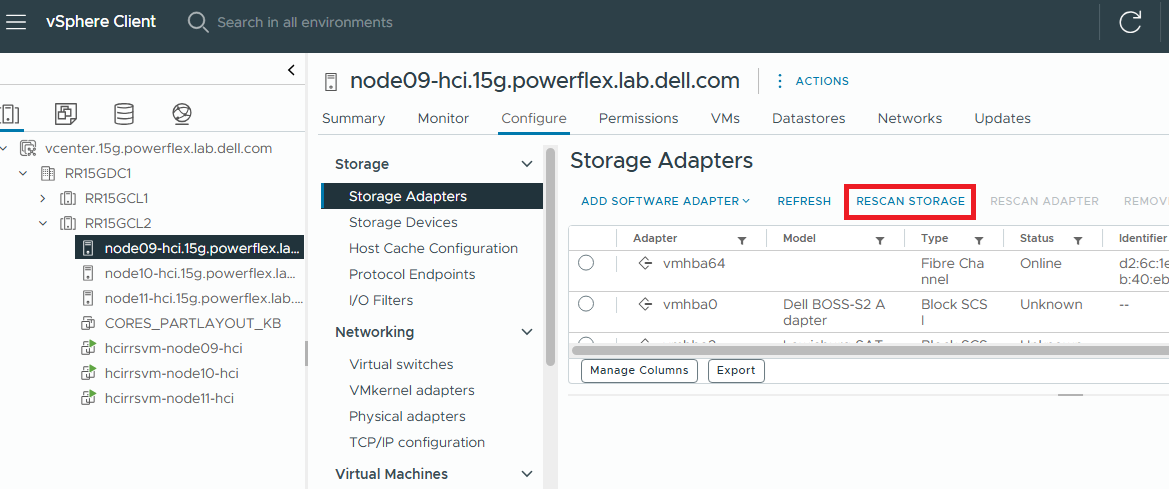

- RDM 포인터 파일을 생성했으면 vSphere Client를 사용하여 RDM을 가상 머신에 연결합니다.

- vSphere Client에서 ESXi 스토리지를 다시 검색하여 추가된 디바이스를 표시합니다.

- 영향을 받는 HCI ESXi 호스트 > 선택 스토리지 어댑터 >스토리지 재검색

- 영향을 받은 HCI ESXi 호스트에 있는 SVM 을 오른쪽 클릭하고 Edit Settings를 선택합니다.

- 오른쪽 상단에서 ADD NEW DEVICE > 를 선택합니다. 기존 하드 디스크

- 하드 디스크를 선택합니다.

- 기존 가상 디스크 사용을 선택합니다.

- 4단계에서 RDM 포인터를 저장한 디렉토리로 이동하여 RDM 포인터 파일을 선택한 후 다음을 클릭하십시오.

- 디스크를 연결할 가상 SCSI 컨트롤러를 선택하고 Next를 클릭합니다.

- Finish를 클릭합니다.

이제 가상 머신 인벤토리에 새 하드 디스크가 매핑된 원시 LUN으로 표시됩니다