PowerEdge: Schaalbaarheid van Dell Ready oplossingen voor HPC BeeGFS-storage

Summary: De Dell BeeGFS High-Performance Storage Solution schalen op basis van capaciteit en/of prestaties/of beide.

Instructions

Inhoudsopgave

- Inleiding

- Basisconfiguraties

- Berekening van bruikbare ruimte bij BeeGFS

- Schaalbare configuraties

- Karakterisering van prestaties

- Conclusie en toekomstig werk

Inleiding

In deze blog bespreken we de schaalbaarheid van Dell Ready Solutions voor HPC BeeGFS Storage , die onlangs is aangekondigd. De BeeGFS-architectuur bestaat uit vier hoofdservices: de beheerservice, de metadataservice, de storageservice en de clientservice. Het is mogelijk om elke combinatie van deze vier hoofddiensten, inclusief alle diensten, op dezelfde server uit te voeren, omdat de rollen en de hardware in het geval van BeeGFS niet nauw zijn geïntegreerd. In een 'Hyper Converged Solution' draaien alle vier de services op dezelfde server. Deze configuratie wordt niet aanbevolen voor prestatiekritieke omgevingen, omdat clienttoepassingen meestal resources verbruiken die van invloed kunnen zijn op de prestaties van de storageservices. De Dell oplossing maakt gebruik van speciale storageservers en een metadata- en storageserver voor twee doeleinden om een krachtige, schaalbare storageoplossing te bieden. Het is mogelijk om het systeem op te schalen door extra opslagservers toe te voegen aan een bestaand systeem. In deze blog presenteren we configuraties met verschillende aantallen storageservers en de prestaties die met deze configuraties kunnen worden verwacht.

Basisconfiguraties

De BeeGFS-storageoplossing, die is ontworpen om een krachtig scratch-bestandssysteem te bieden, maakt gebruik van de volgende hardwarecomponenten:

- Management Server

- R640, Dual Intel Xeon Gold 5218 2,3 GHz, 16 cores, 96 GB (12 x 8 GB 2666 MT/s RDIMM's), 6 x 15k RPM 300 GB SAS, H740P

- Metadata- en storageservers

- R740xd, 2x Intel Xeon Platinum 8268 CPU @ 2,90 GHz, 24 cores, 384 GB (12 x 32 GB 2933 MT/s RDIMM's)

- BOSS-kaart met 2 x 240 GB M.2 SATA SSD's in RAID 1 voor besturingssysteem

- 24x, Intel 1,6 TB, NVMe, Express Flash voor gemengd gebruik, 2,5 SFF-schijven, softwarematige RAID

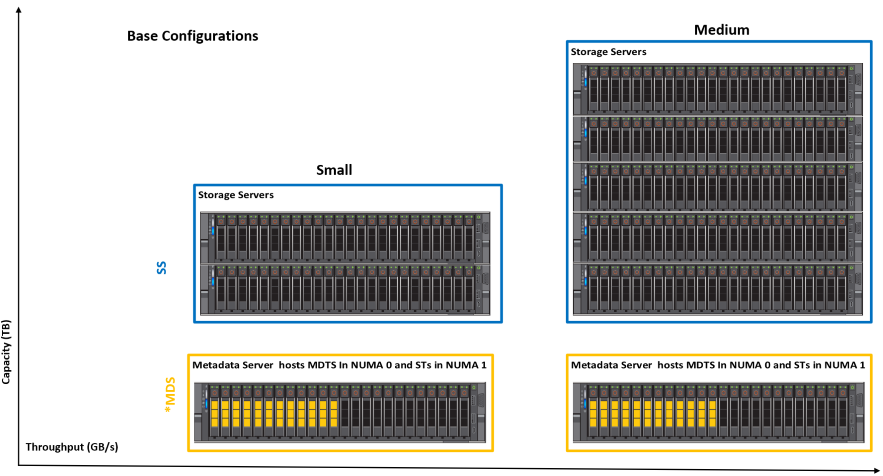

Op de beheerserver wordt de BeeGFS-bewakingsservice uitgevoerd. De metadataserver gebruikt de 12 stations in de NUMA 0-zone om de metadatadoelen (MDT's) te hosten, terwijl de resterende 12 stations in de NUMA 1-zone de storagedoelen (ST's) hosten. Er wordt geen speciale metadataserver gebruikt omdat de storagecapaciteitsvereisten voor BeeGFS-metadata klein zijn. De metadata- en storagedoelen en -services worden geïsoleerd op afzonderlijke NUMA-knooppunten, zodat een aanzienlijke scheiding van workloads tot stand wordt gebracht. De storageservers die in de configuratie worden gebruikt, hebben drie storageservices die per NUMA-zone worden uitgevoerd, zes in totaal per server. Zie de aankondigingsblog voor meer informatie. Afbeelding 1 toont de twee basisconfiguraties die zijn getest en gevalideerd in het Dell EMC HPC en AI Innovation Lab

Afbeelding 1: Basisconfiguraties

De kleine configuratie bestaat uit drie R740xd-servers. Het heeft 15 storagedoelen. De gemiddelde configuratie heeft 6xR740xd servers en heeft 33 storagedoelen. De gebruiker kan beginnen met een "Small" configuratie of met de "Medium" configuratie en kan indien nodig storage- of metadataservers toevoegen om respectievelijk de storageruimte en de algehele prestaties, of het aantal bestanden en de metadataprestaties te verhogen. Tabel 1 toont de prestatiedata voor de basisconfiguraties die uitgebreid zijn getest en gevalideerd in het Dell HPC en AI Innovation Lab.

| Basisconfiguratie | Klein | Gemiddeld | |

|---|---|---|---|

| Totaal U (MDS+SS) | 6U | 12U | |

| # Dedicated Storage Servers | 2 | 5 | |

| # NVMe-schijven voor datastorage | 60 | 132 | |

| Geschatte bruikbare ruimte | 1,6 TB | 86 TiB | 190 TiB |

| 3,2 TB | 173 TiB | 380 TiB | |

| 6,4 TB | 346 TiB | 761 TiB | |

| Piek sequentiële leestijd | 60,1 GB/s | 132,4 GB/s | |

| Piek sequentiële schrijfbewerkingen | 57,7 GB/s | 120,7 GB/s | |

| Willekeurige leesbewerkingen | 1,80 miljoen IOPS | 3,54 miljoen IOPS | |

| Willekeurige schrijfacties | 1,84 miljoen IOPS | 3,59 miljoen IOPS | |

Tabel 1: Capaciteits- en prestatiedetails van basisconfiguraties

Berekening van bruikbare ruimte bij BeeGFS

De geschatte bruikbare ruimte wordt berekend in TiB (aangezien de meeste gereedschappen bruikbare ruimte in binaire eenheden weergeven) met behulp van de volgende formule:

BeeGFS Usable Space in TiB= (0.99* # of Drives* size in TB * (10^12/2^40)

In de bovenstaande formule is 0,99 de factor die wordt verkregen door conservatief aan te nemen dat er een overhead van 1% is van het bestandssysteem. Om tot het aantal schijven voor storage te komen, worden ook 12 schijven uit de MDS meegerekend. Dit komt omdat in de MDS de 12 stations in NUMA-zone 0 worden gebruikt voor metadata en de 12 stations in de NUMA-zone 1 worden gebruikt voor opslag. De laatste factor in de formule 10^12/2^40 is het omrekenen van de bruikbare ruimte van TB naar TiB.

Schaalbare configuraties

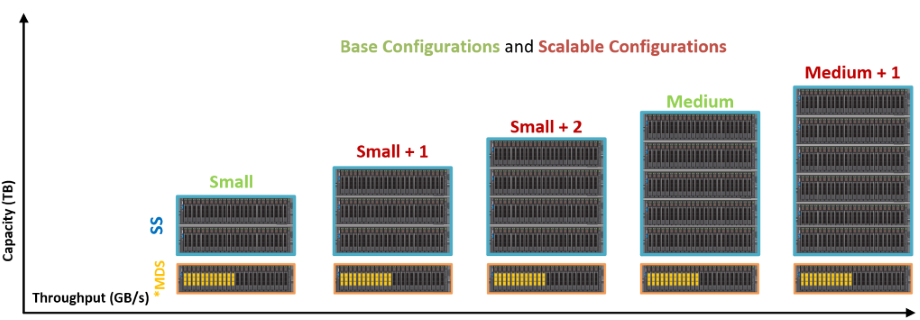

De BeeGFS High-Performance Storage Solution is ontworpen om flexibel te zijn en men kan prestaties en/of capaciteit eenvoudig en naadloos schalen door extra servers toe te voegen, zoals hieronder weergegeven:

Afbeelding 2: Voorbeelden van geschaalde configuratie

Het metadatagedeelte van de stack blijft hetzelfde voor alle bovenstaande configuraties die in deze blog worden beschreven. Dit komt doordat de vereisten voor storagecapaciteit voor BeeGFS-metadata doorgaans 0,5% tot 1% van de totale storagecapaciteit bedragen. Het hangt echter echt af van het aantal mappen en bestanden in het bestandssysteem. Als algemene regel geldt dat de gebruiker een extra metadataserver kan toevoegen wanneer het percentage van de metadatacapaciteit in de opslag minder dan 1% daalt. Tabel 2 toont de prestatiegegevens voor de verschillende flexibele configuraties van de BeeGFS-opslagoplossing.

| Configuratie | Klein | Klein +1 | Klein +2 | Gemiddeld | Gemiddeld +1 | |

|---|---|---|---|---|---|---|

| Totaal U (MDS+SS) | 6U | 8U | 10U | 12U | 14U | |

| # Dedicated Storage Servers | 2 | 3 | 4 | 5 | 6 | |

| # NVMe-schijven voor datastorage | 60 | 84 | 108 | 132 | 156 | |

| Geschatte bruikbare ruimte | 1,6 TB | 86 TiB | 121 TiB | 156 TiB | 190 TiB | 225 TiB |

| 3,2 TB | 173 TiB | 242 TiB | 311 TiB | 380 TiB | 449 TiB | |

| 6,4 TB | 346 TiB | 484 TiB | 622 TiB | 761 TiB | 898 TiB | |

| Piek sequentiële leestijd | 60,1 GB/s | 83,3 GB/s | 105,2 GB/s | 132,4 GB/s | 152,9 GB/s | |

| Piek sequentiële schrijfbewerkingen | 57,7 GB/s | 80,3 GB/s | 99,8 GB/s | 120,7 GB/s | 139,9 GB/s | |

Tabel 2: Capaciteits- en prestatiedetails van geschaalde configuraties

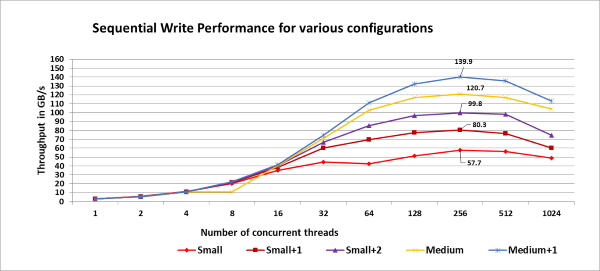

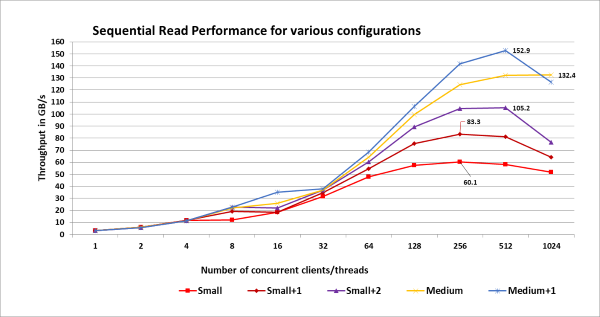

Karakterisering van prestaties

De prestaties van de verschillende configuraties werden getest door storagepools te maken. De kleine configuratie heeft 15 storagedoelen en elke extra storageserver voegt zes extra storagedoelen toe. Om de prestaties van de verschillende configuraties te testen, zijn er storagepools gemaakt van 15 tot 39 storagedoelen (stappen van zes voor small, small+1, small+2, medium, medium+1). Voor elk van deze pools werden drie iteraties van de IOzone-benchmark uitgevoerd, elk met één tot 1024 threads (in machten van twee stappen). De gebruikte testmethodologie is dezelfde als die beschreven in de aankondigingsblog . De afbeeldingen 3 en 4 tonen de schrijf- en leesprestaties van de schaalbare configuraties, waarbij de piekprestaties van beide configuraties zijn gemarkeerd voor directe referentie:

Afbeelding 3: Schrijfprestaties van schaalbare configuraties.

Figuur 4: Leesprestaties van schaalbare configuraties.

Opmerking:

De storagepool waarnaar wordt verwezen, is alleen gemaakt voor het expliciete doel om de prestaties van verschillende configuraties te karakteriseren. Tijdens het uitvoeren van de prestatie-evaluatie van de mediumconfiguratie die in de aankondigingsblog wordt beschreven, bevonden alle 33 doelen zich alleen in de "Default Pool". De output van de beegfs-ctl --liststoragepools De opdracht hieronder toont de toewijzing van de opslagdoelen:

# beegfs-ctl --liststoragepools Pool ID Pool Description Targets Buddy Groups ======= ================== ============================ ============================ 1 Default 1,2,3,4,5,6,7,8,9,10,11,12, 13,14,15,16,17,18,19,20,21, 22,23,24,25,26,27,28,29,30, 31,32,33

Conclusie en toekomstig werk

In deze blog wordt de schaalbaarheid van Dell Ready Solutions voor HPC BeeGFS Storage besproken en de prestaties voor sequentiële lees- en schrijfdoorvoer voor verschillende configuraties belicht. Blijf op de hoogte voor deel 3 van deze blogserie waarin extra functies van BeeGFS worden besproken en het gebruik van "StorageBench" wordt belicht, de benchmark voor ingebouwde storagedoelen van BeeGFS. Als onderdeel van de volgende stappen zullen we later een whitepaper publiceren met de metadataprestaties, prestatie-evaluatie van IOR N-1 en met aanvullende details over ontwerpoverwegingen, afstemming en configuratie.

Verwijzingen

[1] Dell Ready oplossingen voor HPC BeeGFS Storage:

https://www.dell.com/support/article/sln319381/[2] BeeGFS-documentatie:

https://www.beegfs.io/wiki/[3] Hoe sluit ik twee interfaces aan op hetzelfde subnet:

https://access.redhat.com/solutions/30564[4] Referentieontwerp PCI Express Direct Memory Access met extern geheugen: https://www.intel.com/content/www/us/en/programmable/documentation/nik1412547570040.html#nik1412547565760