Article Number: 000179557

Sådan implementerer du Oracle 12c Release 2 Grid og RAC-database på RHEL 7.x

Summary: Trin og billeder for at hjælpe med at udrulle Oracle 12c Release 2 Grid og RAC-database på RHEL 7.x

Article Content

Instructions

1. Software- og hardwarekrav

1.1. Hardwarekrav

- Oracle kræver mindst 8 GB fysisk hukommelse

- Swap-pladsen er proportional med mængden af RAM, der er allokeret til systemet

| RAM | Swap-plads |

| Mellem 1,5 GB og 16 GB | Svarer til RAM-størrelsen |

| Mere end 16 GB | 16 GB |

Hvis du aktiverer HugePages, skal du trække den mængde hukommelse, der er allokeret til HugePages, fra den tilgængelige RAM, før du beregner swap-pladsen

Hvis du aktiverer HugePages, skal du trække den mængde hukommelse, der er allokeret til HugePages, fra den tilgængelige RAM, før du beregner swap-pladsen

- Følgende tabel beskriver diskpladsen, der kræves til en Oracle-installation

| Placering af softwareinstallation | Mindstekrav til diskplads |

| Startside for Grid-infrastruktur | Mindst 8 GB diskplads |

| Startside for Oracle-database | Mindst 6,4 GB diskplads |

| Shared Storage diskplads | Størrelse på database- og flashback-genoprettelsesområde |

- Oracles midlertidige plads (/tmp) skal have en størrelse på mindst 1 GB

- En skærm, der understøtter en opløsning på 1024 x 768 for at få vist Oracle Universal Installer (OUI) korrekt

1.2 Netværkskrav

- Det anbefales at sikre, at hver node indeholder mindst tre netværkskort (NIC'er). Et NIC til offentligt netværk, to NIC'er til private netværk for at sikre høj tilgængelighed for Oracle RAC-klyngen. Hvis du vil bruge Automatic Storage Management (ASM) i klyngen, skal du bruge mindst ét Oracle ASM-netværk. ASM-netværket kan dele netværksgrænsefladen med et privat netværk.

- Navne på offentlige, private og ASM-grænseflader skal være ens på alle noder. Hvis em1 f.eks. bruges som offentlig grænseflade på node 1, skal alle andre noder have em1 som den offentlige grænseflade

- Alle offentlige grænseflader for hver node skal kunne kommunikere med alle noder i klyngen.

- Alle private og ASM-grænseflader for hver node skal kunne kommunikere med alle noder i klyngen

- Værtsnavnet for hver node skal følge standarden for RFC 952 (www.ietf.org/rfc/rfc952.txt). Værtsnavn, der inkluderer en understreg ("_"), er ikke tilladt

1.3. Operativsystemkrav

- Red Hat Enterprise Linux (RHEL) 7.x (Kerne 3.10.0-693.el7.x86_64 eller højere)

1.3.1. Operativsystemets diskpartitionering

Nedenfor er den anbefalede diskpartitioneringsplan, når du installerer RHEL 7 vha. en kickstartfil på lokale harddiske med mindst 1,2 TB plads

part /boot --asprimary --fstype="xfs" --ondisk=sda --size=1024

part pv.1 --size=1 --grow --ondisk=sda --asprimary

volgroup rhel7 pv.1

logvol / --name=root -fstype=xfs --vgname=rhel7 --size=51200

logvol swap --fstype swap --name=swap --vgname=rhel7 --size=17408

logvol /home --name=home --fstype=xfs --vgname=rhel7 --size=51200

logvol /var --name=var -fstype=xfs --vgname=rhel7 --size=20480

logvol /opt --name=opt -fstype=xfs --vgname=rhel7 --size=20480

logvol /tmp --name=tmp -fstype=xfs --vgname=rhel7 --size=5120

logvol /u01 --name=u01 -fstype=xfs --vgname=rhel7 --size=1 --grow

2. Klargøring af servere til installation af Oracle

Før installationen af gitter og databasen skal du sørge for at installere nedenstående implementeringsscripts fra Dell EMC, hvorved der fastlægges rammer for

installationen af Oracle-database.

2.1. Tilknytning af systemer for Red Hat Network (RHN)/Unbreakable Linux Network (ULN)

Alle RPM-forudsætninger skal installeres, før installation af GRID/DB udføres.

Trin 1:

- rhel-7-server-tilvalg-rpms

- rhel-7.x

Opsæt et lokalt yum-lager til automatisk at installere resten af afhængigheds-RPMS til udførelse af GRID/DB-installation

- Den anbefalede konfiguration er at servicere filer over http vha. en Apache-server (pakkenavn: httpd). Dette afsnit omhandler hosting af lagrede filer fra et lokalt lagret filsystem. Der findes andre muligheder for at hoste lagrede filer, men de ligger uden for dette dokuments anvendelsesområde. Det anbefales at bruge lokal lagring af filsystemer til hurtig og nem vedligeholdelse.

mkdir /media/myISO

mount -o loop myISO.iso /media/myISO

- For at installere og konfigurere http-daemon skal du konfigurere maskinen, som skal hoste lageret for alle andre maskiner, til at bruge DVD-billedet lokalt. Opret filen /etc/yum.repos.d/local.repo og indtast følgende:

[local]

name=Local Repository

baseurl=file:///media/myISO

gpgcheck=0

enabled=0

- Vi vil nu installere Apache-servicedæmonen med følgende kommando, som også midlertidigt vil aktivere det lokale lager til opløsningsafhængighed:

yum -y install httpd --enablerepo=lokal

- For at bruge Apache til at fordele resten af lageret, skal du kopiere indholdet af DVD'en og indsætte det i en offentliggjort webmappe. Kør følgende kommandoer som root-kommando (husk at udskifte myISO med navnet på din ISO):

cp -R /media/myISO/* /var/www/html/myISO

- Dette trin er kun nødvendigt, hvis du kører SELinux på serveren, som hoster lageret. Følgende kommando skal køres som root, og gendanner den passende SELinux-kontekst til de kopierede filer:

- Det sidste trin er at samle DNS-navnet eller IP-adressen for serveren, som hoster lageret. DNS-navnet eller IP-adressen for værtsserveren anvendes til at konfigurere din yum-lager-repo-fil på klient-serveren. Følgende er en liste over et konfigurationseksempel via RHEL 7.x-servermedier, og holdes i konfigurationsfilen: /etc/yum.repos.d/myRepo.repo

[myRepo]

name=RHEL 7.x Base ISO DVD

baseurl= http://reposerver.mydomain.com/myISO

enabled=1

gpgcheck=0

- Installer compat-libstdc++ rpm'en manuelt vha. rpm- eller yum-kommando i den mappe, hvor rpm'erne er kopieret.

Eks.: rpm -ivh

yum localinstall -y

Trin 3:

- Installerr compat-libstdcc++ rpms ved at køre følgende kommando

yum install –y compat-libstdc++.i686

yum install –y compat-libstdc++.x86_64

- Download/kopier rpm'erne fra DELL ved at gå til Dell Oracle-implementering RPM'er for Oracle 12cR2 on RHEL7.x for RH til de servere, hvor GRID/DB-installationer skal udføres. Liste over RPM'er er som følger, og download kun nødvendige RPM'er

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm er designet til at gøre følgende

- Deaktivere transparent_hugepages i grub2.cfg

- Deaktivere numa i grub2.cfg

- Oprette Oracle-bruger og -grupper oinstall & dba

- Indstille sysctl-kerneparametre

- Indstille brugergrænser (nofile, nproc, stack) for Oracle-bruger

- Indstille NOZEROCONF=yes i /etc/sysconfig/network-filen

- Oprette grid-bruger og -grupper asmadmin, asmdba, asmoper, backupdba, dgdba, kmdba

- Indstille brugergrænser (nofile, nproc, stack) for Grid-bruger.

- Indstille sysctl-kerneparametre

- Indstille RemoveIPC=no for at sikre, at semaforer angivet for brugere ikke forsvinder, efter at brugeren logger af

- Installer disse to RPM'er

yum localinstall –y dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

2.2. Opsætning af Wi-Fi-netværket

2.2.1. Offentlige netværk

For at konfigurere det offentlige netværk på hver node

- Log ind som root.

- Naviger til /etc/sysconfig/network-scripts, og rediger ifcfg-em# filen, hvor # er nummeret på netværksenheden

NAME="Oracle Public"

DEVICE= ”em1”

ONBOOT=yes

TYPE= Ethernet

BOOTPROTO=statisk

IPADDR=<routable IP address>

NETMASK=<netmask>

GATEWAY=<gateway_IP_address>

- Angiv værtsnavnet via kommandoen nedenfor

hostnamectl set-hostname <host-name>

hvor <host-name> er det værtsnavn, som vi bruger til installation

- Skriv genstart netværkstjeneste for at genstarte netværkstjenesten

- Skriv ifconfig for at verificere, at IP-adresserne er indstillet korrekt

- Hvis du vil kontrollere din netværkskonfiguration, skal du pinge hver offentlige IP-adresse fra en klient på LAN'et, som ikke er en del af klyngen

- Opret forbindelse til hver node for at verificere, at det offentlige netværk fungerer. Tast ssh for at kontrollere, at kommandoen secure shell (ssh) fungerer

2.2.2. Privat netværk

Eksemplet nedenfor indeholder trinvise instruktioner til aktivering af redundant tilslutning ved hjælp af HAIP på en ny installation af Oracle 12c Grid-infrastruktur

- Rediger filen/etc/sysconfig/network-scripts/ifcfg-emX, hvor X er nummeret på em-enhedens ifcfg-emX-konfigurationsfiler til de netværksadaptere, der skal bruges til din private tilslutning.

DEVICE=em2

BOOTPROTO=static

HWADDR=

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.140

NETMASK=255.255.255.0

DEVICE=em3

HWADDR=

BOOTPROTO=static

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.141

NETMASK=255.255.255.0

- Når du har gemt begge konfigurationsfilerne, skal du genstarte din netværksservice vha. nedenstående kommandoer

nmcli connection reload

nmcli device disconnect em2

nmcli connection up em2

- Gentag fremgangsmåden for hver af de grænseflader, der er blevet ændret.

- Gennemførelsen af ovenstående trin har nu forberedt dit system til at aktivere HAIP vha. installationsprogrammet til Oracle Grid-infrastrukturen. Når du har gennemført alle Oracle forudsætninger og er klar til at installere Oracle, skal du vælge em2 og em3 som "private" grænseflader på skærmbilledet "Brug af netværksgrænseflade"

- Dette trin gør det muligt at bruge redundant tilslutning, når din Oracle Grid-infrastruktur er gennemført og kører

2.2.3. Oracle Flex ASM-netværk

Oracle Flex ASM kan bruge enten de samme private netværk som Oracle Clusterware eller bruge dets egne dedikerede private netværk. Hvert netværk kan klassificeres som OFFENTLIGT eller PRIVAT+ASM eller PRIVAT eller ASM

2.2.4. IP-adresse og navnefortolkningskrav

Vi kan konfigurere klyngenodernes IP-adresse med en af følgende opsætninger

- Domænenavnsserver (DNS)

2.2.4,1. Domænenavnsserver (DNS)

Sådan konfigureres en Oracle 12c-RAC ved hjælp af Oracle (uden GNS):

Tabellen nedenfor beskriver de forskellige grænseflader, IP-adresseindstillinger og fortolkningerne i en klynge

|

Interface

|

Type

|

Løsning

|

|

Offentlige

|

Statisk

|

DNS

|

|

Privat

|

Statisk

|

Ikke påkrævet

|

|

ASM

|

Statisk

|

Ikke påkrævet

|

|

Node virtuel IP

|

Statisk

|

Ikke påkrævet

|

|

SCANNING virtuel IP

|

Statisk

|

Ikke påkrævet

|

Konfiguration af en DNS-server

Sådan konfigureres ændringer på en DNS-server for en Oracle 12c-klynge ved hjælp af DNS (uden GNS):

Konfigurer fortolkning af scanningsnavn på DNS-serveren. Et SCANNINGSNAVN, der er konfigureret på DNS-serveren ved hjælp af Round Robin-politikken, skal kunne fortolkes til tre offentlige IP-adresser (anbefales), men minimumskravet er én offentlig IP-adresse

For eksempel

scancluster IN A 192.0.2.1

IN A 192.0.2.2

IN A 192.0.2.3

Hvor scancluster er SCANNINGSNAVNET tildelt under installationen af Oracle-Grid

Konfiguration af DNS-klient

Sådan konfigurerer du de ændringer, der er nødvendige på klyngenoderne til navnefortolkning:

- Du skal konfigurere resolv.conf på noderne i klyngen for at tilbageholde navneserverposter, der kan fortolkes til DNS-serveren.

nmcli connection modify ipv4.dns ipv4.dns-search

- Kontroller, om ordrekonfigurationen /etc/nsswitch.conf styrer navneserviceordren. I nogle konfigurationer kan NIS skabe problemer med Oracle SCANNINGS-adressens fortolkning. Det anbefales, at du placerer NIS-posten sidst på søgelisten.

For eksempel, værter: dns filer nis

3. Klargøring af Delt lagring for Oracle RAC-installation

Oracle RAC kræver delte LUNs, når du skal gemme din OCR (Oracle Cluster Registry), voting disks, Oracle Database-filer og FRA (Flash Recovery Area). Følgende tabel viser den typisk anbefalede opbevaringsmængde for 12c Oracle-database

| Type af databaseenhed/formål | Antal enheder | Enhedsstørrelse |

| OCR/VOTE | 3 | 50 GB hver |

| DATA | 4 | 250 GB1 hver |

| REDO2 | 2 | Mindst 50 GB hver |

| FRA | 1 | 100GB3 |

| MIDL. | 1 | 100 GB |

1 – Juster hver enhedsstørrelse ud fra din database; 2 – Mindst to REDO ASM-diskgrupper anbefales, hver med mindst én lagringsenhed; 3 – Ideelt set bør størrelsen være 1,5x databasens størrelse, hvis lagringens brugbare kapacitet tillader det

vedvarende navnebinding på tværs af noder i klyngen.

3.1. Opsætning af Device Mapper Multipath til XtremIO Storage

Formålet med Device Mapper Multipath er at aktivere flere I/O-stier med henblik på at forbedre ydeevnen og give konsistente navngivning. Multipathing opnår dette ved at kombinere dine I/O-stier i én enhedskortlægningssti og korrekt justering af belastningen for I/O. Dette afsnit oplyser dig om, hvordan du indstiller din enhedskortlægning med flere stier på din Dell PowerEdge-server. Kontroller, at din enhedsmapper og driver med flere stier er mindst den version, der vises nedenfor, eller højere:

- rpm -qa | grep device-mapper-multipath

device-mapper-multipath

- Aktiver MultiPath med mpathconf – enable

- Konfigurer XtremIO Multipath ved at modificere /etc/multipath.conf med følgende

device {

vendor XtremIO

product XtremApp

path_grouping_policy multibus

path_checker tur

path_selector "queue-length 0"

rr_min_io_rq 1

user_friendly_names yes

fast_io_fail_tmo 15

failback immediate

}

- Tilføj passende brugervenlige navne til hver enhed med tilsvarende scsi_id. Scsi_ids nås med kommandoen nedenfor

/usr/lib/udev/scsi_id -g -u -d /dev/sdX

- Find sektionen med flere stier i filen /etc/multipath.conf. I dette afsnit vil du angive scsi_id for hver enhed og angive et alias for at sikre konsistent navngivning på alle dine noder. Et eksempel er vist nedenfor

multipaths {

multipath {

wwid <out put of step4 for volume1>

alias alias_of_volume1

}

multipath {

wwid <out put of step4 for volume2>

alias alias_of_volume2

}

}

- Genstart din dæmonservice med flere stier ved hjælp af

Service multipathd restart

- Kontrollér, at dine enhedsnavne med flere stier vises korrekt

multipath -ll

- Gentag alle tre trin for alle noder

3.2. Partitionering af fællesdisk

Dette afsnit beskriver, hvordan du kan bruge et delt hjælpeprogram til at lave én partition på en enhed/virtuel disk, der dækker hele disken.

Partitionér hver databaseenhed, der blev installeret ved hjælp af device-mapper ved at køre følgende kommando:

$> parted -s /dev/mapper/<volume1> mklabel msdos

$> parted -s /dev/mapper/<volume1> primary 2048s 100%

Gentag dette for alle de nødvendige enheder

-

Gentag ovenstående trin for alle enheder, og genstart multipathd på alle andre noder

systemctl restart multipathd.service

-

Genstart systemet, hvis din nyligt oprettede partition ikke vises korrekt

3.3 Brug af udev-regler for disktilladelser og udholdenhed

Red Hat Enterprise Linux 7.x har mulighed for at bruge udev-regler for at sikre, at systemet korrekt administrerer tilladelser for enhedsnoder. I dette tilfælde omhandler det korrekt indstilling af tilladelser til vores LUN/enheder opdaget af OS. Det er vigtigt at bemærke, at udev-regler implementeres i nævnt rækkefølge. Ved oprettelse af udev-regler for indstilling af tilladelser, skal du inkludere præfiks 60- og vedhæfte .rules til slutningen af filnavnet.

- Opret en fil 60-oracle-asmdevices.rules under /etc/udev/rules.d

- Kontroller, at hver blokenhed har en post i filen som vist nedenfor

#---------------------start udev rule contents ------------------------#

KERNEL=="dm-*", ENV =="C1_OCR1p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR2p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR3p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA1p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA2p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA3p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA4p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO1p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO2p?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_FRA?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_TEMP?", EJER:="grid", GRUPPE:="asmadmin", MODE="0660"

- Kør "udevadm trigger" for at anvende reglen.

- Kopiér udev-reglerne til alle noderne, og kør udevadm trigger for at anvende reglerne

4. Installation af Oracle 12c Grid-infrastruktur for en klynge

4.1 Konfigurer systemets urindstillinger for alle noder

For at undgå fejl under installationsproceduren skal du konfigurere alle noderne med identiske system-urindstillinger. Synkroniser dit nodesystemur med tjenesten Cluster Time Synchronization Service (CTSS), som er indbygget i Oracle 12c. For at aktivere CTSS skal du deaktivere operativsystemets Network Time Protocol Daemon (ntpd)-tjenesten ved hjælp af følgende kommandoer i denne rækkefølge:

-

systemctl stop chronyd.service

-

systemctl disable chronyd.service

-

mv /etc/chrony.conf /etc/ntp.chrony.orig

De følgende trin er for node ét i dit klyngemiljø, medmindre andet er angivet.

- Log ind som root.

- Hvis du ikke er i et grafisk miljø, skal du starte X Window-systemet ved at taste: startx

- Åbn et terminalvindue, og tast: xhost +

- Monter Oracle Grid-infrastruktur-mediet.

- Log ind som Grid-bruger, f.eks.: su – grid.

- Skriv følgende kommando for at starte Oracle Universal Installer: /runInstaller

- I vinduet Vælg konfigurationsindstilling skal du vælge Konfigurer Grid-infrastruktur for en klynge og klikke på Næste

- I vinduet Klyngekonfiguration skal du vælge Konfigurer en Oracle standalone-klynge og klikke på Næste.

- I vinduet Grid plug and play-information, skal du indtaste følgende oplysninger:

-

Klyngenavn—Indtast et navn til din klynge

-

SCANNINGS-navn – Indtast det navngivne navn registreret i DNS-serveren, som er unikt for hele klyngen. Du kan finde flere oplysninger om, hvordan du konfigurerer dit SCANNINGS-navn, under "IP-adresse og navnefortolkningskrav.

-

SCANNINGS-port – behold standardporten 1521.

-

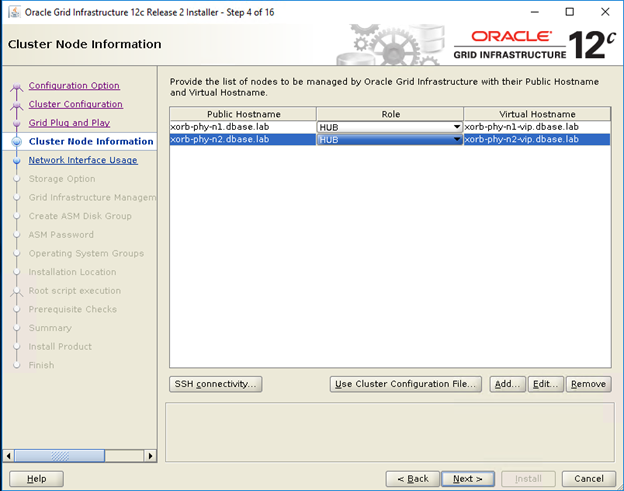

- I vinduet Klyngenodeinformation skal du klikke på Tilføj for at tilføje yderligere noder, der skal administreres af Oracle Grid-infrastrukturen.

- Indtast information om offentlig værtsnavn for Hub- og Leaf-klynge medlemsnoderne

- Indtast rollen som klyngemedlemsnode.

- Gentag ovenstående 3 trin for hver node i klyngen.

- Klik på SSH-forbindelse og konfigurer SSH-forbindelse uden adgangskode ved at indtaste OS-adgangskoden til Grid-brugeren og klikke på Setup.

- Klik på OK, og klik på Næste for at gå til næste vindue.

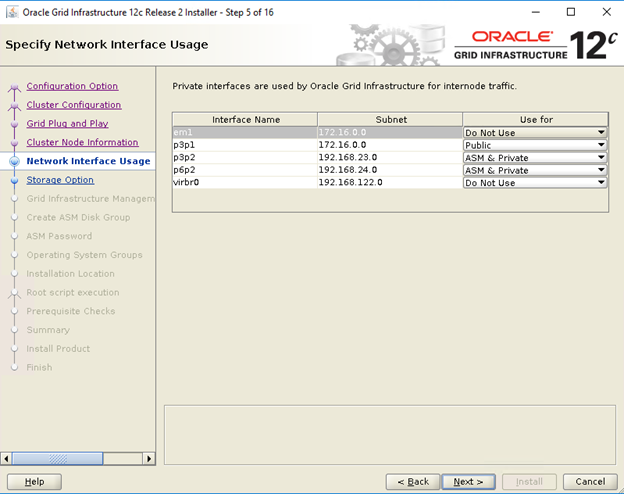

- I vinduet Angiv anvendelse af netværksgrænseflade skal du sørge for, at de korrekte grænsefladeanvendelsestyper er valgt for grænsefladenavnene. På rullelisten 'Anvend til' skal du vælge den ønskede grænsefladetype. De tilgængelige muligheder er offentlig, privat, ASM, ASM og privat. Klik på Næste.

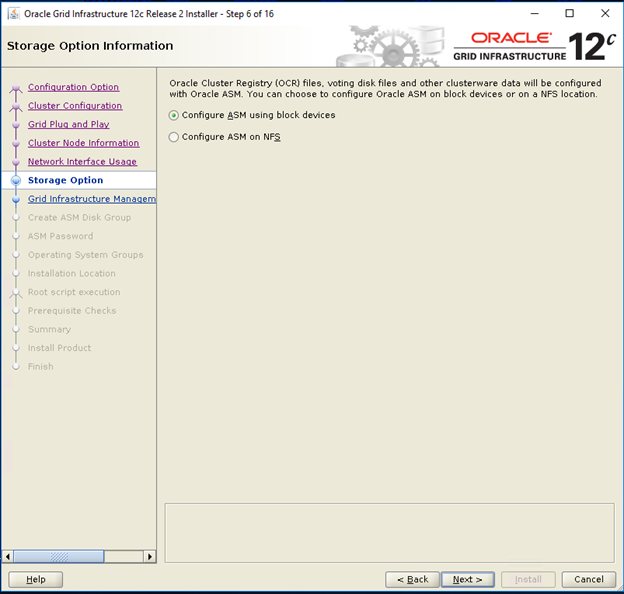

- I vinduet Storage-oplysninger skal du vælge Konfigurer ASM vha. blokenheder og klikke på Næste.

- I vinduet Grid-infrastrukturstyringslager skal du vælge Nej til Konfigurer Grid-infrastrukturstyring og klikke på Næste.

- I vinduet Opret ASM-diskgruppe skal du indtaste følgende oplysninger:

-

Diskgruppenavn – Indtast et navn, for eksempel: OCR

-

Redundans – Til din OCR og voting diske skal du vælge Høj, hvis der er fem ASM-diske til rådighed, vælg Normal, hvis der er tre ASM-diske til rådighed, eller vælg Ekstern, hvis der er én ASM-disk til rådighed (anbefales ikke).

-

- I vinduet ASM-adgangskode skal du vælge den relevante mulighed under Angiv adgangskoder til disse konti og indtaste de relevante værdier for adgangskoden. Klik på Næste.

- I vinduet Fejlisoleringssupport skal du vælge Brug ikke Intelligent Platform Management Interface (IPMI)

- I vinduet Angiv indstilling for administration skal du vælge standard og klikke på Næste

- I vinduet Priviligerede OS-grupper, skal du vælge:

-

asmdba til Oracle ASM DBA-gruppen (OSASM)

-

asmoper til Oracle ASM-operatørgruppen (OSOPER)

-

asmdba til Oracle ASM-administratorgruppen (OSDBA)

-

- I vinduet Angiv installationsplacering skal du angive værdierne i din Oracle basis- og software-placering som konfigureret i Dell Oracle utilities RPM

- Oracle Base -/u01/app/grid

- Software-placering – /u01/app/12.1.0/grid_1

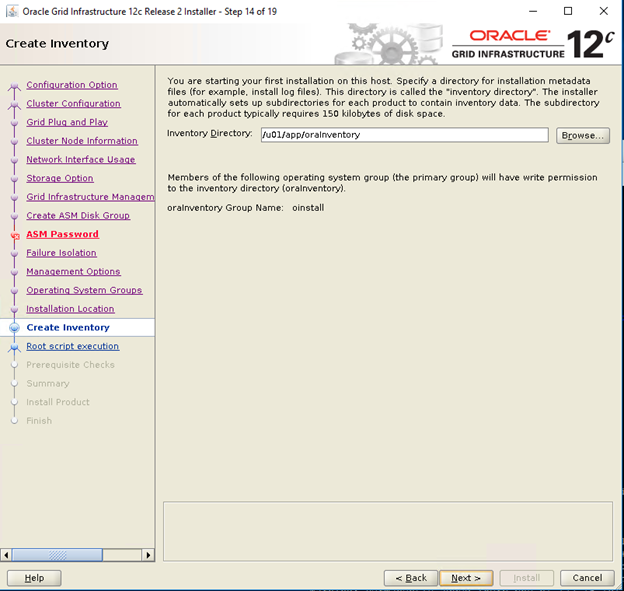

- I vinduet Opret lager skal du angive placeringen af din lagermappe. Klik på Næste.

Standardplacering baseret på Dell Oracle utilites RPM for lagermappen er /u01/app/oraInventory

Standardplacering baseret på Dell Oracle utilites RPM for lagermappen er /u01/app/oraInventory

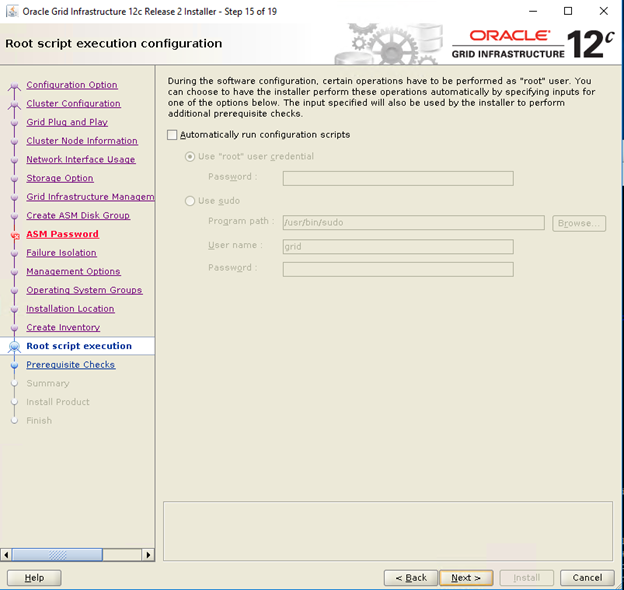

- I vinduet Udførelse af rootscriptkonfiguration skal du fravælge Kør scriptkonfiguration automatisk og klikke på Næste

- I vinduet Oversigt skal du kontrollere alle indstillingerne og vælge Installér

- I vinduet Installér produkt skal du kontrollere status for installationen af Grid-infrastrukturen

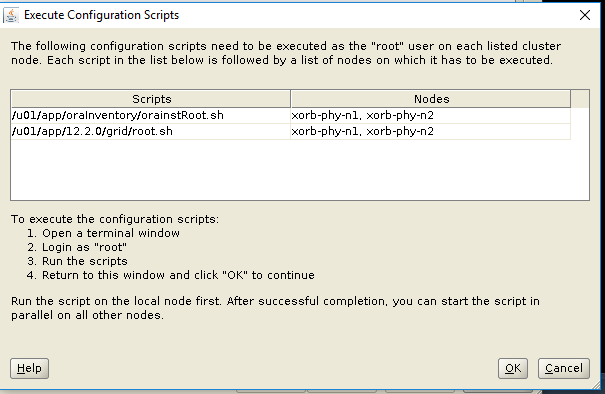

- I vinduet Udfør konfigurationsscripts skal du udføre root.sh-scripts på begge noder og klikke på OK.

- I vinduet Afslut skal du klikke på Luk

5. Sådan installeres Oracle 12c-databasen

5.1. Sådan installeres Oracle 12c-database (RDBMS) software

De følgende trin er for node 1 i dit klyngemiljø, medmindre andet er angivet.

- Log ind som rod og indtast: xhost+.

- Opsæt medier for Oracle Database 12c.

- Log ind som Oracle-bruger ved at indtaste: su - oracle

- Kør installationsscriptet fra dit Oracle-databasemedie:

<CD_mount>/runInstaller

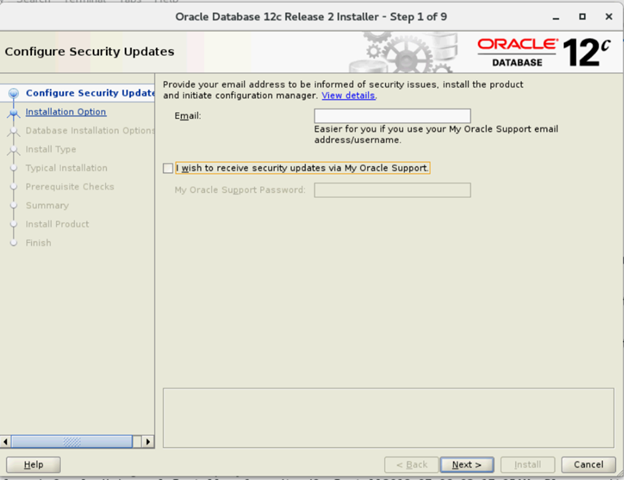

- I vinduet Konfigurer sikkerhedsopdateringer skal du indtaste dine "My Oracle Support"-detaljer for at modtage sikkerhedsopdateringer, ellers klik på Næste

- I vinduet Vælg installationsindstilling skal du vælge Installer kun databasesoftware.

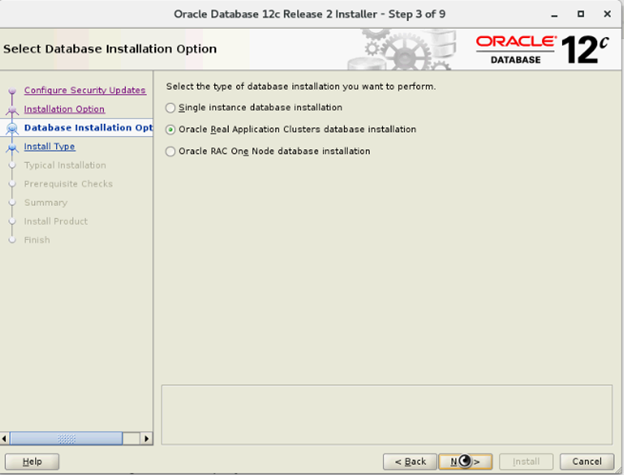

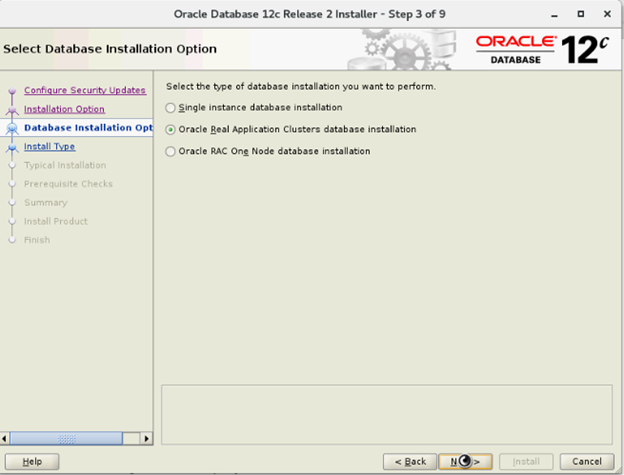

- I vinduet Vælg indstillinger for databaseinstallation skal du vælge Oracle Real Application Clusters-databaseinstallation og klikke på Næste

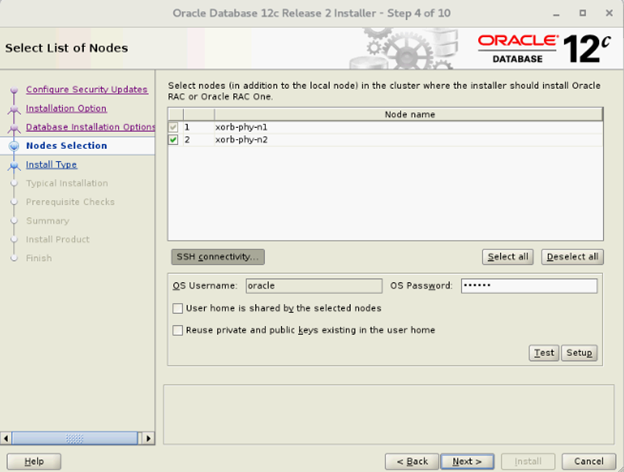

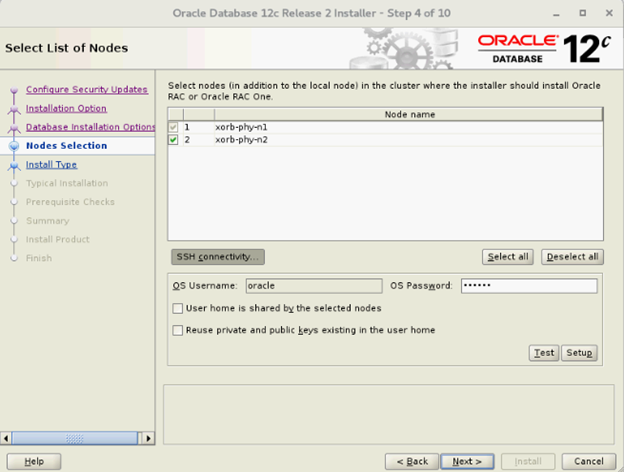

- I vinduet Vælg liste over noder skal du vælge alle Hub-noderne og udelade Leaf-noder og klikke på SSH-forbindelse og konfigurere SSH-forbindelsen uden adgangskode ved at indtaste OS-adgangskoden til Oracle-brugeren og vælge Opsætning. Klik på OK, og klik på Næste for at gå til det næste vindue

- I vinduet Vælg indstillinger for databaseinstallation skal du vælge Oracle Real Application Clusters-databaseinstallation og klikke på Næste

- I vinduet Vælg liste over noder skal du vælge alle Hub-noderne og udelade Leaf-noder og klikke på SSH-forbindelse og konfigurere SSH-forbindelsen uden adgangskode ved at indtaste OS-adgangskoden til Oracle-brugeren og vælge Opsætning. Klik på OK, og klik på Næste for at gå til det næste vindue

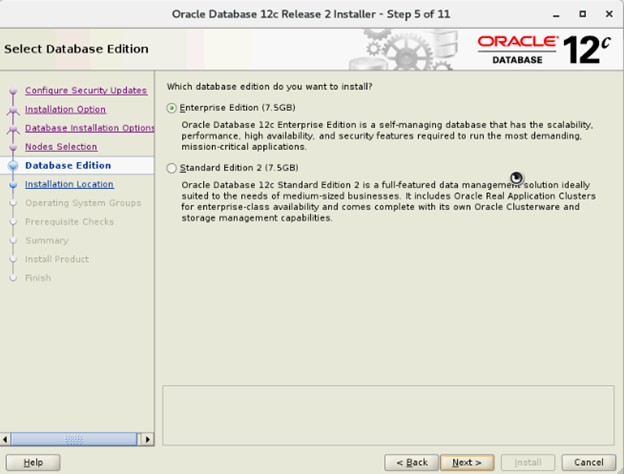

- I vinduet Vælg Database Edition skal du vælge Enterprise Edition og klikke på Næste

- I vinduet Angiv installationsplacering skal du angive placeringen af din Oracle Base som konfigureret i Dell Oracle utilities RPM

- Oracle Base—/u01/app/oracle

- Software-placering—/u01/app/oracle/product/12.1.0/dbhome_2

- I vinduet Privilegerede OS-grupper skal du vælge dba til databaseadministratorgruppen (OSDBA), dba til databaseoperatørgruppen (OSOPER), backupdba til gruppen database-backup og -gendannelse (OSBACKUPDBA), dgdba til gruppen databeskyttelsesadministration (OSDGDBA) og kmdba til gruppen krypteringsnøgleadministration (OSKMDBA) og klikke på Næste.

- I vinduet Oversigt skal du kontrollere indstillingerne og vælge Installér

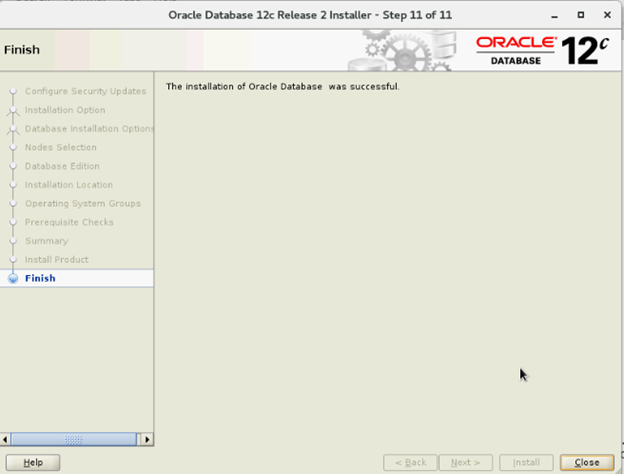

- Når installationsprocessen er afsluttet, vises guiden Udfør konfigurationsscripts. Følg instruktionerne i guiden, og klik på OK.

- I vinduet Afslut skal du klikke på Luk

6. Opret diskgrupper vha. ASMCA (ASM Configuration Assistant)

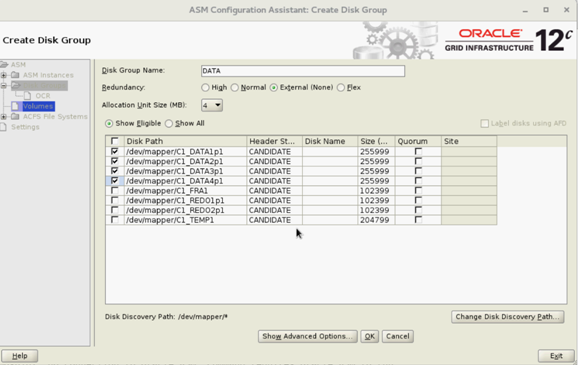

Dette afsnit indeholder fremgangsmåder for oprettelse af ASM-diskgruppen til databasefilerne og Flashback Recovery Area (FRA).

- Log på som Grid-bruger start asmca fra /u01/app/12.2.0/grid/bin/asmca

- Opret "DATA"-diskgruppe med ekstern redundans ved at vælge egnede kandidatdiske

- Opret to "REDO"-diskgrupper – REDO1 og REDO2 – med eksterne redundans ved at vælge mindst én kandidatdisk pr. REDO-diskgruppe

- Opret "FRA"-diskgruppe med ekstern redundans ved at vælge egnede kandidatdiske

- Opret "TEMP"-diskgruppe med ekstern redundans ved at vælge egnede kandidatdiske

- Kontrollér alle nødvendige diskgrupper, og klik på Afslut for at lukke fra hjælpeprogrammet ASMCA

- Skift ASM-striping til finkornet for REDO-, TEMP- OG FRA-diskgrupper som en gitterbruger vha. nedenstående kommandoer

SQL> ALTER DISKGROUP REDO ALTER TEMPLATE onlinelog ATTRIBUTES (fine)

SQL> ALTER DISKGROUP TEMP ALTER TEMPLATE tempfile ATTRIBUTES (fine)

7. Oprettelse af database med DBCA

De følgende trin er gældende for node 1 i dit klyngemiljø, medmindre andet er angivet:

- Log på som Oracle-bruger

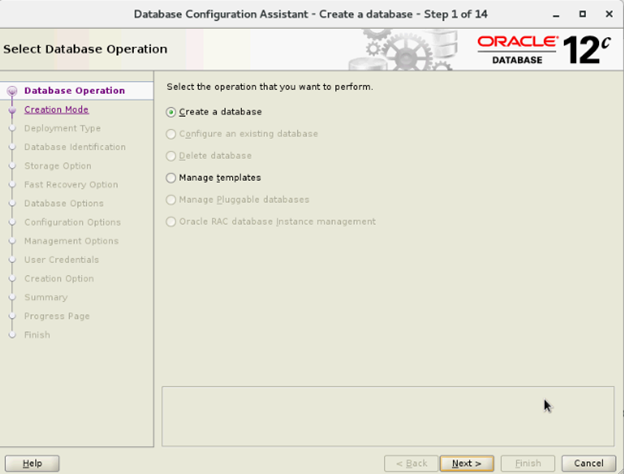

- Kør hjælpeprogrammet DBCA fra $ ved at skrive: $/bin/dbca

- I vinduet Vælg driftstilstand for database skal du vælge Opret database og klikke på Næste

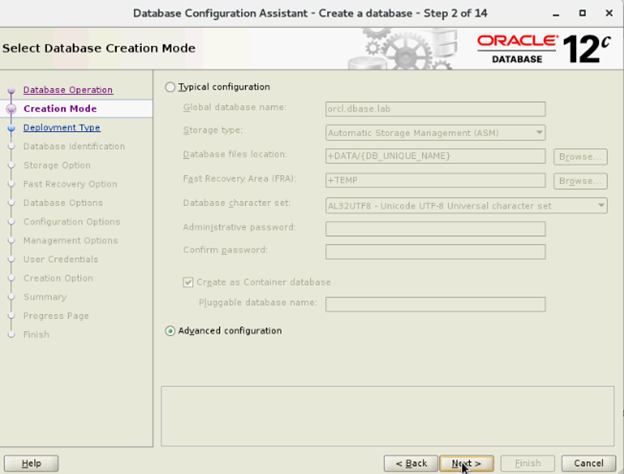

- I vinduet Vælg oprettelsestilstand skal du vælge Avanceret tilstand og klikke på Næste

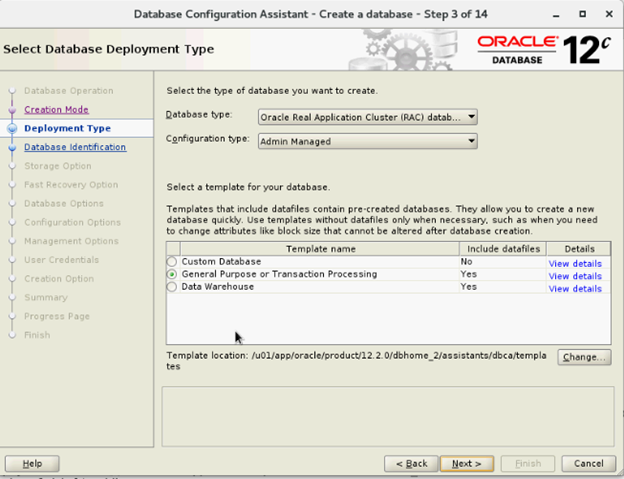

- I vinduet Vælg databaseimplementering skal du vælge Oracle RAC-database (Real Application Cluster) i databasetypen og vælge admin-styret som konfigurationstype og vælge template og klikke på Næste

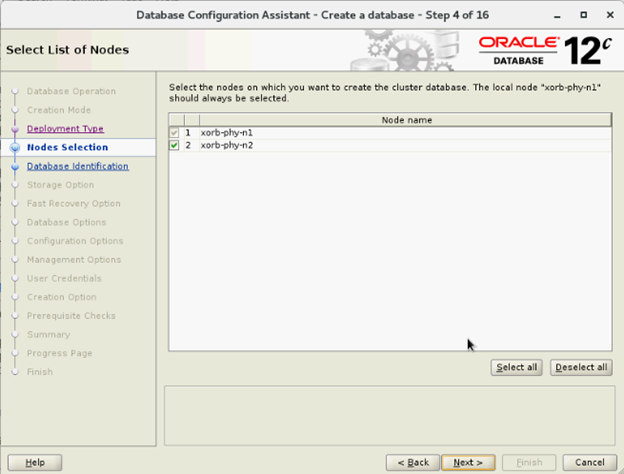

- I vinduet Vælg nodeliste skal du vælge noder og klikke på Næste

- I vinduet Angiv databaseidentifikationsoplysninger:

- I vinduet Storage-indstillinger skal du vælge Lagerplacering af datafiler og fjerne markeringen i Brug Oracle-styrede filer (OMF) og klikke på Næste

- I vinduet Vælg hurtig gendannelsesfunktion skal du vælge Angiv placering til hurtig gendannelses og klikke på Næste

- I vinduet Vælg bokskonfiguration for Oracle-data skal du vælge standardværdier og klikke på Næste

- I vinduet Angiv konfigurationsindstillinger skal du angive påkrævede SGA- og PGA-værdier og klikke på Næste

- I vinduet Vælg indstilling for administration skal du vælge Standard og klikke på Næste

- I vinduet Angiv legitimationsoplysninger for databasebruger skal du indtaste adgangskoden og klikke på Næste

- I vinduet Vælg oprettelsesindstillinger for database skal du klikke på Tilpas lagerpladser

- Opret/rediger grupperne Fortryd log (Redo Log) ud fra følgende anbefalede design

| Redo Log-gruppenummer | Trådnummer | Beliggenhed for diskgruppe | Redo Log-størrelse |

| 1 | 1 | +REDO1 | 5 GB |

| 2 | 1 | +REDO2 | 5 GB5 GB |

| 3 | 1 | +REDO1 | 5 GB |

| 4 | 1 | +REDO2 | 5 GB |

| 5 | 2 | +REDO1 | 5 GB |

| 6 | 2 | +REDO2 | 5 GB |

| 7 | 2 | +REDO1 | 5 GB |

| 8 | 2 | +REDO2 | 5 GB |

- I vinduet Oversigt skal du klikke på Afslut for at oprette databasen

- Klik på Luk i vinduet Afslut, når databaseoprettelsen er afsluttet

Article Properties

Affected Product

Red Hat Enterprise Linux Version 7

Last Published Date

21 Feb 2021

Version

4

Article Type

How To