Article Number: 000179557

Procedure voor het implementeren van Oracle 12c release 2 Grid en RAC Database op RHEL 7.x

Summary: Stappen en afbeeldingen voor hulp bij de implementatie van Oracle 12c release 2 Grid en RAC Database op RHEL 7.x

Article Content

Instructions

1. Software- en hardwarevereisten

1.1. Hardwarevereisten

- Voor Oracle is minimaal 8 GB fysiek geheugen vereist

- De wisselruimte staat in verhouding tot de hoeveelheid RAM die aan het systeem is toegewezen

| RAM | Wisselruimte |

| Tussen 1,5 GB en 16 GB | Gelijk aan grootte van RAM |

| Meer dan 16 GB | 16GB |

Als u HugePages inschakelt, moet u het geheugen dat is toegewezen aan HugePages van de beschikbare RAM aftrekken voordat u de wisselruimte berekent

Als u HugePages inschakelt, moet u het geheugen dat is toegewezen aan HugePages van de beschikbare RAM aftrekken voordat u de wisselruimte berekent

- De volgende tabel beschrijft de schijfruimte die nodig is voor een Oracle-installatie

| Locatie software-installatie | Minimum schijfruimtevereisten |

| Basislocatie Grid Infrastructure | Minimaal 8 GB schijfruimte |

| Basislocatie Oracle Database | Minimaal 6,4 GB schijfruimte |

| Ruimte op gedeelde storageschijf | Grootte van Database en Flashback Recovery Area |

- De tijdelijke ruimte van Oracle (/tmp) moet ten minste 1 GB groot zijn

- Een monitor die een resolutie van 1024 x 768 ondersteunt om de Oracle Universal Installer (OUI) correct weer te geven

1.2. Netwerkvereisten

- Het wordt aanbevolen om ervoor te zorgen dat elk knooppunt minimaal drie netwerkinterfacekaarten (NIC's) bevat: één NIC voor openbare netwerken, twee NIC's voor particuliere netwerken, om te zorgen voor een optimale beschikbaarheid van het Oracle-RAC-cluster. Als u de functie voor automatisch storagebeheer (ASM) in het cluster wilt gebruiken, hebt u minimaal één Oracle-ASM-netwerk nodig. Het ASM-netwerk kan de netwerkinterface delen met een particulier netwerk.

- De namen van openbare, particuliere en ASM-interfaces moeten op alle knooppunten hetzelfde zijn. Als em1 bijvoorbeeld wordt gebruikt als de openbare interface op knooppunt één, is voor alle andere knooppunten em1 als de openbare interface vereist.

- Alle openbare interfaces voor elk knooppunt moeten kunnen communiceren met alle knooppunten in het cluster.

- Alle particuliere en ASM-interfaces voor elk knooppunt moeten kunnen communiceren met alle knooppunten in het cluster.

- De hostnaam van elk knooppunt moet voldoen aan de RFC 952 standaard (www.ietf.org/rfc/rfc952.txt). Hostnamen met een onderstrepingsteken ("_") zijn niet toegestaan

1.3. Vereisten voor het besturingssysteem

- Red Hat Enterprise Linux (RHEL) 7.x (kernel 3.10.0-693.el7.x86_64 of hoger)

1.3.1. Schijfpartitie besturingssysteem

Hieronder vindt u de aanbevolen stappen voor schijfpartitionering bij het installeren van RHEL 7 vanaf een kickstart-bestand op de lokale HDD's met minimaal 1,2 TB beschikbare ruimte:

part /boot --asprimary --fstype="xfs" --ondisk=sda --size=1024

part pv.1 --size=1 --grow --ondisk=sda --asprimary

volgroup rhel7 pv.1

logvol / --name=root --fstype=xfs --vgname=rhel7 --size=51200

logvol swap --fstype swap --name=swap --vgname=rhel7 --size=17408

logvol /home --name=home --fstype=xfs --vgname=rhel7 --size=51200

logvol /var --name=var --fstype=xfs --vgname=rhel7 --size=20480

logvol /opt --name=opt --fstype=xfs --vgname=rhel7 --size=20480

logvol /tmp --name=tmp --fstype=xfs --vgname=rhel7 --size=5120

logvol /u01 --name=u01 --fstype=xfs --vgname=rhel7 --size=1 --grow

2. Servers voorbereiden voor Oracle-installatie

Voordat u Grid en Database installeert, moet u de onderstaande implementatiescripts van Dell EMC uitvoeren om de omgeving te creëren voor

installatie van de Oracle-database.

2.1. Systemen toevoegen aan de Red Hat Network (RHN)/Unbreakable Linux Network (ULN) Repository

Er moet aan alle RPM-installatievereisten zijn voldaan voordat een GRID/DATABASE-installatie kan worden uitgevoerd.

Stap 1:

- rhel-7-server-optional-rpms

- rhel-7.x

Een lokale yum-repository instellen om de overige afhankelijke RPM's automatisch te installeren voor het uitvoeren van de GRID/DB-installatie

- De aanbevolen configuratie is om de bestanden via http beschikbaar te stellen via een Apache-server (pakketnaam: httpd). In dit gedeelte wordt het hosten van de repository-bestanden vanaf een lokale bestandssysteem-storagelocatie besproken. Hoewel er andere opties voor het hosten van repository-bestanden bestaan, vallen deze buiten het kader van dit document. Het wordt sterk aangeraden om lokale bestandssysteemstorage te gebruiken vanwege de snelheid en het eenvoudige onderhoud.

mkdir /media/myISO

mount -o loop myISO.iso /media/myISO

- Als u de HTTP Daemon wilt installeren en configureren, configureert u de computer waarop de repository voor alle andere machines wordt gehost om de dvd-image lokaal te gebruiken. Maak het bestand /etc/yum.repos.d/local.repo en voer het volgende in:

[local]

name=Local Repository

baseurl=file:///media/myISO

gpgcheck=0

enabled=0

- Nu gaan we de Apache service daemon installeren met de volgende opdracht, waardoor de lokale repository ook tijdelijk wordt ingeschakeld voor Dependency Resolution:

yum -y install httpd --enablerepo=local

- Als u Apache wilt gebruiken om de repository te distribueren, kopieert u de inhoud van de dvd naar een gepubliceerde webdirectory. Voer de volgende basisopdrachten uit (zorg dat myISO met de naam van uw ISO wordt ingeschakeld):

cp -R /media/myISO/* /var/www/html/myISO

- Deze stap is alleen nodig als u SELinux uitvoert op de server waarop de repository wordt gehost. De volgende opdracht moet worden uitgevoerd als basis om de juiste SELinux context terug te zetten naar de gekopieerde bestanden:

- De laatste stap is de DNS-naam of het IP-adres van de server ophalen waarop de repository wordt gehost. De DNS-naam of het IP-adres van de hosting server wordt gebruikt voor de configuratie van uw yum repository repo-bestand op de clientserver. Onderstaande lijst is een voorbeeldconfiguratie met de RHEL 7.x Server-media, zoals vervat in het configuratiebestand: /etc/yum.repos.d/myRepo.repo

[myRepo]

name=RHEL 7.x Base ISO DVD

baseurl= http://reposerver.mydomain.com/myISO

enabled=1

gpgcheck=0

- Installeer de compat-libstdc++ RPM handmatig met de opdracht rpm of yum in de map waar de RPM's in worden gekopieerd.

Bijv.: rpm -ivh

yum localinstall -y

Stap 3:

- Installeer de compat-libstdcc++ RPM's door de volgende opdracht uit te voeren:

yum install –y compat-libstdc++.i686

yum install –y compat-libstdc++.x86_64

- Download/Kopieer de RPM's die door DELL worden geleverd door naar Dell Oracle RPM’s voor implementatie van Oracle 12cR2 op RHEL7.x te gaan, voor RH, op de servers waar GRID/DB-installaties zullen worden uitgevoerd. De lijst met RPM's is als volgt; download alleen de noodzakelijke RPM's

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm is ontworpen om het volgende te doen:

- Uitschakelen van transparent_hugepages in grub2.cfg

- Uitschakelen van numa in grub2.cfg

- Oracle-gebruikers en -groepen oinstall & DBA maken

- Parameters voor sysctl-kernel instellen

- Gebruikerslimieten instellen (nofile, nproc, stack) voor Oracle-gebruiker

- Set NOZEROCONF=yes in /etc/sysconfig/network file

- Gebruikers en groepen voor Grid maken: asmadmin, asmdba, asmoper, backupdba, dgdba, kmdba

- Gebruikerslimieten instellen (nofile, nproc, stack) voor Grid-gebruiker

- Parameters voor sysctl-kernel instellen

- Set RemoveIPC=no om ervoor te zorgen dat de semaforen die zijn ingesteld voor gebruikers niet verloren gaan nadat de gebruiker zich heeft afgemeld

- Installeer deze twee RPM's

yum localinstall –y dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

2.2. Het netwerk instellen

2.2.1. Openbaar netwerk

Zo configureert u het openbare netwerk op elk knooppunt:

- Meld u aan als root.

- Ga naar /etc/sysconfig/network-scripts en bewerk het ifcfg-em#-bestand, waarbij # staat voor het nummer van het netwerkapparaat

NAME="Oracle Public"

DEVICE= "em1"

ONBOOT=yes

TYPE= Ethernet

BOOTPROTO=static

IPADDR=<routeerbaar IP-adres>

NETMASK=<netmask>

GATEWAY=<gateway_IP_adres>

- Stel de hostnaam in via de onderstaande opdracht

hostnamectl set-hostname <host-naam>

waarbij <host-naam> de hostnaam is die we gebruiken voor de installatie

- Typ service network restart om de netwerkservice opnieuw te starten

- Typ ifconfig om te controleren of de IP-adressen correct zijn ingesteld

- Om uw netwerkconfiguratie te controleren, pingt u elk openbaar IP-adres van een client op het LAN dat geen deel uitmaakt van het cluster

- Maak verbinding met elk knooppunt om te controleren of het openbare netwerk werkt. Typ ssh om te controleren of de secure shell (SSH)-opdracht werkt

2.2.2. Particulier netwerk

Het onderstaande voorbeeld biedt stapsgewijze instructies voor het inschakelen van Redundant Interconnect met behulp van HAIP op een nieuwe installatie van Oracle 12c Grid Infrastructure

- Bewerk het bestand /etc/sysconfig/network-scripts/ifcfg-emX, waarbij X het nummer is van het em-apparaat, ifcfg-emX de configuratiebestanden van de netwerkadapters die moeten worden gebruikt voor uw particuliere interconnect-verbinding.

DEVICE=em2

BOOTPROTO=static

HWADDR=

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.140

NETMASK=255.255.255.0

DEVICE=em3

HWADDR=

BOOTPROTO=static

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.141

NETMASK=255.255.255.0

- Nadat u beide configuratiebestanden hebt opgeslagen, start u uw netwerkservice opnieuw met de onderstaande opdrachten

nmcli connection reload

nmcli device disconnect em2

nmcli connection up em2

- Herhaal de stappen voor elke interface die is gewijzigd.

- Het voltooien van de bovenstaande stappen heeft uw systeem gereedgemaakt om HAIP in te schakelen met behulp van het Oracle Grid Infrastructure-installatieprogramma. Wanneer u aan alle Oracle-installatievereisten hebt voldaan en klaar bent om Oracle te installeren, moet u em2 en em3 als 'private' interfaces selecteren in het scherm 'Network Interface Usage'.

- Deze stap schakelt Redundant Interconnect in zodra Oracle Grid Infrastructure is geïnstalleerd en wordt uitgevoerd

2.2.3. Oracle Flex ASM-netwerk

Oracle Flex ASM kan dezelfde particuliere netwerken gebruiken als Oracle Clusterware of eigen speciale particuliere netwerken gebruiken. Elk netwerk kan worden geclassificeerd als OPENBAAR of PARTICULIER+ASM of PARTICULIER of ASM.

2.2.4. Vereisten voor IP-adressen en naamomzetting

We kunnen het IP-adres van de clusterknooppunten configureren met een van de volgende opties:

- Domain Name Server (DNS)

2.2.4.1. Domain Name Server (DNS)

U kunt als volgt een Oracle 12c RAC instellen met behulp van Oracle (zonder GNS):

In de onderstaande tabel vindt u een beschrijving van de verschillende interfaces, IP-adresinstellingen en omzettingen in een cluster

|

Interface

|

Type

|

Oplossing

|

|

Openbaar

|

Statisch

|

DNS

|

|

Particulier

|

Statisch

|

Niet vereist

|

|

ASM

|

Statisch

|

Niet vereist

|

|

Virtuele IP van knooppunt

|

Statisch

|

Niet vereist

|

|

Virtuele IP van SCAN

|

Statisch

|

Niet vereist

|

Een DNS-server configureren

U configureert als volgt wijzigingen op een DNS-server voor een Oracle 12c-cluster met behulp van DNS (zonder GNS):

Configureer de SCAN NAME-omzetting op de DNS-server. Een SCAN NAME die op de DNS-server is geconfigureerd met Round Robin-beleid moet idealiter worden omgezet naar drie openbare IP-adressen (aanbevolen), maar de minimumvereiste is één openbaar IP-adres.

Bijvoorbeeld:

scancluster IN A 192.0.2.1

IN A 192.0.2.2

IN A 192.0.2.3

Waarbij het scancluster de SCAN NAME is die wordt gegeven tijdens de installatie van Oracle Grid

Een DNS-client configureren

U configureert als volgt de vereiste wijzigingen op de clusterknooppunten voor naamomzetting:

- U moet resolv.conf configureren op de knooppunten in het cluster zodat dit servernaamvermeldingen bevat die kunnen worden omgezet naar de DNS-server.

nmcli connection modify ipv4.dns ipv4.dns-search

- Controleer of de volgordeconfiguratie /etc/nsswitch.conf de servicenaamvolgorde stuurt. In sommige configuraties kan het NIS problemen veroorzaken met de omzetting van Oracle-SCAN-adressen. Het is raadzaam om de NIS-vermelding aan het einde van de zoeklijst te plaatsen.

Bijvoorbeeld: hosts: dns files nis

3. Gedeelde storage voorbereiden voor Oracle RAC-installatie

Voor Oracle RAC zijn gedeelde LUN's vereist voor het opslaan van uw Oracle Cluster Registry (OCR), voting-schijven, Oracle Database-bestanden en Flash Recovery Area (FRA). In de volgende tabel wordt de standaard aanbevolen storagevolumestructuur voor Oracle 12c Database weergegeven.

| Type/doel Database-volume | Aantal volumes | Volumegrootte |

| OCR/VOTE | 3 | 50 GB per volume |

| DATA | 4 | 250 GB[1] per volume |

| REDO[2] | 2 | Minimaal 50 GB per volume |

| FRA | 1 | 100 GB[3] |

| TEMP | 1 | 100 GB |

1 – Stel elke volumegrootte in op basis van uw database; 2 – Ten minste twee REDO ASM-schijfgroepen worden aanbevolen, elk met ten minste één storagevolume; 3 – Idealiter moet de grootte 1,5 keer de grootte van de database zijn als de bruikbare storagecapaciteit dit toelaat

permanente naamkoppeling tussen knooppunten in het cluster

3.1. Device Mapper Multipath instellen voor XtremIO-storage

Het doel van Device Mapper Multipath is meerdere I/O-paden in te schakelen om de prestaties te verbeteren en te voorzien in consistente naamgeving. Multipathing realiseert dit door uw I/O-paden te combineren in één Device Mapper-pad en de juiste I/O-belasting in te stellen. In dit gedeelte vindt u de aanbevolen werkwijzen voor het instellen van uw Device Mapper Multipathing op uw Dell PowerEdge server. Controleer of uw Device Mapper- en Multipath-driver minimaal de hieronder weergegeven versie of hoger zijn:

- rpm -qa | grep device-mapper-multipath

device-mapper-multipath

- Schakel multipath in via mpathconf –enable

- Configureer XtremIO multipath door /etc/multipath.conf te wijzigen met het volgende

device {

vendor XtremIO

product XtremApp

path_grouping_policy multibus

path_checker tur

path_selector "queue-length 0"

rr_min_io_rq 1

user_friendly_names yes

fast_io_fail_tmo 15

failback immediate

}

- Voeg de juiste gebruikersvriendelijke namen toe aan elk volume met de corresponderende scsi_id. We kunnen scsi_ids verkrijgen met de onderstaande opdracht:

/usr/lib/udev/scsi_id -g -u -d /dev/sdX

- Zoek de sectie multipath in uw /etc/multipath.conf-bestand. In deze sectie geeft u de scsi_id van elk volume en een alias op om een consistente naamgevingsconventie te behouden op al uw knooppunten. Hieronder ziet u een voorbeeld:

multipaths {

multipath {

wwid <output van stap4 voor volume1>

alias alias_of_volume1

}

multipath {

wwid <output van stap4 voor volume2>

alias alias_van_volume2

}

}

- Start uw multipath daemon-service opnieuw met behulp van

Service multipathd restart

- Controleer of de aliassen van uw multipath-volumes correct worden weergegeven

multipath -ll

- Herhaal alle drie de stappen voor alle knooppunten

3.2. De gedeelde schijf partitioneren

In dit gedeelte wordt beschreven hoe u met het hulpprogramma Parted een enkele partitie kunt maken op een volume/virtuele schijf die de hele schijf omspant.

Partitioneer elk databasevolume dat is ingesteld met behulp van Device Mapper door de volgende opdracht uit te voeren:

$> parted -s /dev/mapper/<volume1> mklabel msdos

$> parted -s /dev/mapper/<volume1> primary 2048s 100%

Herhaal dit voor alle vereiste volumes

-

Herhaal bovenstaande stappen voor alle volumes en start multipathd opnieuw op alle andere knooppunten

systemctl restart multipathd.service

-

Start het systeem opnieuw op als de zojuist gemaakte partitie niet correct wordt weergegeven

3.3. Udev-regels gebruiken voor schijfmachtigingen en persistentie

Red Hat Enterprise Linux 7.x biedt de mogelijkheid om udev-regels te gebruiken om ervoor te zorgen dat het systeem de machtigingen van apparaatknooppunten goed beheert. In dit geval verwijzen we naar de juiste instelling van machtigingen voor onze door het besturingssysteem gedetecteerde LUN's/volumes. Het is belangrijk om te weten dat udev-regels worden uitgevoerd in opgesomde volgorde. Bij het maken van udev-regels voor het instellen van machtigingen, moet u de prefix 60- opnemen en .rules toevoegen aan het einde van de bestandsnaam.

- Maak een bestand 60-oracle-asmdevices.rules onder /etc/udev/rules.d

- Zorg ervoor dat elk blokapparaat een vermelding in het bestand heeft zoals hieronder weergegeven

#---------------------start udev rule contents ------------------------#

KERNEL=="dm-*", ENV =="C1_OCR1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA4p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_FRA?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_TEMP?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

- Voer "udevadm trigger" uit om de regel toe te passen.

- Kopieer de udev-regels naar alle knooppunten en voer udevadm trigger uit om regels toe te passen

4. Oracle 12c Grid Infrastructure installeren voor een cluster

4.1 De systeemklokinstellingen configureren voor alle knooppunten

U voorkomt fouten tijdens de installatieprocedure door alle knooppunten met identieke systeemklokinstellingen te configureren. Synchroniseer de systeemklok van het knooppunt met de CTSS (Cluster Time Synchronization Service) die is ingebouwd in Oracle 12c. Om CTSS in te schakelen, schakelt u de NTPD-service (Network Time Protocol Daemon) van het besturingssysteem uit met behulp van de volgende opdrachten in de aangegeven volgorde:

-

systemctl stop chronyd.service

-

systemctl disable chronyd.service

-

mv /etc/chrony.conf /etc/ntp.chrony.orig

De volgende stappen zijn voor knooppunt één van uw clusteromgeving, tenzij anders aangegeven.

- Meld u aan als root.

- Als u zich niet in een grafische omgeving bevindt, moet u het X Window System starten door het volgende te typen: startx

- Open een terminalvenster en typ: xhost +

- Koppel de Oracle Grid Infrastructure-media.

- Meld u aan als Grid-gebruiker, bijvoorbeeld: su - grid.

- Typ de volgende opdracht om de Oracle Universal Installer te starten: /runInstaller

- Selecteer in het venster ‘Select Configuration Option' de optie 'Configure Grid Infrastructure for a Cluster' en klik op Next.

- Selecteer in het venster 'Cluster Configuration' de optie 'Configure an Oracle Standalone Cluster', en klik op Next.

- Voer in het venster 'Grid Plug and Play Information' de volgende informatie in:

-

Cluster Name: Voer een naam in voor uw cluster

-

SCAN Name: Voer de naam in die is geregistreerd op de DNS-server die uniek is voor het gehele cluster. Zie voor meer informatie over het instellen van uw SCAN-naam het gedeelte "Vereisten voor IP-adres en naamomzetting".

-

SCAN Port: Behoud de standaardpoort 1521.

-

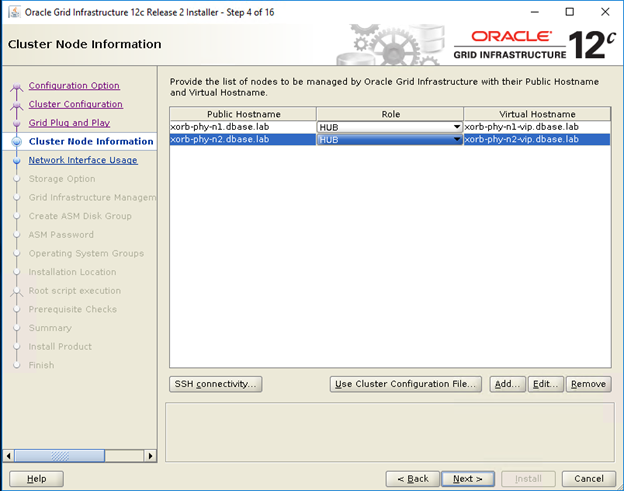

- Klik in het venster 'Cluster Node Information' op Add om extra knooppunten toe te voegen die moeten worden beheerd door Oracle Grid Infrastructure.

- Voer de gegevens voor de openbare hostnaam in voor Hub- en Leaf-clusterknooppunten

- Voer de rol in van het clusterknooppunt.

- Herhaal de bovenstaande drie stappen voor elk knooppunt in het cluster.

- Klik op 'SSH connectivity' en stel 'Passwordless SSH connectivity' in door het wachtwoord van het besturingssysteem voor de Grid-gebruiker in te voeren en vervolgens op Setup te klikken.

- Klik op OK en klik op Next om naar het volgende venster te gaan.

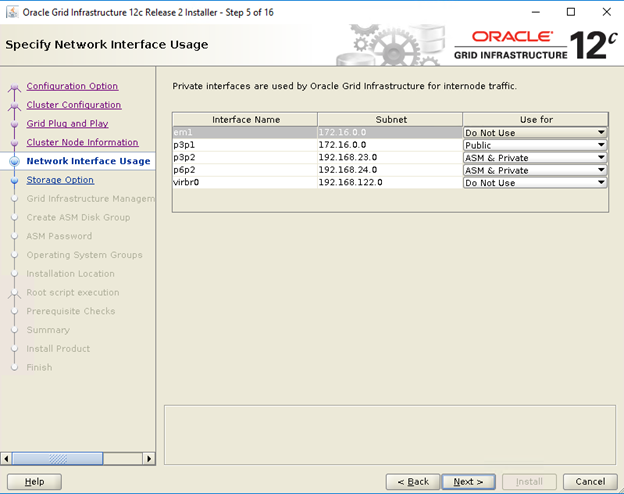

- Controleer in het venster 'Specify Network Interface Usage' of de juiste typen interfacegebruik zijn geselecteerd voor de interfacenamen. Selecteer in de vervolgkeuzelijst 'Use for' het vereiste type interface. De beschikbare opties zijn 'Public', 'Private', 'ASM', 'ASM and private'. Klik op Volgende

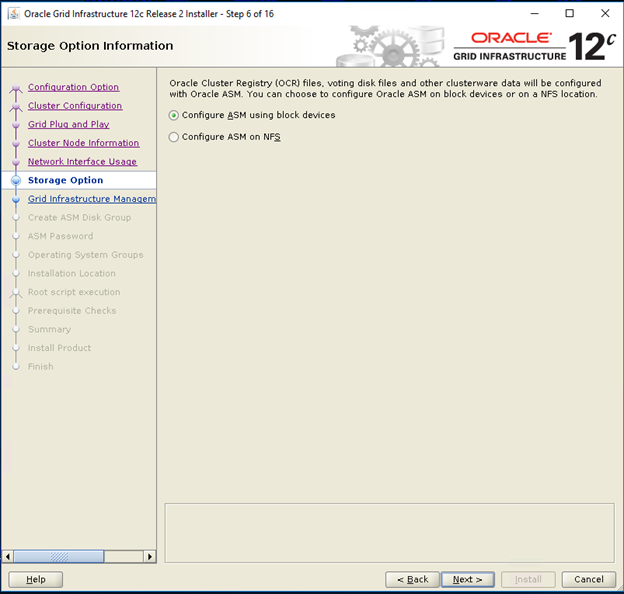

- Selecteer in het venster 'Storage option information' de optie 'Configure ASM using block devices' en klik op Next.

- Selecteer in het venster 'Grid Infrastructure Management Repository Option' de optie 'No' voor 'Configure Grid Infrastructure Management' en klik op Next.

- Voer de volgende informatie in in het venster 'Create ASM Disk Group':

-

Disk Group Name: Voer een naam in, bijvoorbeeld: OCR

-

Redundancy: Voor uw OCR- en voting-schijven selecteert u 'High' als er vijf ASM-schijven beschikbaar zijn, 'Normal ' als er drie ASM-schijven beschikbaar zijn, of 'External' als er één ASM-schijf beschikbaar is (niet aanbevolen).

-

- Kies in het venster voor het ASM-wachtwoord de relevante optie onder 'Specify the passwords for these accounts' en voer de relevante waarden in voor het wachtwoord. Klik op Next.

- Selecteer in het venster 'Failure Isolation Support' de optie 'Do Not use Intelligent Platform Management Interface (IPMI)'

- Kies in het venster 'Management options' de optie Default en klik op Next

- Selecteer in het venster 'Privileged Operating Systems Groups':

-

asmdba voor Oracle ASM DBA (OSASM) Group

-

asmoper voor Oracle ASM Operator (OSOPER) Group

-

asmdba voor Oracle ASM Administrator (OSDBA) Group

-

- Geef in het venster 'Specify Installation Location' de waarden op van uw Oracle 'Base'- en 'Software'-locaties zoals geconfigureerd in de RPM van de Dell Oracle-hulpprogramma's.

- Oracle Base: /u01/app/grid

- Locatie van software: /U01/app/12.1.0/grid_1

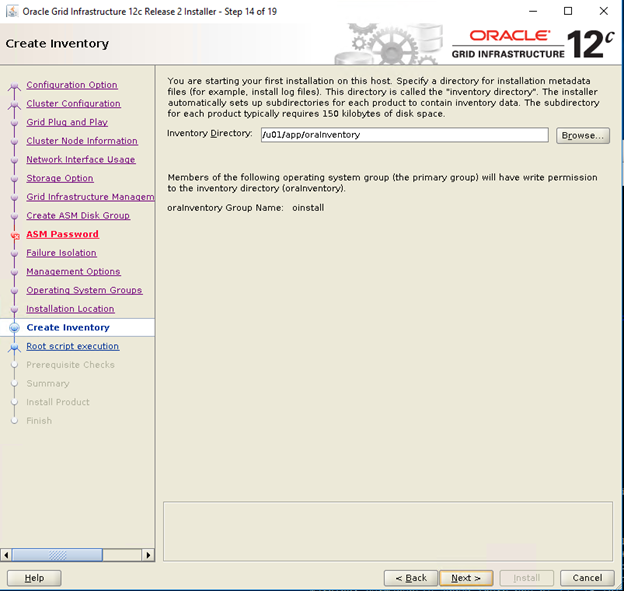

- Geef in het venster 'Create Inventory' de locatie op voor uw inventarisdirectory. Klik op Next

De standaardlocatie op basis van de RPM van de Dell Oracle-hulpprogramma's voor Inventory Directory is /u01/app/oraInventory

De standaardlocatie op basis van de RPM van de Dell Oracle-hulpprogramma's voor Inventory Directory is /u01/app/oraInventory

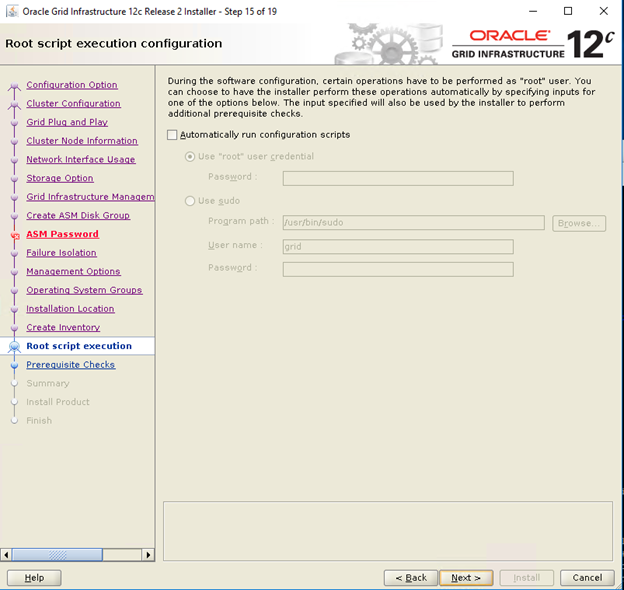

- Schakel in het venster 'Root script execution configuration' het automatisch uitvoeren van configuratiescripts uit en klik op Next

- Controleer in het overzichtsvenster alle instellingen en selecteer Install

- Controleer in het venster 'Install Product' de status van de Grid Infrastructure-installatie

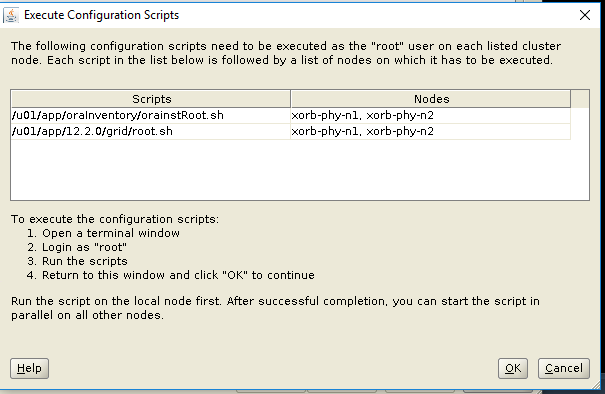

- Voer in het venster 'Execute Configuration Scripts' root.sh-scripts uit op beide knooppunten en klik op OK.

- Klik in het venster Finish op Close

5. Oracle 12c Database installeren

5.1. Oracle 12c Database (RDBMS)-software installeren

De volgende stappen zijn voor knooppunt 1 van uw clusteromgeving, tenzij anders aangegeven.

- Log in als root en typ: xhost +.

- Koppel de Oracle Database 12c-media.

- Meld u aan als Oracle-gebruiker door het volgende te typen: su - oracle

- Voer het installatiescript uit vanaf uw Oracle Database-media:

<CD_mount>/runInstaller

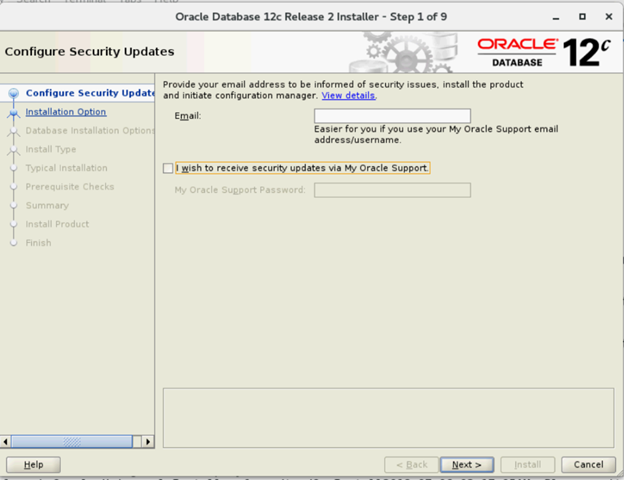

- Voer in het venster 'Configure Security Updates' uw My Oracle Support-referentie in om beveiligingsupdates te ontvangen en klik op Next.

- In het venster 'Select Installation Option' selecteert u 'Install database software only'.

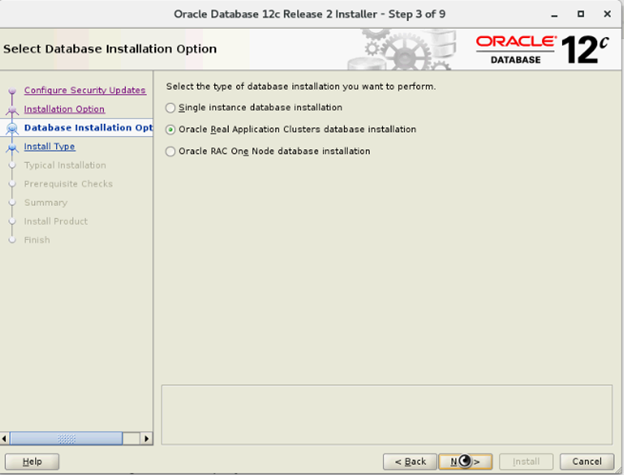

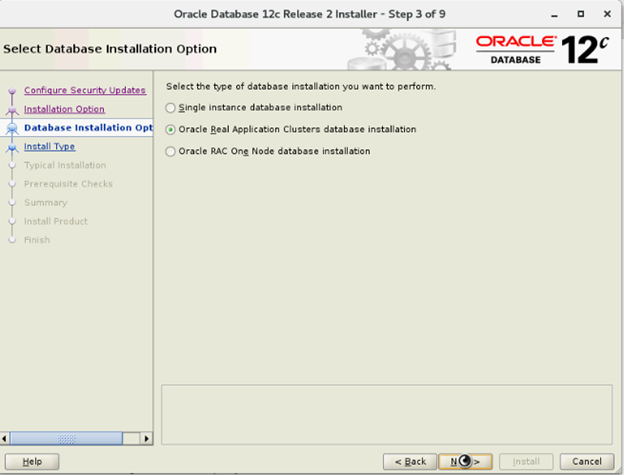

- Selecteer in het venster 'Select Database Installation Options' de optie 'Oracle Real Application Clusters database installation' en klik op Next.

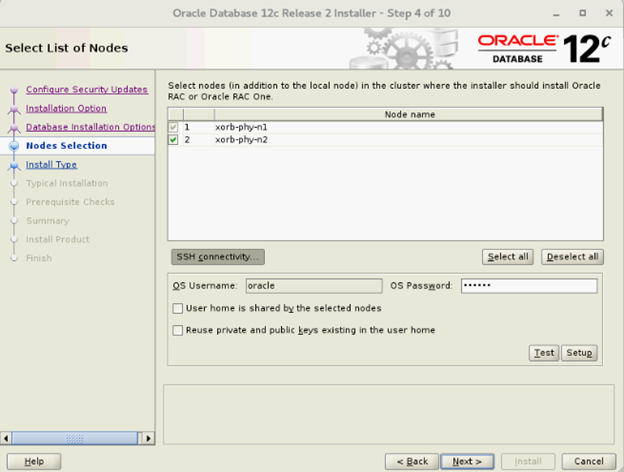

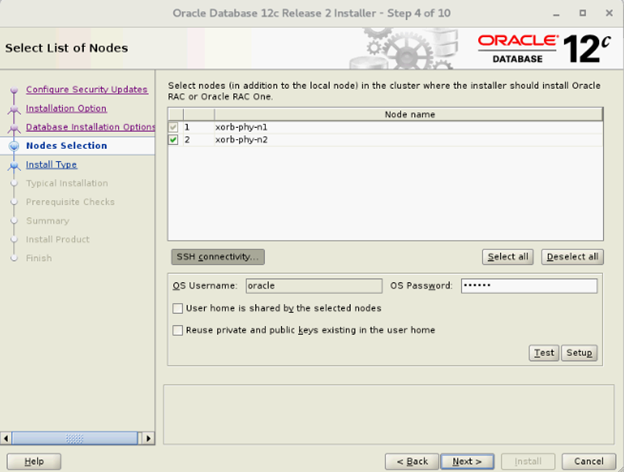

- Selecteer in het venster 'List of nodes' alle Hub-knooppunten en laat Leaf-knooppunten weg. Klik vervolgens op 'SSH Connectivity' en configureer uw wachtwoordloze SSH-connectiviteit door het wachtwoord van het besturingssysteem van de Oracle-gebruiker in te voeren en Setup te selecteren. Klik op OK en klik op Next om naar het volgende venster te gaan

- Selecteer in het venster 'Select Database Installation Options' de optie 'Oracle Real Application Clusters database installation' en klik op Next.

- Selecteer in het venster 'List of nodes' alle Hub-knooppunten en laat Leaf-knooppunten weg. Klik vervolgens op 'SSH Connectivity' en configureer uw wachtwoordloze SSH-connectiviteit door het wachtwoord van het besturingssysteem van de Oracle-gebruiker in te voeren en Setup te selecteren. Klik op OK en klik op Next om naar het volgende venster te gaan

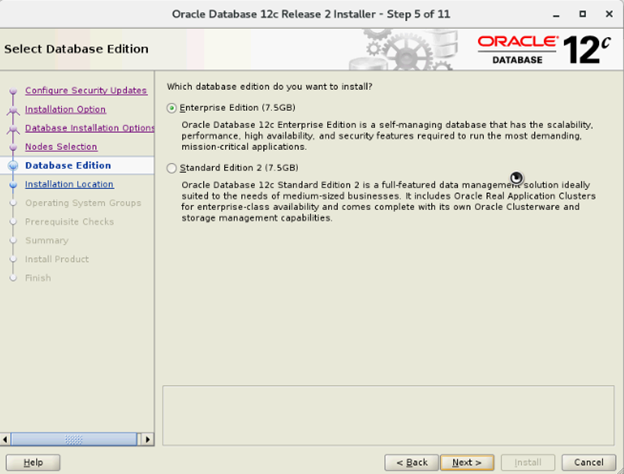

- Selecteer in het venster 'Select Database Edition' de optie 'Enterprise Edition' en klik op Next

- In het venster 'Specify Installation Location', geeft u de locatie van uw Oracle Base op die geconfigureerd is binnen de RPM van de Dell Oracle-hulpprogramma's

- Oracle Base: /u01/app/oracle

- Locatie van software: /u01/app/oracle/product/12.1.0/dbhome_2

- Selecteer in het venster 'Privileged Operating System Groups' de optie dba voor Database Administrator (OSDBA) group, dba voor Database operator (OSOPER) group, backupdba voor Database Backup and Recovery (OSBACKUPDBA) group, dgdba voor Data Guard administrative (OSDGDBA) group en kmdba voor Encryption Key Management administrative (OSKMDBA) group en klik op Next.

- Controleer de instellingen in het overzichtsvenster en selecteer Install.

- Na voltooiing van het installatieproces wordt de wizard Configuratiescripts uitvoeren weergegeven. Volg de instructies in de wizard en klik op OK.

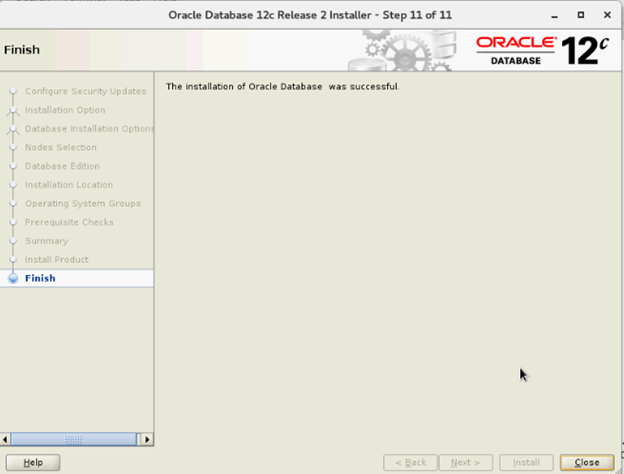

- Klik in het venster Finish op Close

6. Schijfgroepen maken met behulp van de ASM Configuration Assistant (ASMCA)

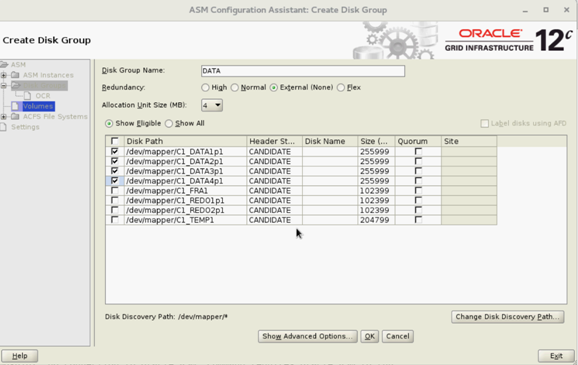

In dit gedeelte vindt u procedures voor het maken van de ASM-schijfgroep voor de databasebestanden en de Flashback Recovery Area (FRA).

- Meld u aan als Grid-gebruiker; start asmca vanaf /u01/app/12.2.0/grid/bin/asmca

- Maak de schijfgroep 'DATA' met externe redundantie door de juiste kandidaatschijven te selecteren

- Maak twee 'REDO'-schijfgroepen - REDO1 en REDO2 - met externe redundantie door minimaal één kandidaatschijf per REDO-schijfgroep te selecteren

- Maak de schijfgroep 'FRA' met externe redundantie door de juiste kandidaatschijven te selecteren

- Maak de schijfgroep 'TEMP' met externe redundantie door de juiste kandidaatschijven te selecteren

- Controleer alle vereiste schijfgroepen en klik op Exit om het hulpprogramma ASMCA te sluiten

- Wijzig ASM-striping in Fijnmazig voor de REDO-, TEMP- en FRA-schijfgroepen als Grid-gebruiker met de onderstaande opdrachten

SQL> ALTER DISKGROUP REDO ALTER TEMPLATE onlinelog ATTRIBUTES (fine)

SQL> ALTER DISKGROUP TEMP ALTER TEMPLATE tempfile ATTRIBUTES (fine)

7. Database maken met behulp van DBCA

De volgende stappen zijn van toepassing op knooppunt 1 van uw clusteromgeving, tenzij anders vermeld:

- Meld u aan als Oracle-gebruiker

- Voer vanuit $ het DBCA-hulpprogramma uit door het volgende te typen: $/bin/dbca

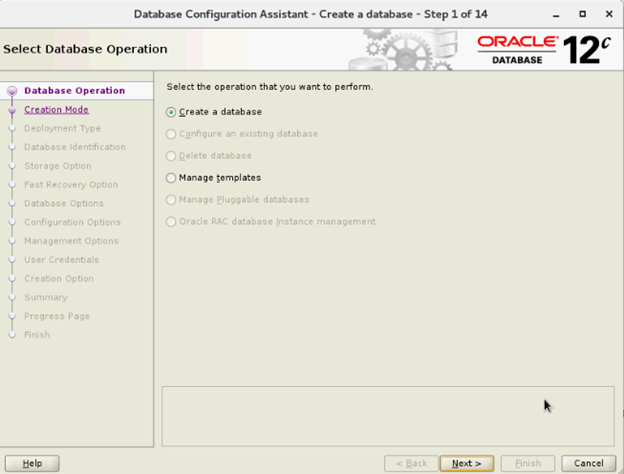

- Selecteer in het venster 'Select Database Operation' de optie 'Create Database' en klik op Next

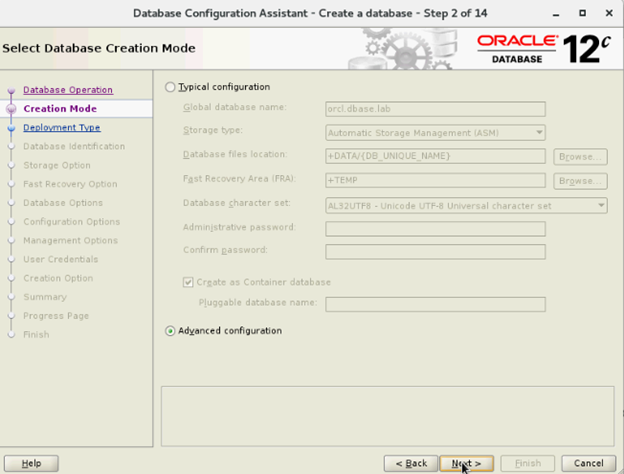

- Selecteer in het venster 'Select Creation Mode' de optie 'Advanced Mode' en klik op Next

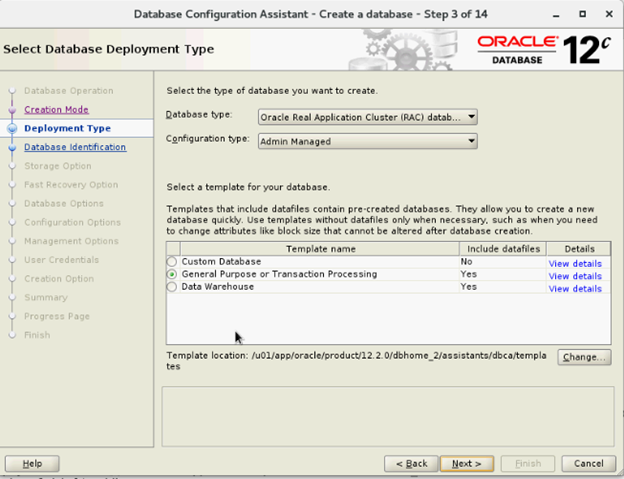

- Selecteer in het venster 'Select Database Deployment' de optie 'Oracle Real Application Cluster (RAC) database' als databasetype en 'Admin-Managed' als configuratietype, selecteer het sjabloon en klik op Next

- Selecteer in het venster 'Select List of nodes' de knooppunten en klik op Next

- In het venster 'Specify Database Identification Details':

- Selecteer in het venster 'Storage Options' de optie 'Datafiles storage location', schakel het gebruik van Oracle-Managed Files (OMF) uit en klik op Next

- Selecteer in het venster 'Select Fast Recovery Option' de optie 'Specify Fast Recovery Area location' en klik op Next

- Selecteer in het venster 'Select Oracle Data Vault Config Option' de standaardwaarden en klik op Next

- Voer in het venster 'Specify Configuration Options' de vereiste SGA- en PGA-waarden in en klik op Next

- Selecteer in het venster 'Specify Management Options' de standaardinstelling en klik op Next

- Voer in het venster 'Specify Database User Credentials' het wachtwoord in klik op Next

- Klik in het venster 'Select Database Creation Options' op 'Customize Storage Locations'

- Maak/wijzig de Redo-logboekgroepen op basis van de volgende ontwerpaanbeveling

| Groepsnummer Redo-logboek | Thread-nummer | Locatie van schijfgroep | Redo-logboekgrootte |

| 1 | 1 | +REDO1 | 5 GB |

| 2 | 1 | +REDO2 | 5 GB5 GB |

| 3 | 1 | +REDO1 | 5 GB |

| 4 | 1 | +REDO2 | 5 GB |

| 5 | 2 | +REDO1 | 5 GB |

| 6 | 2 | +REDO2 | 5 GB |

| 7 | 2 | +REDO1 | 5 GB |

| 8 | 2 | +REDO2 | 5 GB |

- Klik in het overzichtsvenster op Finish om de database te maken

- Klik op Close in het voltooiingsvenster nadat het maken van de database is voltooid

Article Properties

Affected Product

Red Hat Enterprise Linux Version 7

Last Published Date

21 Feb 2021

Version

4

Article Type

How To