Article Number: 000179557

Wdrażanie oprogramowania Oracle 12c Release 2 Grid i bazy danych RAC w systemie RHEL 7.x

Summary: Etapy i ilustracje ułatwiające wdrażanie oprogramowania Oracle 12c Release 2 Grid i bazy danych RAC w systemie RHEL 7.x

Article Content

Instructions

1. Wymagania dotyczące oprogramowania i sprzętu

1.1. Wymagania sprzętowe

- Oprogramowanie Oracle wymaga co najmniej 8 GB pamięci fizycznej

- Przestrzeń wymiany jest proporcjonalna do ilości pamięci RAM przydzielonej do systemu

| RAM | Przestrzeń wymiany |

| Od 1,5 GB do 16 GB | Równa rozmiarowi pamięci RAM |

| Więcej niż 16 GB | 16GB |

W przypadku włączenia opcji HugePages, należy odjąć pamięć przydzieloną opcji HugePages od dostępnej pamięci RAM przed obliczeniem przestrzeni wymiany.

W przypadku włączenia opcji HugePages, należy odjąć pamięć przydzieloną opcji HugePages od dostępnej pamięci RAM przed obliczeniem przestrzeni wymiany.

- Poniższa tabela przedstawia ilość miejsca na dysku wymaganą do instalacji oprogramowania Oracle

| Lokalizacja instalacji oprogramowania | Minimalne wymagania dotyczące miejsca na dysku |

| Strona główna infrastruktury sieci | Co najmniej 8 GB miejsca na dysku |

| Strona główna bazy danych Oracle | Co najmniej 6,4 GB miejsca na dysku |

| Miejsce na dysku na pamięć udostępnioną | Rozmiary bazy danych i obszaru odzyskiwania migawek |

- Przestrzeń tymczasowa Oracle (/tmp) musi wynosić co najmniej 1 GB

- Monitor obsługujący rozdzielczość 1024 x 768 w celu prawidłowego wyświetlania uniwersalnego instalatora Oracle (OUI)

1.2 Wymagania sieciowe

- Zaleca się upewnienie się, że każdy węzeł zawiera przynajmniej trzy karty sieciowe. Jedna karta sieciowa dla sieci publicznej, a dwie karty sieciowe dla sieci prywatnej, aby zapewnić wysoką dostępność klastra Oracle RAC. Jeśli zamierzasz korzystać z funkcji automatycznego zarządzania pamięcią masową (ASM) w klastrze, wymagana jest co najmniej jedna sieć Oracle ASM. Sieć ASM może współużytkować kartę sieciową z siecią prywatną.

- Nazwy interfejsów publicznych, prywatnych i ASM muszą być takie same we wszystkich węzłach. Na przykład, jeśli jako interfejs publiczny w węźle pierwszym jest używany interfejs em1, wszystkie inne węzły wymagają em1 jako interfejsu publicznego.

- Wszystkie publiczne interfejsy każdego węzła powinny być w stanie komunikować się z wszystkimi węzłami w klastrze.

- Wszystkie interfejsy prywatne i ASM każdego węzła powinny być w stanie komunikować się z wszystkimi węzłami w klastrze.

- Nazwa hosta każdego węzła musi być zgodna ze standardem RFC 952 (www.ietf.org/rfc/rfc952.txt). Nazwa hosta, która zawiera podkreślenia („_”), nie jest dozwolona

1.3. Wymagania dotyczące systemu operacyjnego

- Red Hat Enterprise Linux (RHEL) 7.x (jądro 3.10.0-693.el7.x86_64 lub nowsze)

1.3.1. Partycja dyskowa systemu operacyjnego

Poniżej przedstawiono zalecane wpisy schematu partycjonowania dysku, których należy użyć podczas instalowania systemu RHEL 7 przy użyciu pliku kickstart na lokalnych dyskach twardych z co najmniej 1,2 TB wolnego miejsca

part /boot --asprimary --fstype="xfs" --ondisk=sda --size=1024

part pv.1 --size=1 --grow --ondisk=sda --asprimary

volgroup rhel7 pv.1

logvol / --name=root --fstype=xfs --vgname=rhel7 --size=51200

logvol swap --fstype swap --name=swap --vgname=rhel7 --size=17408

logvol /home --name=home --fstype=xfs --vgname=rhel7 --size=51200

logvol /var --name=var --fstype=xfs --vgname=rhel7 --size=20480

logvol /opt --name=opt --fstype=xfs --vgname=rhel7 --size=20480

logvol /tmp --name=tmp --fstype=xfs --vgname=rhel7 --size=5120

logvol /u01 --name=u01 --fstype=xfs --vgname=rhel7 --size=1 --grow

2. Przygotowywanie serwerów do instalacji oprogramowania Oracle

Przed zainstalowaniem rozwiązania Grid i bazy danych pamiętaj o instalacji poniższych skryptów wdrożeniowych firmy Dell EMC,

które przygotują środowisko instalacji bazy danych Oracle.

2.1. Dołączanie systemów do repozytorium Red Hat Network (RHN)/Unbreakable Linux Network (ULN)

Przed wykonaniem jakiejkolwiek instalacji rozwiązania GRID/DB należy zainstalować wszystkie wymagane pakiety RPM.

Krok 1:

- rhel-7-server-optional-rpms

- rhel-7.x

Skonfiguruj lokalne repozytorium yum, aby automatycznie zainstalować pozostałe pakiety RPM zależności w celu przeprowadzenia instalacji rozwiązania GRID/DB

- Zalecana konfiguracja polega na doręczaniu plików za pośrednictwem protokołu HTTP przy użyciu serwera Apache (nazwa pakietu: httpd). W tej sekcji omówiono hosting plików repozytorium z pamięci masowej lokalnego systemu plików. Inne opcje obsługi plików repozytorium mogą wykraczać poza zakres niniejszego dokumentu. Zaleca się korzystanie z pamięci masowej lokalnego systemu plików w celu przyspieszenia i uproszczenia obsługi.

mkdir /media/myISO

mount -o loop myISO.iso /media/myISO

- Aby zainstalować i skonfigurować demona http, skonfiguruj urządzenie, które będzie hostować repozytorium dla wszystkich innych komputerów mających używać obrazu DVD lokalnie. Utwórz plik /etc/yum.repos.d/local.repo i wpisz:

[local]

name=Local Repository

baseurl=file:///media/myISO

gpgcheck=0

enabled=0

- Teraz zainstalujemy demona usługi Apache za pomocą następującego polecenia, które również tymczasowo włączy lokalne repozytorium w celu rozwiązania zależności:

yum -y install httpd --enablerepo=local

- Aby użyć serwera Apache do obsługi repozytorium, skopiuj zawartość dysku DVD do opublikowanego katalogu internetowego. Uruchom następujące polecenia jako root (pamiętaj, by zmienić myISO na nazwę swojego pliku ISO):

cp -R /media/myISO/* /var/www/html/myISO

- Ten krok jest wymagany tylko w przypadku uruchamiania systemu SELinux na serwerze, który obsługuje repozytorium. Następujące polecenie powinno być uruchamiane z uprawnieniami użytkownika root; przywraca ono odpowiedni kontekst SELinux do kopiowanych plików:

- Ostatnim krokiem jest przygotowanie nazwy serwera DNS lub adresu IP serwera, który hostuje repozytorium. Nazwa DNS lub adres IP serwera hostującego zostaną użyte do skonfigurowania pliku repo repozytorium yum na serwerze klienckim. Poniżej znajduje się zawartość przykładowej konfiguracji z użyciem nośnika serwera RHEL 7. x; jest ona przechowywana w pliku konfiguracyjnym: /etc/yum.repos.d/myRepo.repo

[myRepo]

name=RHEL 7.x Base ISO DVD

baseurl= http://reposerver.mydomain.com/myISO

enabled=1

gpgcheck=0

- Zainstaluj pakiet RPM compat-libstdc++ ręcznie przy użyciu polecenia rpm lub yum w katalogu, do którego są kopiowane pakiety RPM.

Ex: rpm -ivh

yum localinstall -y

Krok 3:

- Zainstaluj pakiety RPM compat-libstdcc++, uruchamiając następujące polecenia

yum install –y compat-libstdc++.i686

yum install –y compat-libstdc++.x86_64

- Pobierz/skopiuj pakiety RPM dostarczone przez firmę DELL, przechodząc do tematu Wdrażanie pakietów RPM Oracle dla Oracle 12cR2 w systemie RHEL7.x firmy Dell przeznaczonego do systemu RH dla serwerów, w których zostaną wykonane instalacje siatki / bazy danych. Lista pakietów RPM znajduje się poniżej, pobierane są tylko wymagane pakiety RPM

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm jest przeznaczone do:

- Wyłączanie właściwości transparent_hugepages w pliku grub2.cfg

- Wyłączanie opcji właściwości w pliku grub2.cfg

- Tworzenie użytkownika i grup oinstall i dba bazy danych Oracle

- Ustawianie parametrów jądra sysctl

- Ustawianie limitów użytkowników (nofile, nproc, stack) dla użytkowników bazy danych Oracle

- Ustawienie właściwości NOZEROCONF=yes w pliku /etc/sysconfig/network

- Tworzenie użytkownika grid i grup asmadmin, asmdba, asmoper, backupdba, dgdba, kmdba

- Ustawianie limitów użytkowników (nofile, nproc, stack) dla użytkowników grid.

- Ustawianie parametrów jądra sysctl

- Ustawianie właściwości RemoveIPC=no dla użytkowników w celu zapewnienia, że semafory nie zostaną utracone po wylogowaniu użytkownika

- Zainstaluj te dwa pakiety RPM

yum localinstall –y dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

2.2. Konfigurowanie sieci

2.2.1. Sieć publiczna

Aby skonfigurować sieć publiczną na każdym węźle

- Zaloguj się jako root.

- Przejdź do pliku /etc/sysconfig/network-scripts i edytuj wpis ifcfg-em#, gdzie # to numer urządzenia sieciowego

NAME="Oracle Public"

DEVICE= "em1"

ONBOOT=yes

TYPE= Ethernet

BOOTPROTO=static

IPADDR=<dostępny adres IP>

NETMASK=<maska sieci>

GATEWAY=<adres IP bramy>

- Ustaw nazwę hosta za pomocą poniższego polecenia

hostnamectl set-hostname <nazwa_hosta>

Gdzie <nazwa_hosta> to nazwa hosta używana podczas instalacji.

- Wpisz polecenie service network restart, aby ponownie uruchomić usługę sieciową

- Wpisz ifconfig, aby sprawdzić, czy adresy IP zostały prawidłowo ustawione

- Aby sprawdzić konfigurację sieci, wyślij polecenie ping na każdy publiczny adres IP od klienta w sieci LAN, który nie jest częścią klastra

- Połącz się z każdym węzłem, aby upewnić się, że sieć publiczna działa. Wpisz ssh, aby upewnić się, że działa polecenie Secure Shell (SSH)

2.2.2. Sieć prywatna

Poniższy przykład zawiera instrukcje krok po kroku włączania nadmiarowych połączeń przy użyciu protokołu HAIP w świeżej instalacji infrastruktury Oracle 12c Grid

- Przeprowadź edycję pliku /etc/sysconfig/network-scripts/ifcfg-emX, gdzie X to numer urządzenia em, a ifcfg-emX to pliki konfiguracyjne kart sieciowych do użytku przez połączenia prywatne.

DEVICE=em2

BOOTPROTO=static

HWADDR=

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.140

NETMASK=255.255.255.0

DEVICE=em3

HWADDR=

BOOTPROTO=static

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.141

NETMASK=255.255.255.0

- Po zapisaniu plików konfiguracyjnych należy ponownie uruchomić usługę sieciową przy użyciu poniższych poleceń

nmcli connection reload

nmcli device disconnect em2

nmcli connection up em2

- Powtórz powyższe czynności dla każdego interfejsu, który został zmodyfikowany.

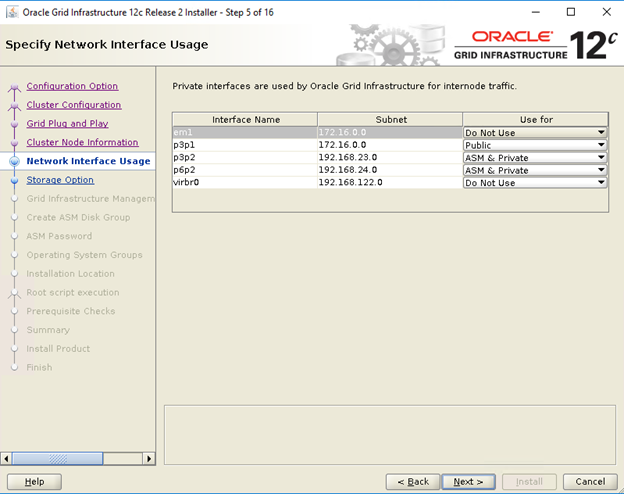

- Wykonanie powyższych czynności przygotowało system do włączenia protokołu HAIP za pomocą instalatora infrastruktury Oracle Grid. Po spełnieniu wszystkich wymagań wstępnych oprogramowania Oracle i przygotowaniu do zainstalowania oprogramowania Oracle należy wybrać em2 i em3 jako interfejsy „prywatne” na ekranie „Network Interface Usage”

- Wykonanie tej czynności zapewnia nadmiarową łączność po pomyślnym ukończeniu i uruchomieniu infrastruktury Oracle Grid

2.2.3. Sieć Oracle Flex ASM

Oracle Flex ASM może wykorzystywać te same sieci prywatne co Oracle Clusterware albo korzystać z własnych, dedykowanych sieci prywatnych. Każda sieć może być zaklasyfikowana jako PUBLICZNA, PRYWATNA+ASM, PRYWATNA lub ASM

2.2.4. Wymagania dotyczące adresów IP i rozpoznawania nazw

Aby skonfigurować adres IP węzłów klastra, należy skorzystać z jednej z następujących opcji

- Serwer nazw domen (DNS)

2.2.4.1. Serwer nazw domen (DNS)

Aby skonfigurować bazę danych Oracle 12c RAC przy użyciu oprogramowania Oracle (bez GNS):

W poniższej tabeli przedstawiono różne interfejsy, ustawienia adresów IP i translacje w klastrze

|

Interfejs

|

Typ

|

Rozwiązanie

|

|

Publiczny

|

Statyczny

|

DNS

|

|

Prywatny

|

Statyczny

|

Niewymagany

|

|

ASM

|

Statyczny

|

Niewymagany

|

|

Wirtualny adres IP węzła

|

Statyczny

|

Niewymagany

|

|

Wirtualny adres IP SCAN

|

Statyczny

|

Niewymagany

|

Konfigurowanie serwera DNS

Aby skonfigurować zmiany na serwerze DNS dla klastra Oracle 12c, korzystając z DNS (bez GNS):

Konfiguracja translacji SCAN NAME na serwerze DNS. NAZWA SCAN skonfigurowana na serwerze DNS i korzystająca z translacji dookólnej powinna być przekształcana na trzy publiczne adresy IP (zalecane), jednakże minimalne wymaganie to jeden publiczny adres IP

Przykład

scancluster IN A 192.0.2.1

IN A 192.0.2.2

IN A 192.0.2.3

Gdzie scancluster to nazwa SCAN NAME podana podczas instalacji Oracle Grid

Konfigurowanie klienta DNS

Aby skonfigurować zmiany wymagane na węzłach klastra w celu rozpoznawania nazw:

- Plik resolv.conf na węzłach klastra musi być skonfigurowany tak, aby zawierać wpisy serwerów nazw dostępne dla serwera DNS.

nmcli connection modify ipv4.dns ipv4.dns-search

- Upewnij się, że konfiguracja kolejności /etc/nsswitch.conf kontroluje kolejność usługi nazw. W niektórych konfiguracjach NIS może powodować problemy z translacją adresów Oracle SCAN. Zaleca się, aby umieścić wpis NIS na końcu listy wyszukiwania.

Na przykład, hosts: dns files nis

3. Przygotowywanie współdzielonej pamięci masowej do instalacji bazy danych Oracle RAC

Instalacja Oracle RAC wymaga współdzielonych jednostek LUN do przechowywania rejestru klastra Oracle (OCR), plików baz danych Oracle i obszaru Flash Recovery Area (FRA). W poniższej tabeli przedstawiono typową zalecaną konstrukcję woluminu pamięci masowej dla bazy danych Oracle 12c

| Typ/cel woluminu bazy danych | Liczba woluminów | Rozmiar woluminu |

| OCR/VOTE | 3 | 50 GB każdy |

| Dane | 4 | 250 GB1 każdy |

| REDO2 | 2 | Co najmniej 50 GB każdy |

| FRA | 1 | 100 GB3 |

| TEMP | 1 | 100 GB |

1 — Dostosuj każdy rozmiar woluminu do bazy danych. 2 — Zaleca się co najmniej dwie grupy dysków REDO ASM, każda z co najmniej jednym woluminem pamięci masowej; 3 — W idealnym przypadku rozmiar powinien wynosić 1,5x rozmiar bazy danych, jeśli pozwala na to pojemność pamięci masowej

trwałego powiązania nazw między węzłami w klastrze.

3.1. Konfigurowanie wielościeżkowego mapowania urządzeń dla pamięci masowej XtremIO

Celem wielościeżkowego mapowania urządzeń jest zapewnienie wielu ścieżek we/wy w celu poprawy wydajności i zapewnienia spójnego nazewnictwa. Osiąga się to przez połączenie ścieżek we/wy w jedną ścieżkę mapowania urządzeń i prawidłowe równoważenie obciążenia we/wy. W tej sekcji zapoznasz się z najlepszymi sposobami konfigurowania wielościeżkowego mapowania urządzeń na serwerze Dell PowerEdge. Sprawdź, czy mapowanie urządzeń i sterownik wielościeżkowości mają co najmniej wersję pokazaną poniżej lub wyższą:

- rpm -qa | grep device-mapper-multipath

device-mapper-multipath

- Włącz obsługę wielu ścieżek: mpathconf –enable

- Skonfiguruj wiele ścieżek XtremIO, modyfikując plik /etc/multipath.conf przy użyciu następujących parametrów

device {

vendor XtremIO

product XtremApp

path_grouping_policy multibus

path_checker tur

path_selector "queue-length 0"

rr_min_io_rq 1

user_friendly_names yes

fast_io_fail_tmo 15

failback immediate

}

- Dodaj do każdego woluminu odpowiednie czytelne nazwy, korzystając z odpowiedniego scsi_id. Parametry scsi_ids można uzyskać za pomocą poniższego polecenia

/usr/lib/udev/scsi_id -g -u -d /dev/sdX

- Znajdź sekcję multipath w pliku /etc/multipath.conf. W celu zachowania jednolitej konwencji nazewnictwa we wszystkich węzłach w tej sekcji można podać scsi_id każdego woluminu i określić alias. Poniżej przedstawiono przykład

multipaths {

multipath {

wwid <wyjście etapu4 dla woluminu1>

alias alias_woluminu1

}

multipath {

wwid <wyjście etapu4 dla woluminu2>

alias alias_of_volume2

}

}

- Uruchom ponownie demona usługi multipath przy użyciu polecenia

Service multipathd restart

- Sprawdź, czy alias woluminów wielościeżkowych jest prawidłowo wyświetlany

multipath -ll

- Powtórz wszystkie czynności dla wszystkich węzłów

3,2. Partycjonowanie dysku udostępnionego

W tej sekcji opisano sposób korzystania z narzędzia parted w celu utworzenia pojedynczej partycji na woluminie/dysku wirtualnym obejmującym cały dysk.

Podziel każdy wolumin bazy danych skonfigurowany za pomocą funkcji device-mapper, uruchamiając następujące polecenie:

$> parted -s /dev/mapper/<volume1> mklabel msdos

$> parted -s /dev/mapper/<volume1> primary 2048s 100%

Powtórz tę czynność dla wszystkich wymaganych woluminów

-

Powtórz powyższe czynności dla wszystkich woluminów i ponownie uruchom usługę multipathd na wszystkich innych węzłach

systemctl restart multipathd.service

-

Uruchom ponownie system, jeśli nowo utworzona partycja nie jest wyświetlana prawidłowo

3.3 Korzystanie z reguł udev dla uprawnień do dysków i trwałości

System Red Hat Enterprise Linux 7. x może korzystać z reguł udev, aby zapewnić prawidłowe zarządzanie uprawnieniami węzłów urządzeń. W takim przypadku odnosimy się do prawidłowego ustawienia uprawnień dla naszych jednostek LUN/woluminów wykrytych przez system operacyjny. Należy pamiętać, że reguły udev są wykonywane w kolejności zgodnej z wyliczeniem. Podczas tworzenia reguł udev do ustawiania uprawnień należy dołączyć prefiks 60-i oraz dodać .rules na końcu nazwy pliku.

- Utwórz plik 60-Oracle-asmdevices.rules w sekcji /etc/udev/rules.d

- Upewnij się, że każde urządzenie bloku ma wpis w pliku, taki jak pokazano poniżej

#---------------------początek reguły udev ------------------------#

KERNEL=="dm-*", ENV =="C1_OCR1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA4p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_FRA?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_TEMP?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

- Uruchom polecenie „udevadm trigger”, aby zastosować regułę.

- Skopiuj reguły udev do wszystkich węzłów i uruchom wyzwalacz udevadm, aby zastosować reguły

4. Instalowanie infrastruktury Oracle 12c Grid dla klastra

4.1 Konfigurowanie ustawień zegara systemowego dla wszystkich węzłów

Aby zapobiec awariom podczas procedury instalacji, należy skonfigurować wszystkie węzły z identycznymi ustawieniami zegara systemowego. Zegar systemowy węzła należy zsynchronizować z usługą synchronizacji czasu klastra (CTSS) wbudowaną w oprogramowanie Oracle 12c. Aby włączyć CTSS, wyłącz demona protokołu czasu sieciowego systemu operacyjnego (ntpd), korzystając z poniższych poleceń w następującej kolejności:

-

systemctl stop chronyd.service

-

systemctl disable chronyd.service

-

mv /etc/chrony.conf /etc/ntp.chrony.orig

Poniższe czynności dotyczą pierwszego węzła środowiska klastra, chyba że określono inaczej.

- Zaloguj się jako root.

- Jeśli nie włączono środowiska graficznego, włącz system X Window, wpisując polecenie startx

- Otwórz okno terminalu i wpisz: xhost +

- Zainstaluj nośnik infrastruktury Oracle Grid.

- Zaloguj się jako użytkownik Grid, na przykład: su - grid.

- Wpisz następujące polecenie, aby uruchomić uniwersalny instalator Oracle: /runInstaller

- W oknie Select Configuration Option wybierz opcję Configure Grid Infrastructure for a Cluster i kliknij przycisk Next

- W oknie Cluster Configuration wybierz opcję Configure an Oracle Standalone Cluster i kliknij przycisk Next.

- W oknie Grid Plug and Play Information wprowadź następujące informacje:

-

Cluster Name — wprowadź nazwę klastra

-

SCAN Name — wprowadź nazwę zarejestrowaną na serwerze DNS, unikalną dla całego klastra. Aby uzyskać więcej informacji na temat konfigurowania nazwy SCAN, zobacz „Wymagania dotyczące adresu IP i translacji nazw”.

-

SCAN Port — zachowaj domyślny port 1521.

-

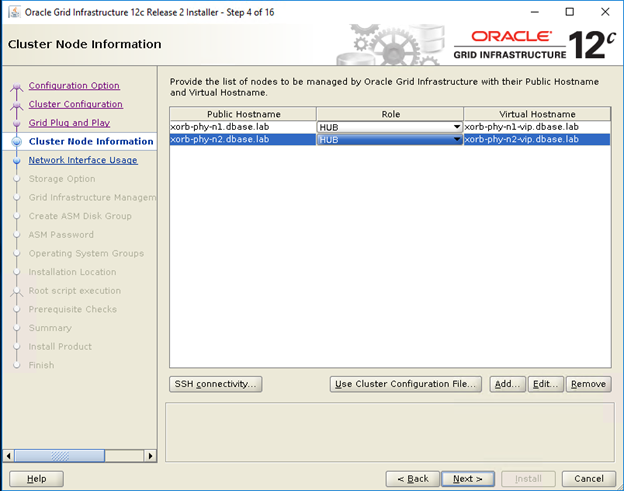

- W oknie Cluster Node Information kliknij przycisk Add, aby dodać kolejne węzły, które muszą być zarządzane przez infrastrukturę Oracle Grid.

- Wprowadź publiczne informacje o nazwie hosta dla węzłów składowych klastra koncentratora i liścia

- Wprowadź rolę węzła członkowskiego klastra.

- Powtórz trzy powyższe czynności dla wszystkich węzłów w klastrze.

- Kliknij opcję SSH connectivity i skonfiguruj łączność SSH bez hasła, wprowadzając hasło systemu operacyjnego użytkownika grid, a następnie kliknij opcję Setup.

- Kliknij przycisk OK, a następnie kliknij przycisk Next, aby przejść do następnego okna.

- W oknie Specify Network Interface Usage upewnij się, że wybrano prawidłowe typy użycia interfejsu dla nazw interfejsu. Z listy rozwijanej „Use for” wybierz wymagany typ interfejsu. Dostępne opcje to Public, Private, ASM oraz ASM and private. Kliknij przycisk Next (Dalej).

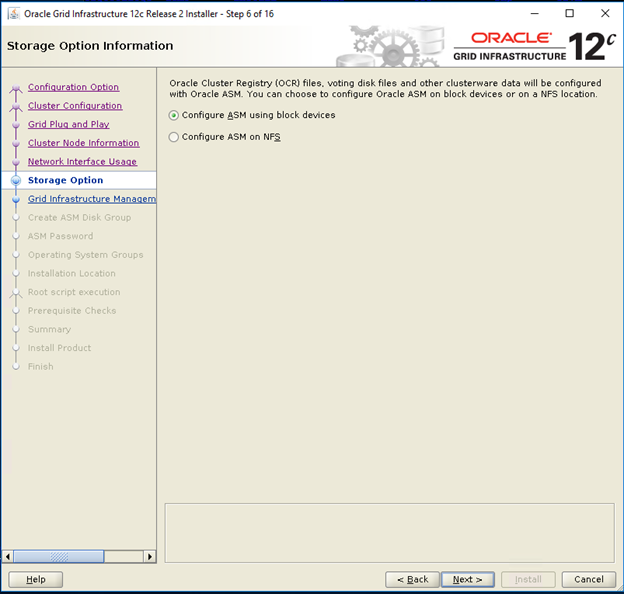

- W oknie Storage option information wybierz opcję Configure ASM using block devices i kliknij przycisk Next.

- W oknie Grid Infrastructure Management Repository Option wybierz opcję No dla parametru Configure Grid Infrastructure Management i kliknij przycisk Next.

- W oknie Create ASM Disk Group wprowadź następujące informacje:

-

Disk Group Name — wprowadź nazwę, na przykład: OCR

-

Redundancy — w przypadku dysków OCR i głosowania, wybierz opcję High, jeśli są dostępnych jest pięć dysków ASM, wybierz opcję Normal, jeśli są dostępne trzy dyski ASM, lub wybierz opcję External, jeśli dostępny jest jeden dysk ASM (niezalecane).

-

- W oknie ASM Password wybierz odpowiednią opcję w obszarze Specify the passwords for these accounts i wprowadź odpowiednie wartości hasła. Kliknij przycisk Dalej.

- W oknie Failure Isolation Support wybierz opcję Do Not use Intelligent Platform Management Interface (IPMI)

- W oknie Management options wybierz ustawienia domyślne i kliknij przycisk Next

- W oknie Privileged Operating Systems Groups wybierz opcję:

-

asmdba dla grupy Oracle ASM DBA (OSASM)

-

asmoper dla grupy Oracle ASM Operator (OSOPER)

-

asmdba dla grupy Oracle ASM Administrator (OSDBA)

-

- W oknie Specify Installation Location określ wartości Oracle Base i Software Location zgodnie z konfiguracją w pakiecie RPM Dell Oracle

- Baza Oracle: /u01/app/grid

- Lokalizacja oprogramowania: /u01/app/12.1.0/grid_1

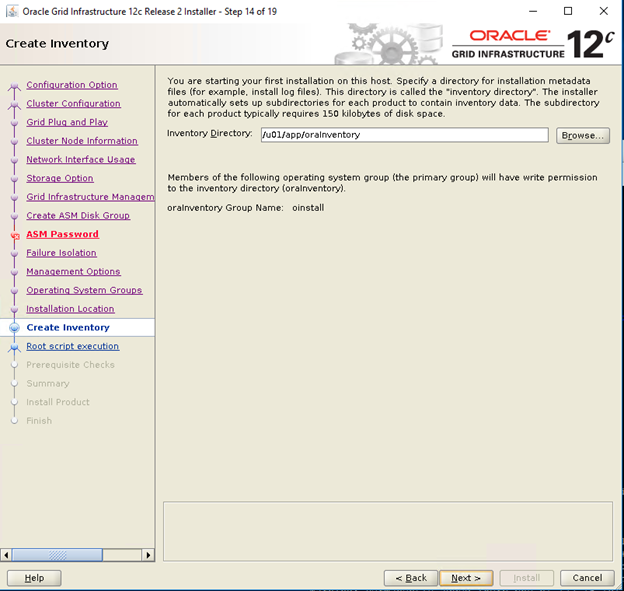

- W oknie Create Inventory określ lokalizację swojego katalogu magazynu. Kliknij przycisk Next (Dalej).

Domyślna lokalizacja oparta na module RPM narzędzi Dell Oracle dla katalogu magazynu to /u01/app/oraInventory

Domyślna lokalizacja oparta na module RPM narzędzi Dell Oracle dla katalogu magazynu to /u01/app/oraInventory

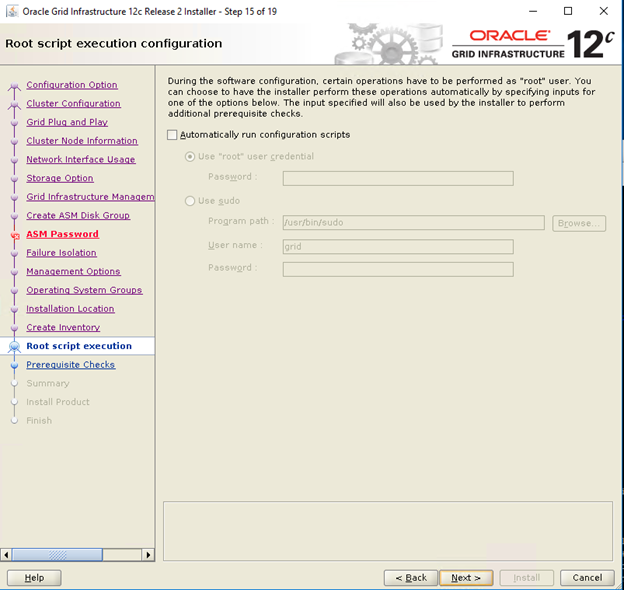

- W oknie Root script execution configuration usuń zaznaczenie opcji Automatically run configuration scripts i kliknij przycisk Next

- W oknie Summary sprawdź wszystkie ustawienia i wybierz opcję Install

- W oknie Install Product sprawdź stan instalacji infrastruktury Grid

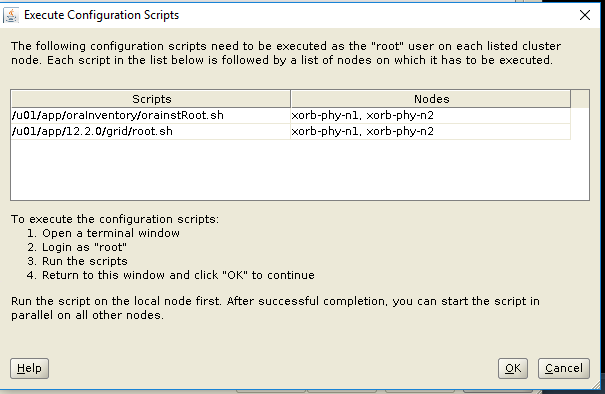

- W oknie Execute Configuration Scripts wykonaj skrypty root.sh na obu węzłach i kliknij przycisk OK.

- W oknie Finish kliknij przycisk Close

5. Instalowanie bazy danych Oracle 12c

5,1. Instalowanie oprogramowania bazy danych Oracle 12c (RDBMS)

Poniższe czynności dotyczą węzła 1 środowiska klastra, chyba że określono inaczej.

- Zaloguj się jako root i wpisz polecenie xhost+.

- Zamontuj nośnik bazy danych Oracle 12c.

- Zaloguj się jako użytkownik Oracle, wpisując polecenie su - oracle

- Uruchom skrypt Instalatora z nośnika bazy danych Oracle:

<zamontowany_dysk_CD>/runInstaller

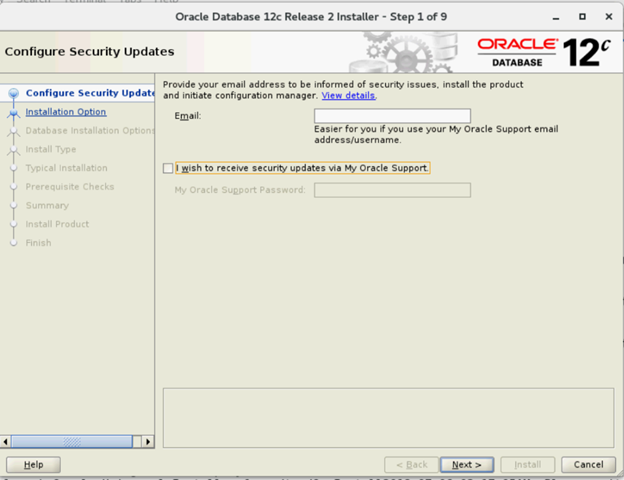

- W oknie Configure Security Updates wprowadź swoje dane logowania My Oracle Support, aby otrzymywać aktualizacje zabezpieczeń, lub też kliknij przycisk Next.

- W oknie Select Installation Option wybierz opcję Install database software.

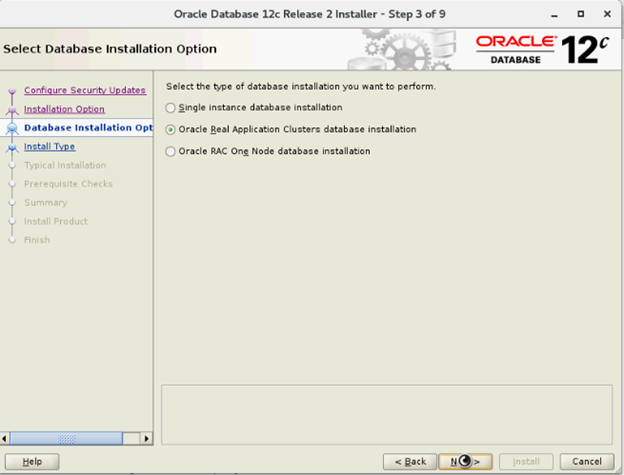

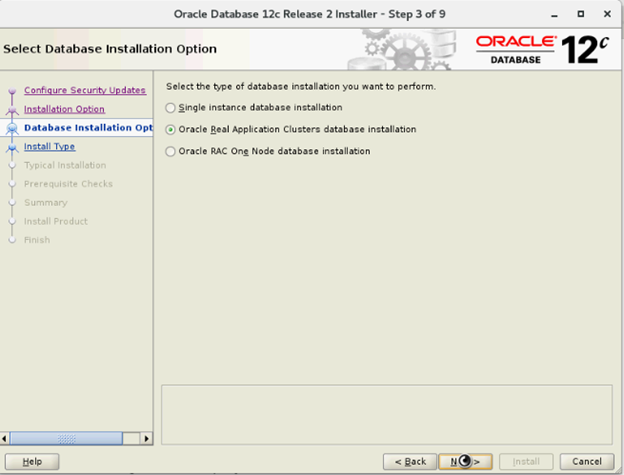

- W oknie Select Database Installation Options wybierz Oracle Real Application Clusters database installation i kliknij przycisk Next

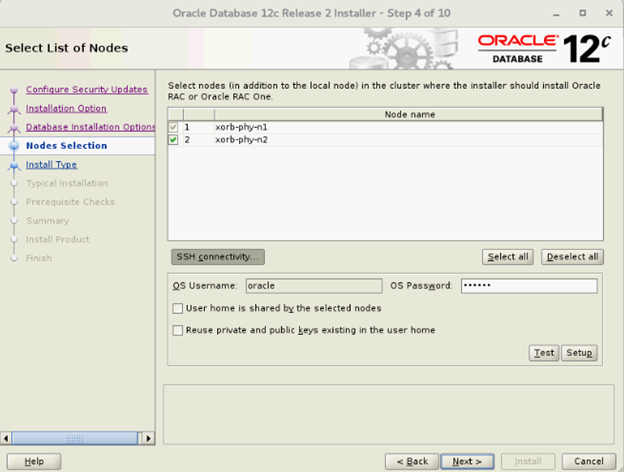

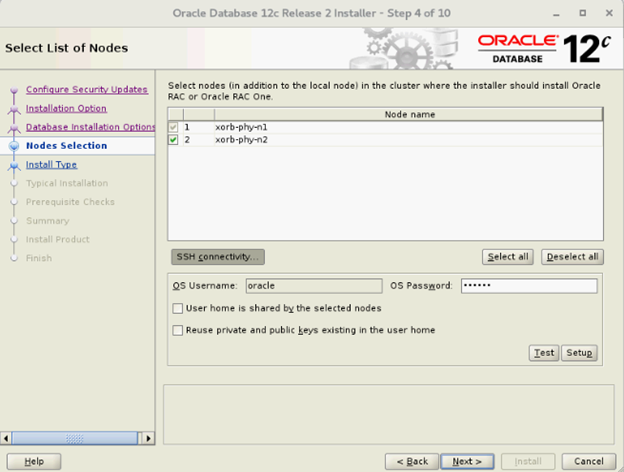

- W oknie Select List of Nodes wybierz wszystkie węzły koncentratora i pomiń węzły liści oraz kliknij opcję SSH Connectivity i skonfiguruj bezhasłową łączność SSH, wprowadzając hasło systemu operacyjnego użytkownika Oracle i wybierając opcję Setup. Kliknij przycisk OK i kliknij przycisk Next, aby przejść do kolejnego okna

- W oknie Select Database Installation Options wybierz Oracle Real Application Clusters database installation i kliknij przycisk Next

- W oknie Select List of Nodes wybierz wszystkie węzły koncentratora i pomiń węzły liści oraz kliknij opcję SSH Connectivity i skonfiguruj bezhasłową łączność SSH, wprowadzając hasło systemu operacyjnego użytkownika Oracle i wybierając opcję Setup. Kliknij przycisk OK i kliknij przycisk Next, aby przejść do kolejnego okna

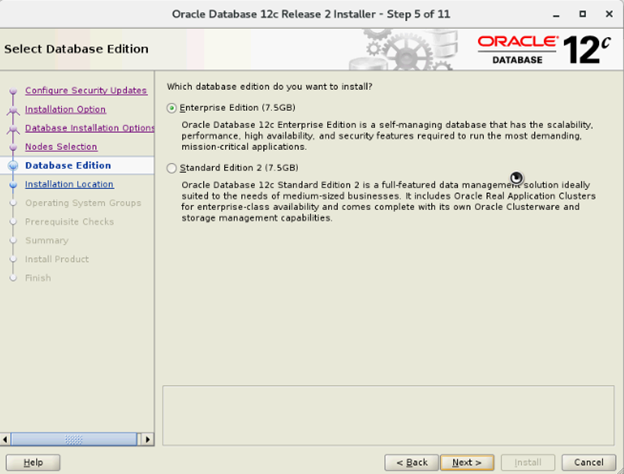

- W oknie Select Database Edition wybierz opcję Enterprise Edition, a następnie kliknij przycisk Next

- W oknie Specify Installation Location określ lokalizację bazy Oracle zgodnie z konfiguracją w pakiecie RPM narzędzi Dell Oracle

- Baza Oracle: /u01/app/oracle

- Lokalizacja oprogramowania: /u01/app/oracle/product/12.1.0/dbhome_2

- W oknie Privileged Operating System Groups wybierz dba dla grupy administratorów bazy danych (OSDBA), dba dla grupy operatorów bazy danych (OSOPER), backupdba dla grupy kopii zapasowych i odzyskiwania bazy danych (OSBACKUPDBA), dgdba dla grupy administracji ochrony danych (OSDGDBA) i kmdba dla grupy administracji zarządzania kluczem szyfrowania (OSKMDBA), po czym kliknij przycisk Next.

- W oknie Summary sprawdź ustawienia i wybierz opcję Install

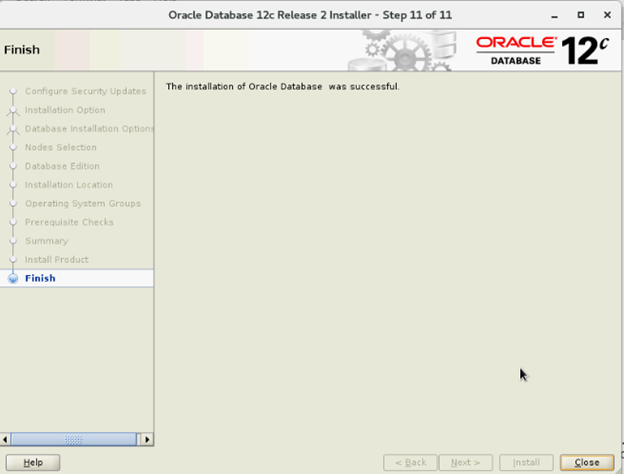

- Po zakończeniu procesu instalacji zostanie wyświetlony kreator skryptów wykonania konfiguracji. Postępuj zgodnie z instrukcjami wyświetlanymi w kreatorze, a następnie kliknij przycisk OK.

- W oknie Finish kliknij przycisk Close

6. Tworzenie grupy dysków przy użyciu narzędzia ASM Configuration Assistant (ASMCA)

W tej sekcji zamieszczono procedury tworzenia grupy dysków ASM dla plików bazy danych i obszaru odzyskiwania Flashback (FRA).

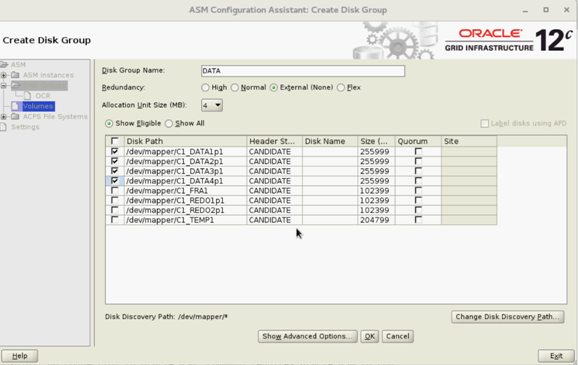

- Zaloguj się jako użytkownik Grid i uruchom polecenie asmca z /u01/app/12.2.0/grid/bin/asmca

- Utwórz grupę dysków „DATA” z nadmiarowością zewnętrzną, wybierając odpowiednie dyski kandydujące

- Utwórz dwie grupy dysków „REDO” — REDO1 i REDO2 — z nadmiarowością zewnętrzną, wybierając co najmniej jeden dysk kandydujący na grupę dysków REDO

- Utwórz grupę dysków „FRA” z nadmiarowością zewnętrzną, wybierając odpowiednie dyski kandydujące

- Utwórz grupę dysków „TEMP” z nadmiarowością zewnętrzną, wybierając odpowiednie dyski kandydujące

- Sprawdź wszystkie wymagane grupy dysków, a następnie kliknij przycisk Zamknij, aby zamknąć narzędzie ASMCA

- Jako użytkownik grid za pomocą poniższych poleceń zmień rozdzielczość przeplotu ASM na większą dla grup REDO, TEMP i FRA

SQL> ALTER DISKGROUP REDO ALTER TEMPLATE onlinelog ATTRIBUTES (fine)

SQL> ALTER DISKGROUP TEMP ALTER TEMPLATE tempfile ATTRIBUTES (fine)

7. Tworzenie bazy danych przy użyciu narzędzia DBCA

Poniższe czynności dotyczą węzła 1 środowiska klastra, chyba że określono inaczej:

- Zaloguj się jako użytkownik Oracle

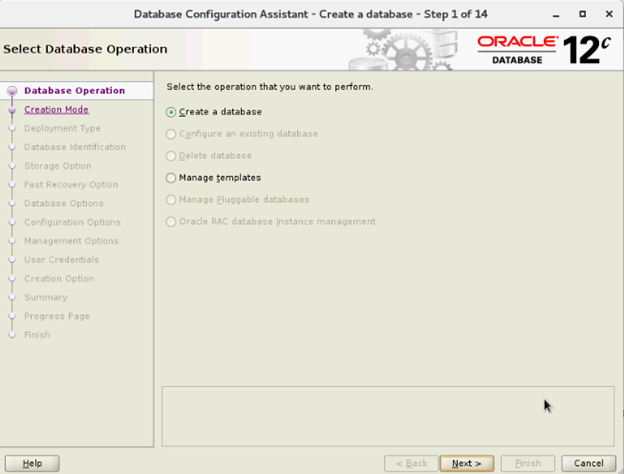

- Z poziomu $ uruchom narzędzie DBCA, wpisując polecenie: $/bin/dbca

- W oknie Select Database Operation wybierz opcję Create Database i kliknij przycisk Next

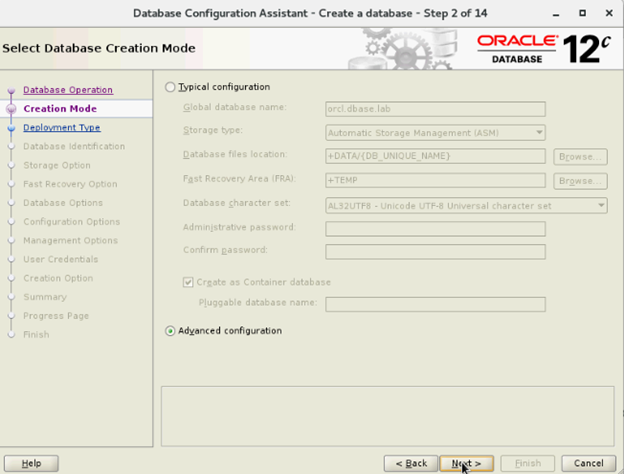

- W oknie Select \Creation Modewybierz opcję Advanced Configuration Mode, a następnie kliknij przycisk Next

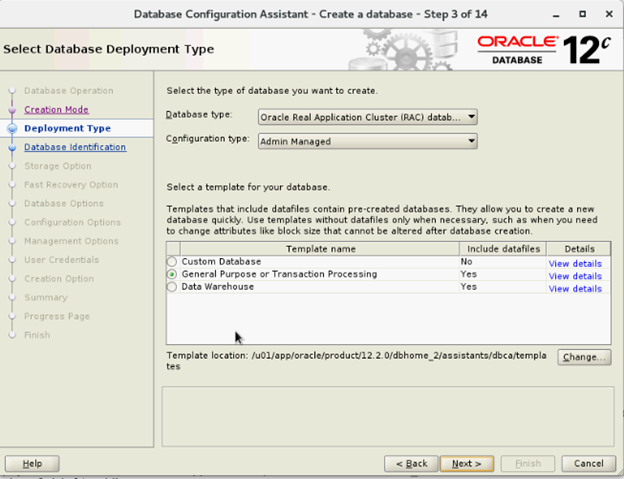

- W oknie Select Database Deployment wybierz opcję Select Oracle Real Application Cluster (RAC) w sekcji Database type i wybierz opcję Select Admin-Managed for Configuration Type, wybierz szablon i kliknij przycisk Next

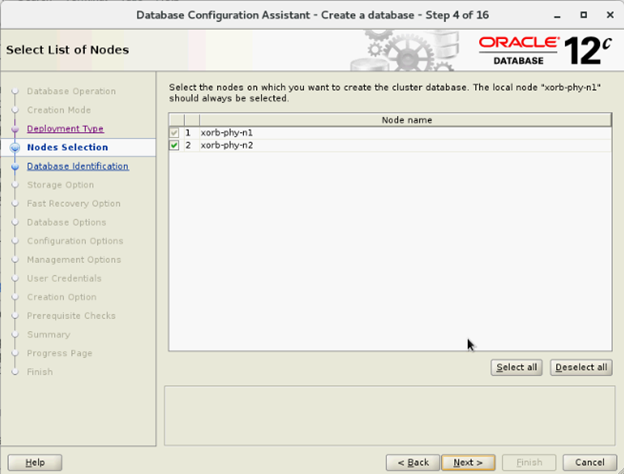

- W oknie Select List of nodes wybierz węzły i kliknij przycisk Next

- W oknie Specify Database Identification Details:

- W oknie Storage Options Window wybierz opcję Datafiles storage location, usuń zaznaczenie opcji Use Oracle- Managed Files (OMF) i kliknij przycisk Next

- W oknie Select Fast Recovery Option wybierz opcję Specify Fast Recovery Area location i kliknij przycisk Next

- W oknie Select Oracle Data Vault Config Option wybierz wartości domyślne i kliknij przycisk Next

- W oknie Specify Configuration Options wprowadź wymagane wartości SGA i PGA oraz kliknij przycisk Next

- W oknie Specify Management Options wybierz ustawienia domyślne i kliknij przycisk Next

- W oknie Specify Database User Credentials wprowadź hasło, a następnie kliknij przycisk Next

- W oknie Select Database Creation Options kliknij opcję Customize Storage Locations

- Utwórz/zmodyfikuj grupy dzienników powtórzeń na podstawie poniższego zalecenia dotyczącego projektowania

| Numer grupy dziennika powtórzeń | Numer wątku | Lokalizacja grupy dysków | Rozmiar dziennika powtórzeń |

| 1 | 1 | +REDO1 | 5 GB |

| 2 | 1 | +REDO2 | 5 GB5 GB |

| 3 | 1 | +REDO1 | 5 GB |

| 4 | 1 | +REDO2 | 5 GB |

| 5 | 2 | +REDO1 | 5 GB |

| 6 | 2 | +REDO2 | 5 GB |

| 7 | 2 | +REDO1 | 5 GB |

| 8 | 2 | +REDO2 | 5 GB |

- W oknie Summary kliknij opcję Finish, aby utworzyć bazę danych

- Po zakończeniu tworzenia bazy danych kliknij przycisk Close w oknie Finish

Article Properties

Affected Product

Red Hat Enterprise Linux Version 7

Last Published Date

21 Feb 2021

Version

4

Article Type

How To