Mantener el ritmo de la eficiencia en el uso de la energía

Summary: En los sitios web, artículos y documentos técnicos del sector, hace años que se está advirtiendo sobre el “tsunami de datos”. Por lo general, el énfasis se centra en las nuevas tecnologías de almacenamiento, pero la capacidad de procesar esta enorme cantidad de datos nuevos es igual de importante. ...

Symptoms

Los departamentos de TI llevan más de una década enfrentando el crecimiento abrumador de los datos en el entorno de computación. En los sitios web, artículos y documentos técnicos del sector, hace años que se está advirtiendo sobre el “tsunami de datos”. Por lo general, el énfasis se centra en las nuevas tecnologías de almacenamiento, pero la capacidad de procesar esta enorme cantidad de datos nuevos es igual de importante.

El aprendizaje automático y la IA están llegando a desempeñar un papel de gran importancia en este espacio. A su vez, la demanda de mayores capacidades de procesamiento también se ha intensificado, lo que generó el desarrollo de capacidades de CPU de una potencia cada vez mayor y, en particular, dio lugar al reciente aumento en el uso de tecnologías aceleradoras (GPU, FPGA) para ofrecer las capacidades de procesamiento paralelo de ultraalta velocidad necesarias para las aplicaciones de IA de uso intensivo de capacidades de procesamiento.

Estas tecnologías avanzadas de IA, además de otras necesidades informáticas en aumento, exigen una nueva arquitectura de alimentación para ofrecer de manera eficiente una mayor capacidad de procesamiento. Si bien esta oportunidad de rediseño aporta diversos beneficios, no es un problema sencillo de resolver.

El problema de la energía

La demanda de mayores capacidades de procesamiento trae consigo un problema crucial de diseño del sistema relacionado con el suministro de energía eléctrica. La geometría de fabricación más precisa de los procesadores actuales (con tamaños de menos de 10 nm) permite cambios más rápidos en la alimentación. Esto tiene como resultado menos retrasos y menor latencia, con lo que, a su vez, se requiere un voltaje más bajo, inferior a 1 voltio (V), para posibilitar el procesamiento. No obstante, si se considera la ley de Ohm (P = V * I), si la potencia (P) aumenta y el voltaje (V) es menor, entonces la corriente (I) debe aumentar. Esto se convierte en un problema, ya que el suministro de una corriente más alta al núcleo o al “paquete” del procesador requiere el uso de más pines de socket para transportar esa corriente más alta. Si no fuera así, estos pines podrían usarse para mejorar la funcionalidad del sistema (es decir, entrada/salida, administración del sistema). Por ejemplo, los diseños de SoC (sistema en un chip) aportan más funcionalidad al propio chip, por lo que la pregunta que se plantea es la siguiente: ¿Cómo se puede ofrecer más potencia de forma eficiente sin perder potencial de funcionalidad? Esto es importante porque, a escala, incluso las pequeñas mejoras en la eficiencia se vuelven significativas: un vatio por servidor para 100 000 servidores puede ahorrar cientos de miles de dólares a lo largo de los ciclos de vida de esos servidores.

Solución de aumento del voltaje

Una de las soluciones que se está aceptando actualmente en el sector es proporcionar un mayor voltaje (como 48 V) al servidor. En la Open Compute Project (“OCP”) Summit del año 2016, Google anunció una iniciativa para promocionar el uso de una infraestructura de servidores y distribución de 48 V como el estándar para los centros de datos. Este modelo implica varios cambios en la arquitectura de entrega (que se describen a continuación), que pueden aportar las siguientes ventajas:

- Más energía para el procesador (sin reducir el tamaño ni los pines de sockets y conectores)

- Menor pérdida de energía en la conversión de energía (menos conversiones más eficientes)

- Menor densidad de componentes en el diseño de la placa base (menos capas de alimentación y áreas de trazado)

- Cables, conectores y barras colectoras más pequeños

- Menores pérdidas en la distribución de la alimentación

- Límites de alimentación más altos en comparación con los racks de 12 V

Se eligieron 48 V porque no se necesita la implementación de límites de seguridad especiales. Todo lo que supere los 60 V se considera “de alto voltaje” y requeriría un aislamiento de seguridad adicional. Por lo tanto, si se usa la ley de Ohm, un voltaje de 48 V implicaría una reducción en la corriente a la cuarta parte, pero aún deja un margen de seguridad.

Cabe señalar que Intel planteó el uso de servidores de 48 V a fines de la década de 1990, pero luego esta alternativa perdió terreno frente a los diseños de servidores de 12 V debido a las limitaciones en la densidad de los reguladores de voltaje y en la eficiencia en la conversión de energía y a los costos más altos de los componentes de esa época.

Suministro de energía

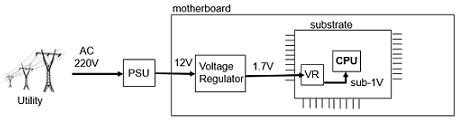

Para comprender las ventajas del modelo de alimentación de 48 V, es útil comprender primero cómo se suministra la energía en la actualidad. En la actualidad, las empresas de suministro de energía eléctrica suelen suministrar corriente alterna (CA) de 220 V a 240 V, que, a su vez, es convertida por la fuente de alimentación (PSU) de un sistema a 12 V. La energía se convierte nuevamente en un regulador de voltaje ubicado en la placa base del sistema de 12 V a 1,7 V (estamos usando un ejemplo de implementación de Intel). Esta línea de 1,7 V es aproximadamente el doble del voltaje que la CPU necesita en última instancia para reducir la corriente suministrada desde la placa base, de modo que se pueden usar menos pines para suministrar la energía al sustrato del procesador. Sin embargo, la energía debe convertirse una vez más en el núcleo y el sustrato para llegar a los niveles inferiores a un voltio necesarios para el procesador.

Figura 1: Modelo actual de suministro de 12 voltios

Ineficiencias por pérdidas en la distribución de energía eléctrica

En cada etapa de conversión, se pierde cierto nivel de potencia/energía. Se calcula que la eficiencia general en el uso de la energía de los centros de datos tradicionales de la actualidad (desde la infraestructura básica hasta los procesadores y el enfriamiento) suele estar en un rango medio del 80 %, aunque las eficiencias de las fuentes de alimentación (PSU) y los reguladores de voltaje integrados (VR) actuales ya han sido de mucho más del 90 %. Además, esta energía se pierde en forma de calor, lo que hace que los centros de datos necesiten gastar aún más energía (y costos) para enfriar estos sistemas de mayor rendimiento. El aumento de la eficiencia en el uso de la energía (que elimina la pérdida de energía) permite, en última instancia, que los centros de datos ahorren en costos de enfriamiento. Incluso un aumento de un solo punto porcentual en la eficiencia conlleva importantes beneficios financieros y ambientales.

Las pérdidas en la distribución de energía eléctrica son una función del cuadrado de la corriente (potencia = I2 * R). Por lo tanto, reducir la cantidad de corriente (I) a través de cierta resistencia (R) repercute en la cantidad de pérdida. La reducción de la corriente se puede lograr aumentando el voltaje (ley de Ohm), lo que alimenta un mayor interés en el modelo de 48 V.

Nuevos enfoques del suministro de energía

En este momento, el suministro eficaz de energía a los procesadores de alta potencia sigue siendo un área dinámica en la que se están explorando diversos enfoques. A continuación, se describen dos de estos enfoques y las ventajas de cada uno.

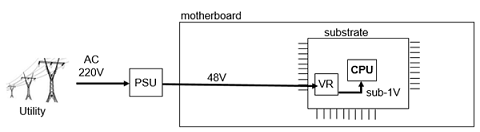

Un enfoque para lograr una mayor eficiencia es suministrar los 48 voltios directamente al sustrato del paquete del procesador y luego convertirlos a menos de 1 V en el sustrato. Este enfoque elimina una etapa de conversión (lo que aumenta la eficiencia) y permite el suministro de corriente baja al sustrato (lo que aumenta la disponibilidad de pines). Sin embargo, dado que el espacio disponible en el sustrato del paquete es muy limitado, el convertidor de potencia de 48 V a menos de un voltio debe ser de alta densidad y bajo perfil, por lo que la implementación de esta tecnología sigue siendo compleja y costosa.

Figura 2: Modelo de suministro directo de 48 voltios al sustrato

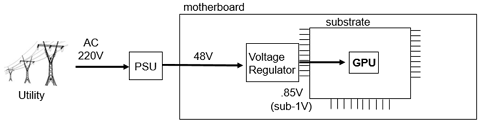

Otro enfoque es suministrar los 48 voltios a la placa base. En ese momento, un regulador de voltaje lo convierte en un voltaje inferior a uno (por ejemplo, 0,85 V) y luego lo suministra directamente al procesador. Este enfoque también elimina una conversión, lo que aumenta la eficiencia, pero debe suministrar una corriente más alta al sustrato, lo que no permite reducir la cantidad de pines de suministro de energía. Este enfoque es más común, porque es menos complejo y menos costoso que el modelo de suministro directo.

Figura 3: Modelo de suministro de 48 voltios a la placa base

Otras ventajas

El cambio al modelo de 48 V también puede implicar otras ventajas. Para lograr una solución a nivel de rack completamente integrada, dado que una barra colectora de 48 V transporta cuatro veces menos corriente que una barra de 12 voltios, podría potencialmente reducir en 16 veces (I2) la pérdida de distribución eléctrica si se usa la misma barra colectora para la distribución de alimentación en el rack. Esto puede dar lugar a un diseño en el que los cables (o barras colectoras) son más delgados (de mayor calibre) debido a que transportan menos corriente.

Se pueden ahorrar espacio y costos al reducir el tamaño de los componentes (conectores, condensadores, cables y barras colectoras) y, a medida que se libera espacio, se ponen a disposición más opciones de diseño para los diseñadores de sistemas.

Al nivel de rack, estas ventajas se multiplican. El modelo de distribución de la alimentación en rack de 48 V (similar a la distribución de la alimentación a nivel de rack de 12 V) ofrece la oportunidad de implementar UPS de corriente continua (CC) distribuidos y elimina la necesidad de usar un voluminoso UPS de corriente alterna (CA) al nivel de la instalación que, además de tener un gran tamaño, es rígido y difícil de mantener. Por el contrario, el UPS de CC distribuido, junto con las modernas tecnologías de baterías a base de litio, es más compacto, liviano y fácil de mantener. También tiene la ventaja adicional de permitir una funcionalidad de pago por uso, lo que implica agregar capacidad de manera dinámica, cada vez que se necesite capacidad adicional.

Todavía estamos en un mundo de 12 voltios

Independientemente del interés en las eficiencias de los 48 V, las placas base de los servidores de 12 V de hoy en día existen desde hace más de 20 años. La infraestructura de 12 voltios es un producto básico: existe en gran volumen en el mundo en este momento, y la cadena de suministro actual de 12 V está optimizada. Por lo tanto, la conversión a un voltaje más alto no será generalizada en toda la infraestructura. Por ejemplo, los discos duros seguirán siendo de 12 V para aprovechar la amplia variedad de opciones de funcionamiento comprobado en el mercado de almacenamiento actual, por lo que los diseños de servidores estándares seguirán incorporando una alimentación de 12 V en el futuro inmediato. Sin embargo, con la demanda insaciable de poder de procesamiento, es de esperar que se produzca una mayor adopción de cartuchos y placas base con un suministro de voltaje más alto, como ya estamos viendo en las áreas de IA y aprendizaje automático.

Para ser perfectamente claros: las soluciones de reguladores de voltaje de 48 V adecuadas para aplicaciones convencionales de paquetes de procesadores o placas base (es decir, con alta densidad, eficiencia y optimizadas en cuanto al costo) aún son limitadas. Pero los principales proveedores de semiconductores de administración de energía, junto con el sector de la conversión de energía, están trabajando intensamente en ello, y se espera que en los próximos años haya soluciones más viables disponibles. Los avances en las tecnologías de procesadores y paquetes podrían marcar el comienzo de una era en la que la conversión de la última etapa, con una relación alta de conversión de voltaje, pueda producirse en el chip del procesador o en el sustrato del paquete, y se los pueda alimentar directamente con un voltaje más alto.

Conclusión

Uno de los mayores desafíos para los centros de datos es la mejora de la eficiencia energética. En muchos casos, la búsqueda de una mayor eficiencia se reduce a ahorrar energía y el costo operativo asociado, y al hacerlo, ahorrar en el costo total de propiedad (TCO). Por lo tanto, la necesidad de un uso de energía aún mayor hace que sea mucho más importante obtener los niveles más altos de eficiencia posibles.

Dell EMC trabaja con una amplia variedad de clientes para ayudar a resolver algunos de los problemas de aprendizaje automático más complejos e interesantes. El grupo Extreme Scale Infrastructure (ESI) se dedica a mantenerse a la vanguardia de las últimas tecnologías de suministro de energía y aplicarlas donde sea pertinente, de modo que podamos ayudar a nuestros clientes a satisfacer de manera eficiente su demanda incesante de capacidad de procesamiento.

Para obtener más información sobre lo que está haciendo el grupo Extreme Scale Infrastructure de Dell EMC con las tecnologías de suministro de energía, comuníquese con ESI@dell.com.

Cause

N/D

Resolution

N/D