À la pointe de l’efficacité énergétique

Summary: Les sites Web spécialisés, les articles et les livres blancs mettent en garde depuis des années contre le « raz-de-marée des données ». En général, l’accent est mis sur les nouvelles technologies de stockage, mais la capacité à traiter cette quantité massive de nouvelles données est tout aussi importante. ...

Symptoms

Depuis plus de dix ans, les services IT se débattent avec la croissance écrasante des données dans l’environnement informatique. Les sites Web spécialisés, les articles et les livres blancs mettent en garde depuis des années contre le « raz-de-marée des données ». En général, l’accent est mis sur les nouvelles technologies de stockage, mais la capacité à traiter cette quantité massive de nouvelles données est tout aussi importante.

L’apprentissage automatique et l’IA vont jouer un rôle important dans ce domaine. En conséquence, la pression pour des capacités de traitement toujours plus élevées s’est intensifiée, menant à des processeurs toujours plus puissants et, en particulier, à une récente montée en flèche de l’utilisation des technologies d’accélération (processeur graphique, FPGA) pour fournir les capacités de traitement parallèle ultra-rapide nécessaires aux applications d’IA gourmandes en ressources de calcul.

Ces technologies avancées d’IA, ainsi que d’autres besoins croissants en calcul, exigent une nouvelle architecture énergétique pour délivrer plus de puissance de traitement de manière efficace. Cette opportunité de refonte présente plusieurs avantages, mais ce n’est pas un problème simple à résoudre.

Problème d’alimentation

La course vers des capacités de traitement plus élevées entraîne une problématique cruciale de conception des systèmes, liée à la distribution de l’énergie électrique. La géométrie de fabrication plus fine des processeurs actuels (inférieure à 10 nm) permet une commutation plus rapide de l’alimentation, ce qui réduit les délais et la latence. Cela nécessite en contrepartie une tension plus faible : inférieure à 1 volt (V), pour alimenter le traitement. En revanche, selon la loi d’Ohm (P=V*I), si la puissance (P) augmente et que la tension (V) diminue, l’intensité du courant (I) doit, elle, augmenter. Cela devient problématique, car fournir un courant plus élevé au die ou au « package » du processeur nécessite davantage de broches sur le socket pour transporter ce courant supplémentaire, des broches qui pourraient autrement être utilisées pour offrir plus de fonctionnalités système (notamment pour les E/S ou la gestion du système). Par exemple, les conceptions de type System on a Chip (SoC) intègrent davantage de fonctionnalités directement sur la puce, ce qui pose la question suivante : comment fournir plus de puissance efficacement sans sacrifier de fonctionnalités ? Ce point est important car, à grande échelle, même les gains d’efficacité minimes deviennent significatifs. Un watt par serveur pour 100 000 serveurs peut permettre d’économiser des centaines de milliers de dollars pendant le cycle de vie de ces serveurs.

La solution de l’augmentation de tension

L’une des solutions les plus adoptées dans l’industrie aujourd’hui est d’alimenter le serveur avec une tension plus élevée (comme 48 V). À l’occasion du sommet Open Compute Project (« OCP ») 2016, Google a annoncé une initiative visant à promouvoir l’infrastructure serveur et la distribution en 48 V comme standard pour les datacenters. Ce modèle implique plusieurs modifications apportées à l’architecture de distribution (décrites ci-dessous) qui peuvent offrir les avantages suivants :

- Plus de puissance pour le processeur (sans réduire le nombre de broches et la taille des connecteurs)

- Moins de pertes d’énergie dans la conversion de puissance (conversions moins nombreuses et plus efficaces)

- Moins d’encombrement dans la conception de la carte mère (moins de couches d’alimentation et de zones de pistes)

- Câbles, connecteurs et barres omnibus plus petits

- Moins de pertes de distribution d’énergie

- Limites de puissance plus élevées par rapport aux racks 12 V

Le choix du 48 V a été fait parce qu’il ne nécessite pas de protections de sécurité particulières. Toute tension supérieure à 60 V est considérée comme « haute tension » et nécessite une isolation de sécurité supplémentaire. En appliquant la loi d’Ohm, le 48 V permet une réduction du courant par un facteur de quatre, tout en conservant une marge de sécurité.

Il convient de noter qu’Intel avait encouragé l’adoption de serveurs 48 V à la fin des années 1990, mais ceux-ci avaient été supplantés par les conceptions de serveurs 12 V en raison de la densité limitée des régulateurs de tension et du faible rendement de conversion de l’époque, ainsi que du coût plus élevé des composants.

Alimentation

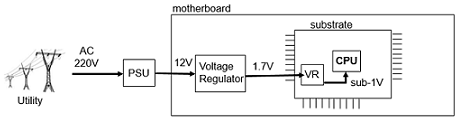

Pour comprendre les avantages du modèle d’alimentation 48 V, il est utile de comprendre d’abord comment l’alimentation est fournie aujourd’hui. Actuellement, une compagnie d’électricité fournit du courant alternatif (AC) à 220 V-240 V, qui est ensuite converti par le bloc d’alimentation (PSU) du système en 12 V. Elle est convertie à nouveau dans un régulateur de tension situé sur la carte mère du système de 12 V à 1,7 V (nous utilisons un exemple d’implémentation Intel). Ce rail de 1,7 V correspond à environ deux fois la tension réellement nécessaire au processeur, afin de réduire le courant délivré par la carte mère et donc d’utiliser moins de broches pour alimenter le substrat du processeur. Mais l’alimentation doit encore être convertie une nouvelle fois sur le die et le substrat pour atteindre les niveaux inférieurs à 1 V requis par le processeur.

Figure 1 : Le modèle actuel de 12 volts

Inefficacités liées aux pertes de distribution électrique

À chaque étape de conversion, un certain niveau de puissance/énergie est perdu. D’après les estimations, le rendement global des datacenters traditionnels actuels (depuis l’alimentation en provenance des services publics jusqu’aux processeurs et au refroidissement) se situe généralement autour de 80 %, même si le rendement des blocs d’alimentation (PSU) et des régulateurs de tension (VR) sur carte est déjà supérieur à 90 %. En outre, cette énergie est perdue sous forme de chaleur, ce qui oblige les datacenters à dépenser encore plus d’énergie (et de coûts) pour refroidir ces systèmes plus performants. Améliorer l’efficacité énergétique (en réduisant les pertes) permet aux datacenters de réaliser des économies sur les coûts de refroidissement. Même un seul point de pourcentage d’augmentation de l’efficacité entraîne des gains financiers et environnementaux significatifs.

Les pertes de distribution électrique sont fonction du carré du courant (Puissance = I²R). Ainsi, réduire le courant (I) traversant une résistance (R) donnée a un impact sur la quantité des pertes. La réduction du courant peut être obtenue en augmentant la tension (loi d’Ohm), ce qui suscite un intérêt accru pour le modèle 48 V.

Nouvelles approches en matière d’alimentation

À l’heure actuelle, l’alimentation efficace des processeurs haute puissance reste un domaine dynamique ; diverses approches sont suivies. Deux de ces approches et leurs avantages sont décrits ci-dessous.

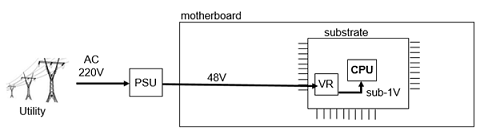

Une approche visant à accroître l’efficacité consiste à fournir les 48 V directement au substrat du package processeur, puis à convertir cette tension en une valeur inférieure à 1 V sur le substrat. Cette approche élimine une étape de conversion (augmentation de l’efficacité) et permet de fournir un courant faible au substrat (augmentation de la disponibilité des broches). Cependant, étant donné l’espace très limité disponible sur le substrat du package, le convertisseur de puissance de 48 V à moins d’un volt doit être à la fois très dense et de faible profil. La mise en œuvre de cette technologie reste donc complexe et coûteuse.

Figure 2 : Modèle d’alimentation directe du substrat en 48 volts

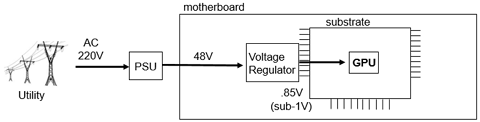

La deuxième approche a consisté à fournir les 48 volts à la carte mère. Un régulateur de tension les convertit alors en une tension inférieure à 1 V (par exemple 0,85 V), qui est ensuite transmise directement au processeur. Cette approche supprime également une étape de conversion (augmentation de l’efficacité), mais doit délivrer un courant plus élevé au substrat, ce qui ne permet pas d’économiser sur le nombre de broches d’alimentation. Cette approche est plus courante car elle est moins complexe et moins coûteuse que le modèle de prestation directe.

Figure 3 : Modèle d’alimentation de la carte mère en 48 volts

Autres avantages

L’adoption du modèle 48 V présente d’autres avantages. Dans une solution entièrement intégrée à l’échelle du rack, puisqu’une barre omnibus 48 V transporte quatre fois moins de courant qu’une barre omnibus 12 V, elle peut potentiellement économiser 16 fois (I²) la perte de distribution électrique si la même barre est utilisée pour la distribution de puissance au rack. En conséquence, les câbles (ou barres omnibus) peuvent être plus fins (calibre plus élevé) car ils transportent moins de courant.

L’encombrement et les coûts peuvent être réduits, car les composants (connecteurs, condensateurs, câbles et barres omnibus) sont réduits et, à mesure que l’espace est libéré, davantage d’options de conception sont mises à la disposition des concepteurs de systèmes.

Au niveau du rack, ces avantages sont multipliés. Le modèle de distribution d’énergie 48 V dans le rack (similaire à la distribution 12 V au niveau du rack) offre la possibilité de mettre en œuvre des onduleurs (UPS) en courant continu (DC) distribués et élimine le besoin d’onduleurs volumineux en courant alternatif (AC) au niveau des installations. En plus d’être volumineux, ces onduleurs sont rigides et difficiles à entretenir. À l’inverse, les onduleurs en courant continu distribués, associés aux batteries modernes à base de lithium, sont plus compacts, légers et faciles à entretenir. Ils offrent en plus l’avantage de permettre une fonctionnalité de paiement à l’utilisation, c’est-à-dire d’ajouter de la capacité de manière dynamique dès qu’un besoin supplémentaire apparaît.

Le monde reste un monde en 12 volts

En dépit de l’intérêt pour l’efficacité du 48 V, les cartes mères pour serveurs 12 V d’aujourd’hui existent depuis plus de 20 ans. L’infrastructure 12 V est devenue une commodité (elle est déployée en très grande quantité aujourd’hui) et la chaîne d’approvisionnement actuelle en 12 V est optimisée. La conversion vers une tension plus élevée ne sera donc pas omniprésente dans l’infrastructure. Par exemple, les disques durs resteront alimentés en 12 V afin de tirer parti de la large gamme d’options éprouvées disponibles sur le marché du stockage actuel. Les conceptions de serveurs grand public continueront donc à intégrer l’alimentation en 12 V dans un avenir prévisible. Mais avec la soif insatiable de puissance de traitement, on peut s’attendre à une adoption croissante de cartouches et de cartes mères alimentées en tension plus élevée, comme on le constate déjà dans les domaines de l’IA et de l’apprentissage automatique.

Pour être parfaitement clair, les solutions de régulateur de tension 48 V adaptées aux cartes mères ou processeurs standard (c’est-à-dire avec une densité élevée, une efficacité et un coût optimisés) sont encore limitées. En revanche, les principaux fournisseurs de semi-conducteurs de gestion de l’alimentation, en collaboration avec le secteur de la conversion de l’énergie, y travaillent intensivement, et il est prévu que des solutions plus viables deviennent disponibles dans les années à venir. Les avancées dans les technologies de processeurs et de packaging pourraient inaugurer une ère où la dernière étape de conversion, avec un rapport de conversion élevé, pourrait avoir lieu directement dans le silicium du processeur et/ou sur son substrat, et où des tensions plus élevées pourraient leur être directement appliquées.

Conclusion

L’amélioration de l’efficacité énergétique est l’un des plus grands défis des datacenters. Dans de nombreux cas, la recherche d’une plus grande efficacité se résume à économiser de l’énergie et les coûts d’exploitation associés, et donc à réduire le coût total de possession (TCO). La nécessité d’une consommation électrique encore plus élevée rend donc d’autant plus important d’obtenir les niveaux d’efficacité les plus élevés possibles.

Avec un large éventail de clients, Dell EMC aide à résoudre certains des problèmes d’apprentissage automatique les plus complexes et les plus intéressants. Le groupe Extreme Scale Infrastructure (ESI) s’engage à rester à la pointe des dernières technologies de l’alimentation et à les appliquer là où cela a du sens, afin d’aider nos clients à répondre efficacement à leur demande ininterrompue de puissance de calcul.

Pour plus d’informations sur les activités de Dell EMC Extreme Scale Infrastructure en lien avec les technologies d’alimentation, contactez ESI@dell.com.

Cause

Sans objet

Resolution

Sans objet