電力効率向上への取り組み

Summary: 業界のWebサイト、記事、ホワイトペーパーは、長年にわたって「データ津波」の到来について警告されてきました。通常は、新しいストレージ テクノロジーに重点が置かれていますが、重要なのは、この大量の新しいデータを処理する能力にあります。

Symptoms

コンピューティング環境における圧倒的なデータの増加に、IT業界は10年以上にわたって苦闘してきました。 業界のWebサイト、記事、ホワイトペーパーは、長年にわたって「データ津波」の到来について警告されてきました。通常は、新しいストレージ テクノロジーに重点が置かれていますが、重要なのは、この大量の新しいデータを処理する能力にあります。

機械学習とAIがこの分野で大きな役割を果たすようになっています。それに伴い、処理能力への要求も一段と高まり、より高性能なCPUの開発が進められてきました。特に演算負荷の高いAIアプリケーションに必要な超高速並列処理機能を提供するために、アクセラレーター テクノロジー(GPU、FPGA)の活用が急増しています。

これらの高度なAIテクノロジーや、その他のコンピューティング ニーズの高まりにより、より多くの処理能力を効率的に提供するために、先進的な電源アーキテクチャが必要とされています。この再設計には多くのメリットがある一方で、簡単に解決できる問題ではありません。

電源の問題

処理能力の向上に伴い、電力供給に関する重要なシステム設計の課題が生じています。 今日のプロセッサーでは、製造形状がより微細になり(10nm未満)、より高速な電力スイッチングが可能になっています。その結果、遅延が少なく、レイテンシーが低くなるため、処理を行うのに必要な電圧がより低く(1ボルト(V)未満)なります。 しかし、オームの法則(P=V*I)に従うと、電力(P)が増加し、電圧(V)が低い場合、電流(I)を増加させる必要があります。これは、プロセッサーのダイまたは「パッケージ」に高い電流を供給するには、より多くのソケット ピンを使用する必要があるため、問題となります。ただし、ソケット ピンを使用すると、より優れたシステム機能(I/O、システム管理)を提供することができます。例えば、システム オン チップ(SoC)の設計では、チップ自体により多くの機能を搭載しています。したがって、その問題は、潜在的な機能を失うことなく、どのようにより多くの電力を効率的に供給するかということになります。これは、大規模な環境では効率性がわずかに向上するだけでも大きく影響するため重要です。10万台のサーバーの場合、サーバーあたり1ワットであれば、サーバーのライフサイクル全体で数十万ドルのコスト削減が可能になります。

高電圧ソリューション

今日の業界で受け入れられているソリューションの1つは、サーバーに供給する電圧を引き上げることです。具体的には、48Vの電圧を供給することにより、電力消費を削減し、システムの信頼性を向上させることができます。2016年のOpen Compute Project ("OCP") Summitにおいて、Googleは48Vサーバーと配電インフラストラクチャをデータセンターの標準として推進するイニシアティブを発表しました。このモデルには、デリバリー アーキテクチャ(後述)にいくつかの変更が加えられており、次のような利点があります。

- ソケットやコネクタのピン数やサイズを減らすことなく、プロセッサーにより多くの電力を供給が可能

- 電力変換におけるエネルギー損失の低減(少ない変換回数、より効率的な変換)

- マザーボード設計の簡素化(電力層とトレース領域の削減)

- ケーブル、コネクタ、バスバーの小型化

- 配電損失の低減

- 12Vラックと比較して電力制限が高い

特別な安全対策を必要としないため、48Vが選択されました。60Vを超えるものは「高電圧」と見なされ、追加の安全絶縁が必要になります。したがって、オームの法則を使用すると、48Vでは電流が1/4に低減するが、それでも安全性を確保しています。

なお、48Vサーバーは1990年代後半にインテルによって提案されましたが、その時代の電圧レギュレーター密度と電力変換効率の制限、およびコンポーネント コストの高さにより、12Vサーバーの設計に取って代わられる結果となりました。

電力供給

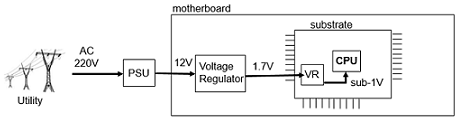

48V電源モデルの利点を理解するには、まず現在の電力供給方法を理解することが重要です。現在、電力会社は通常、220V~240Vの交流電流(AC)を供給しており、システムの電源供給ユニット(PSU)によって12Vに変換されます。(インテルの実装例を使って説明すると)システムのマザーボード上にある電圧レギュレーターで、12Vから1.7Vに再変換されます。この1.7Vの電圧は、CPUが最終的に必要とする電圧の約2倍であり、マザーボードから供給される電流を減らすために使用されます。これにより、プロセッサー基板に電力を供給するために使用するピン数を減らすことができます。しかし、ダイや基板上でさらに電力が変換され、プロセッサーが必要とする1ボルト未満の電圧レベルまで下げられます。

図1: 現在の12ボルトの供給モデル

配電損失の非効率性

各変換段階で、一定のレベルの電力/エネルギーが失われます。今日の従来のデータセンターの電力効率は、一般的に80%台半ばの範囲にあると推定されていますが、電源供給ユニット(PSU)とオンボード電圧レギュレーター(VR)の非効率性はすでに90%以上に達しています。 また、このエネルギーは熱となって失われるため、データセンターはこれらの高性能システムを冷却するためにさらに多くのエネルギー(およびコスト)を費やす必要があります。電力効率の向上(エネルギー損失の排除)により、最終的にはデータセンターの冷却コストを削減できます。効率性1%ト増加するだけでも、コストと環境面で大きなメリットがあります。

電力の分配による損失は電流の二乗に比例します(電力損失= I2R)。 したがって、一定の抵抗(R)に流れる電流(I)を減らすことが損失の軽減につながります。 電流の低減は電圧を上げることで達成できます(オームの法則)。そのため、48Vモデルへの関心が高まっています。

新しい電源供給アプローチ

現時点では、高出力プロセッサーへの効率的な電力供給はまだ動的に変化している領域であるため、さまざまなアプローチが検討されています。ここでは、2つのアプローチとそれぞれの利点を以下で説明します。

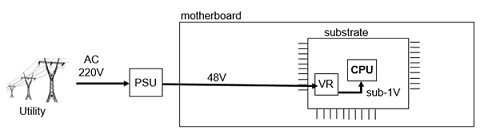

効率性を高めるためのアプローチとして、48ボルトをプロセッサー パッケージ基板に直接供給し、基板上で1V以下に変換する方法があります。このアプローチにより、1段階の変換ステージが不要になり(効率が向上)、基板への低電流供給が可能になります(ピンの可用性が向上)。 しかし、パッケージ基板上の利用可能なスペースが非常に限られているため、48Vからサブ1Vへの電力変換器は高密度で低プロファイルでなければならないため、この技術の実装は依然として複雑で高コストになります。

図2:基板への直接48ボルト供給モデル

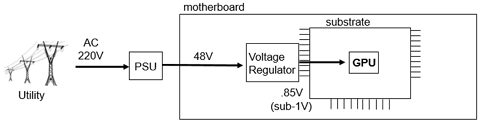

もう1つのアプローチは、マザーボードに48ボルトを供給する方法です。 この段階で、電圧レギュレーターはそれを1V以下の電圧(例えば0.85V)に変換し、プロセッサーに直接供給します。 このアプローチでは、変換回数を1回減らすことができますが、基板への電流供給量を増やす必要があるため、電源供給ピン数を軽減することはできません。この方法は、直接配送モデルよりも複雑でコストがかからないため、より一般的です。

図3:マザーボードへの48Vの供給モデル

その他の利点

48Vへの移行による利点は他にもあります。完全に統合されたラック スケール ソリューションの場合、48Vバス バーは12Vバス バーよりも4倍少ない電流を供給するため、同じバス バーをラックの配電に使用すると、16倍(I2)の配電損失を削減できる可能性があります。 これにより、ケーブル(またはバス バー)がより少ない電流を運ぶため、より薄く(より高いゲージで)設計されるようになる可能性があります。

コンポーネント(コネクタ、コンデンサ、ケーブル、バスバー)のサイズが小さくなるにつれて、スペースとコストの両方を節約でき、スペースが解放されるにつれて、システム設計者はより多くの設計オプションを利用できるようになります。

ラック レベルでは、これらの利点が倍増します。48Vラック内配電モデル(12Vラック レベルの配電と同様)は、分散直流(DC) UPSを導入する機会を提供し、大きな施設レベルの交流(AC) UPSが必要なくなります。交流UPSは、大きいだけでなく、柔軟性がなく、保守が困難です。 これに対し、分散型DC UPSは、最新のリチウムベースのバッテリーテクノロジーと組み合わせることで、よりコンパクトで軽量、保守が容易になります。 また、従量課金制の機能を有効にできる利点もあります。つまり、容量を動的に追加することで、必要なときにいつでも容量を追加できます。

いまなお12Vの世界

48Vの効率性への関心が高まっているにかかわらず、12Vサーバーのマザーボードは20年以上前から存在しています。12V用のインフラストラクチャは、現在世界中で大量に普及しており、12Vのサプライチェーンは最適化されています。そのため、インフラ全体に高電圧への変換が普及するとは考えられません。たとえば、今日のストレージ市場で実証済みの幅広いオプションを利用するために、ハードドライブは依然として12Vであるため、メインストリームのサーバー設計には、当面12Vの電力が引き続き組み込まれることでしょう。しかし、処理能力への飽くなき欲求に伴い、AIや機械学習の分野で既に見られるように、より高電圧で供給されるカートリッジやマザーボードの導入が期待されます。

明確にいうと、メインストリームのマザーボードまたはプロセッサー パッケージ アプリケーションに適した48V電圧レギュレーター ソリューション(すなわち、高密度、高効率性、最適コスト)は依然として限られています。 しかし、電力管理半導体の大手サプライヤーは、電力変換業界とともに集中的に取り組んでおり、今後数年間でより実行可能なソリューションが利用可能になると予想されています。 プロセッサーやパッケージング技術の進歩により、プロセッサーのシリコンやパッケージ基板上で高電圧変換率への最終転換が起こり、高電圧が直接供給される時代が訪れる可能性があります。

結論

データセンターの最大の課題の1つは、電力効率の向上です。多くの場合、効率化の追求は、エネルギーと関連する運用コストを節約し、総所有コスト(TCO)を節約することに帰結します。そのため、電力使用量をさらに増やす必要があるため、可能な限り最大レベルの効率性を引き出すことがはるかに重要になってきています。

Dell EMCは、さまざまなお客様と協力して、非常に複雑で興味深い機械学習の問題の解決に取り組んでいます。ESIグループは、最新の電力技術を常に把握し、それらを適切な場所に適用することに取り組んでいます。これにより、お客様の処理能力に対する需要を効率的に満たすことができるよう支援しています。

Dell EMC Extreme Scale Infrastructureが電力テクノロジーを使用して行っていることの詳細については、ESI@dell.comにお問い合わせください。

Cause

なし

Resolution

なし