Article Number: 000179557

Comment déployer Oracle 12c Release 2 Grid et une base de données RAC sur RHEL 7.x

Summary: Étapes et images pour vous aider à déployer Oracle 12c Grid version 2 et RAC Database sur RHEL 7.x

Article Content

Instructions

1. Configuration matérielle et logicielle requise

1.1. Configuration matérielle requise

- Oracle nécessite au moins 8 Go de mémoire physique.

- L’espace d’échange est proportionnel à la quantité de RAM allouée au système.

| RAM | Espace d’échange |

| Entre 1,5 Go et 16 Go | Égal à la taille de la RAM |

| Plus de 16 Go | 16 Go |

Si vous activez HugePages, vous devez déduire la mémoire allouée à HugePages de la RAM disponible avant de calculer l’espace d’échange.

Si vous activez HugePages, vous devez déduire la mémoire allouée à HugePages de la RAM disponible avant de calculer l’espace d’échange.

- Le tableau suivant décrit l’espace disque requis pour une installation Oracle.

| Emplacement d’installation du logiciel | Espace disque minimal requis |

| Accueil Grid Infrastructure | Au moins 8 Go d’espace disque |

| Accueil Oracle Database | Au moins 6,4 Go d’espace disque |

| Espace disque de stockage partagé | Tailles de la zone de récupération du flashback et de la base de données |

- La taille de l’espace temporaire d’Oracle (/tmp) doit être d’au moins 1 Go.

- Un moniteur qui prend en charge une résolution de 1024 x 768 pour afficher correctement le programme d’installation Oracle Universal Installer (OUI).

1.2 Configuration réseau requise

- Il est recommandé de s’assurer que chaque nœud contient au moins trois cartes d’interface réseau (NIC). Une pour le réseau public et deux pour le réseau privé afin de garantir la haute disponibilité du cluster Oracle RAC. Si vous avez l’intention d’utiliser la fonctionnalité ASM (Automatic Storage Management) dans le cluster, vous devez disposer d’au moins un réseau Oracle ASM. Le réseau ASM peut partager l’interface réseau avec un réseau privé.

- Le nom des interfaces publiques, privées et ASM doivent être identiques sur tous les nœuds. Par exemple, si em1 est utilisé pour l’interface publique sur le nœud 1, tous les autres nœuds doivent avoir em1 comme nom d’interface publique

- Toutes les interfaces publiques de chaque nœud doivent pouvoir communiquer avec tous les nœuds du cluster.

- Toutes les interfaces privées et ASM de chaque nœud doivent pouvoir communiquer avec tous les nœuds du cluster.

- Le nom d’hôte de chaque nœud doit être conforme à la norme RFC 952 (www.ietf.org/rfc/rfc952.txt). Les noms d’hôte comprenant un trait de soulignement («_») ne sont pas autorisés.

1.3. Configuration requise pour le système d’exploitation

- Red Hat Enterprise Linux (RHEL) 7.x (Kernel 3.10.0-693.el7.x86_64 ou versions ultérieures)

1.3.1. Partition de disque du système d’exploitation

Vous trouverez ci-dessous les entrées du schéma de partitionnement de disque recommandées lors de l’installation de RHEL 7 à l’aide d’un fichier de démarrage sur les disques durs locaux, avec au moins 1,2 To d’espace disponible.

part /boot --asprimary --fstype="xfs" --ondisk=sda --size=1024

part pv.1 --size=1 --grow --ondisk=sda --asprimary

volgroup rhel7 pv.1

logvol / --name=root --fstype=xfs --vgname=rhel7 --size=51200

logvol swap --fstype swap --name=swap --vgname=rhel7 --size=17408

logvol /home --name=home --fstype=xfs --vgname=rhel7 --size=51200

logvol /var --name=var --fstype=xfs --vgname=rhel7 --size=20480

logvol /opt --name=opt --fstype=xfs --vgname=rhel7 --size=20480

logvol /tmp --name=tmp --fstype=xfs --vgname=rhel7 --size=5120

logvol /u01 --name=u01 --fstype=xfs --vgname=rhel7 --size=1 --grow

2. Préparation des serveurs pour l’installation d’Oracle

Avant d’installer la grille et la base de données, veillez à installer les scripts de déploiement Dell EMC ci-dessous, qui permettent de configurer l’environnement pour

l’installation de la base de données Oracle.

2.1. Connexion de systèmes au référentiel Red Hat Network (RHN)/Unbreakable Linux Network (LSN)

Toutes les conditions requises doivent être respectées avant d’installer Grid/Database.

Étape 1 :

- rhel-7-server-optional-rpms

- rhel-7.x

Configuration d’un référentiel yum local pour installer automatiquement les autres RPM de dépendance, pour l’installation de la grille/base de données.

- La configuration recommandée consiste à servir les fichiers sur http à l’aide d’un serveur Apache (nom du package : httpd). Cette section traite de l’hébergement des fichiers de référentiel à partir d’un stockage sur un système de fichiers local. Bien que d’autres options pour héberger des fichiers de référentiel existent, elles ne sont pas traitées dans ce document. Il est vivement recommandé d’utiliser le stockage sur système de fichiers local pour accélérer et simplifier la maintenance.

mkdir /media/myISO

mount -o loop myISO.iso /media/myISO

- Pour installer et configurer le processus http, configurez la machine qui hébergera le référentiel pour toutes les autres machines afin d’utiliser l’image DVD en local. Créez le fichier /etc/yum.repos.d/local.repo et saisissez les éléments suivants :

[local]

name=Local Repository

baseurl=file:///media/myISO

gpgcheck=0

enabled=0

- À présent, nous allons installer le processus de service Apache avec la commande suivante, qui permet également d’activer temporairement le référentiel local pour la résolution de la dépendance :

yum -y install httpd --enablerepo=local

- Pour utiliser Apache comme référentiel, copiez le contenu du DVD dans un répertoire Web publié. Exécutez les commandes suivantes en tant que root (assurez-vous de remplacer myISO par le nom de votre image ISO) :

cp -R /media/myISO/* /var/www/html/myISO

- Cette étape est nécessaire uniquement si vous exécutez SELinux sur le serveur qui héberge le référentiel. La commande suivante doit être exécutée en tant que root et permet de restaurer le contexte SELinux approprié sur les fichiers copiés :

- La dernière étape consiste à collecter le nom DNS ou l’adresse IP du serveur hébergeant le référentiel. Le nom DNS ou l’adresse IP du serveur d’hébergement est utilisé pour configurer le fichier repo du référentiel yum sur le serveur client. La liste suivante présente un exemple de configuration utilisant le support de serveur RHEL 7.x, qui se trouve dans le fichier de configuration : /etc/yum.repos.d/myRepo.repo

[myRepo]

name=RHEL 7.x Base ISO DVD

baseurl= http://reposerver.mydomain.com/myISO

enabled=1

gpgcheck=0

- Installez le RPM compat-libstdc++ manuellement à l’aide de la commande rpm ou yum, dans le répertoire dans lequel les RPM sont copiés.

Exemple : rpm -ivh

yum localinstall -y

Étape 3 :

- Installez les RPM compat-libstdcc++ en exécutant la commande suivante :

yum install –y compat-libstdc++.i686

yum install –y compat-libstdc++.x86_64

- Téléchargez/Copiez les RPM fournis par DELL en accédant à la page RPM de déploiement Dell Oracle pour Oracle 12cR2 sur RHEL7.x (en anglais) pour RH sur les serveurs où seront effectuées les installations GRID/DB. La liste des RPM est la suivante. Téléchargez uniquement les RPM nécessaires.

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

dell-redhat-rdbms-12cR2-preinstall-2018.06-1.el7.noarch.rpm est conçu pour effectuer les opérations suivantes :

- Désactiver transparent_hugepages in grub2.cfg

- Désactiver numa in grub2.cfg

- Créer un utilisateur et des groupes Oracle oinstall et dba

- Définir les paramètres du noyau sysctl

- Définir des limites d’utilisateur (nofile, nproc, pile) pour l’utilisateur Oracle

- Définir le fichier NOZEROCONF=yes in /etc/sysconfig/network

- Créer un utilisateur Grid et des groupes asmadmin, asmdba, asmoper, backupdba, dgdba, kmdba

- Définir des limites d’utilisateur (nofile, nproc, pile) pour l’utilisateur Grid

- Définir les paramètres du noyau sysctl

- Définir RemoveIPC=no pour garantir que les sémaphores définis pour les utilisateurs ne sont pas perdus après la déconnexion de l’utilisateur.

- Installer ces deux RPM

yum localinstall –y dell-redhat-rdbms-utilities-2018.06-1.el7.noarch.rpm

2.2. Configuration du réseau

2.2.1. Réseau public

Pour configurer le réseau public sur chaque nœud

- Connectez-vous en tant qu’utilisateur root.

- Accédez à /etc/sysconfig/network-scripts et modifiez le fichier ifcfg-em#, où # est le numéro du périphérique réseau.

NAME="Oracle Public"

DEVICE= "em1"

ONBOOT=yes

TYPE= Ethernet

BOOTPROTO=static

IPADDR=<adresse IP routable>

NETMASK=<masque de réseau>

GATEWAY=<adresse IP de la passerelle>

- Définissez le nom d’hôte via la commande ci-dessous.

hostnamectl set-hostname <nom d’hôte>

où <nom d’hôte> est le nom d’hôte que nous allons utiliser pour l’installation

- Saisissez service network restart pour redémarrer le service réseau.

- Saisissez ifconfig pour vérifier que les adresses IP sont correctement définies.

- Pour vérifier la configuration de votre réseau, envoyez une commande ping à chaque adresse IP publique à partir d’un client du LAN qui ne fait pas partie du cluster.

- Connectez-vous à chaque nœud pour vérifier que le réseau public fonctionne. Saisissez ssh pour vérifier le fonctionnement de la commande Secure Shell (ssh).

2.2.2. Réseau privé

L’exemple ci-dessous fournit des instructions pas à pas sur l’activation de l’interconnexion redondante à l’aide de HAIP sur une nouvelle installation Oracle 12c Grid Infrastructure.

- Modifiez le fichier /etc/sysconfig/network-scripts/ifcfg-emX, où X est le numéro d’appareil em et ifcfg-emX les fichiers de configuration des cartes réseau à utiliser pour l’interconnexion privée.

DEVICE=em2

BOOTPROTO=static

HWADDR=

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.140

NETMASK=255.255.255.0

DEVICE=em3

HWADDR=

BOOTPROTO=static

ONBOOT=yes

NM_CONTROLLED=yes

IPADDR=192.168.1.141

NETMASK=255.255.255.0

- Une fois que vous avez enregistré les deux fichiers de configuration, redémarrez votre service réseau à l’aide des commandes ci-dessous.

nmcli connection reload

nmcli device disconnect em2

nmcli connection up em2

- Répétez les étapes pour chaque interface qui a été modifiée.

- L’exécution des étapes ci-dessus a maintenant préparé votre système pour activer HAIP à l’aide du programme d’installation d’Oracle Grid Infrastructure. Une fois que vous avez rempli toutes les conditions préalables d’Oracle et que vous êtes prêt à installer Oracle, vous devez sélectionner em2 et em3 en tant qu’interfaces privées sur l’écran « Network Interface Usage ».

- Cette étape permet une interconnexion redondante une fois que l’installation d’Oracle Grid Infrastructure est terminée avec succès et qu’Oracle Grid Infrastructure est en cours d’exécution.

2.2.3. Réseau Oracle Flex ASM

Oracle Flex ASM peut utiliser les mêmes réseaux privés que Oracle Clusterware ou utiliser ses propres réseaux privés dédiés. Chaque réseau peut être classé PUBLIC ou PRIVATE+ASM ou PRIVATE ou ASM.

2.2.4. Configuration requise pour la résolution des adresses IP et des noms

Vous pouvez configurer l’adresse IP des nœuds de cluster à l’aide de l’une des options suivantes :

- Serveur de noms de domaine (DNS)

2.2.4.1. Serveur de noms de domaine (DNS)

Pour configurer Oracle 12C RAC à l’aide d’Oracle (sans GNS) :

Le tableau ci-dessous décrit les différentes interfaces, les paramètres d’adresse IP et les résolutions d’un cluster.

|

Interface

|

Type

|

Résolution

|

|

Publique

|

Parasite

|

DNS

|

|

Privée

|

Parasite

|

Non requise

|

|

ASM

|

Parasite

|

Non requise

|

|

Adresse IP virtuelle du nœud

|

Parasite

|

Non requise

|

|

Adresse IP virtuelle du nom SCAN

|

Parasite

|

Non requise

|

Configuration d’un serveur DNS

Pour configurer les modifications sur un serveur DNS pour un cluster Oracle 12c à l’aide d’un DNS (sans GNS) :

Configurez la résolution du nom SCAN sur le serveur DNS. Un nom SCAN configuré sur le serveur DNS à l’aide de la règle de permutation circulaire doit être résolu en trois adresses IP publiques (recommandé), mais la configuration minimale requise est une adresse IP publique.

Par exemple :

scancluster IN A 192.0.2.1

IN A 192.0.2.2

IN A 192.0.2.3

Où scancluster est le nom SCAN fourni lors de l’installation d’Oracle Grid.

Configuration d’un client DNS

Pour configurer les modifications requises sur les nœuds de cluster pour la résolution de noms :

- Vous devez configurer le fichier resolv.conf sur les nœuds du cluster pour qu’ils contiennent des entrées de serveur de noms pouvant être résolues pour le serveur DNS.

nmcli connection modify ipv4.dns ipv4.dns-search

- Assurez-vous que la configuration de commande /etc/nsswitch.conf contrôle la commande de service de noms. Dans certaines configurations, le NIS peut rencontrer des problèmes avec la résolution des adresses Oracle SCAN. Il est recommandé de placer l’entrée NIS à la fin de la liste de recherche.

Par exemple, hosts: dns files nis

3. Préparation du stockage partagé pour une installation Oracle RAC

Oracle RAC nécessite des LUN partagées pour le stockage de votre registre OCR (Oracle Cluster Registry), des voting disks, des fichiers Oracle Database et de la FRA (Flash Recovery Area). Le tableau suivant présente la conception de volume de stockage recommandée standard pour Oracle 12c Database.

| Type/Objectif du volume de base de données | Nombre de volumes | Taille du volume |

| OCR/VOTE | 3 | 50 Go chacun |

| DONNÉES | 4 | 250 Go1 chacun |

| REDO2 | 2 | Au moins 50 Go chacun |

| FRA | 1 | 100 Go3 |

| TEMP | 1 | 100GB |

1 - Ajustez la taille de chaque volume en fonction de votre base de données ; 2 - Il est recommandé de disposer d’au moins deux groupes de disques REDO ASM, chacun ayant au moins un volume de stockage ; 3 - Idéalement, la taille doit être de 1,5 fois la taille de la base de données si la capacité utile en stockage le permet.

la liaison de noms persistante entre les nœuds au sein du cluster.

3.1. Configuration de Device Mapper Multipath pour le stockage XtremIO

L’objet de Device Mapper Multipath est d’activer plusieurs chemins d’E/S, afin d’améliorer les performances et de fournir une dénomination cohérente. La gestion multichemin permet d’effectuer cette opération en combinant vos chemins d’E/S dans un seul chemin d’accès au mappeur d’appareils et en équilibrant correctement la charge des E/S. Cette section présente les pratiques d’excellence en matière de configuration de la gestion multivoie de votre mappeur d’appareils au sein de votre serveur Dell PowerEdge. Vérifiez que la version de votre pilote Device Mapper Multipath correspond à la version indiquée ci-dessous, ou à une version ultérieure :

- rpm -qa | grep device-mapper-multipath

device-mapper-multipath

- Activez Multipath avec la commande mpathconf –enable

- Configurez XtremIO Multipath en modifiant /etc/multipath.conf comme suit :

device {

vendor XtremIO

product XtremApp

path_grouping_policy multibus

path_checker tur

path_selector "queue-length 0"

rr_min_io_rq 1

user_friendly_names yes

fast_io_fail_tmo 15

failback immediate

}

- Ajoutez les noms conviviaux appropriés à chaque volume à l’aide du scsi_id correspondant. Vous pouvez obtenir les scsi_id avec la commande ci-dessous :

/usr/lib/udev/scsi_id -g -u -d /dev/sdX

- Localisez la section multivoie dans votre fichier /etc/multipath.conf. Dans cette section, vous devez fournir le scsi_id de chaque volume et fournir un alias afin de conserver une convention de dénomination cohérente sur tous vos nœuds. Un exemple est présenté ci-dessous :

multipaths {

multipath {

wwid <résultat de l’étape 4 pour le volume1>

alias alias_of_volume1

}

multipath {

wwid <résultat de l’étape 4 pour le volume2>

alias alias_of_volume2

}

}

- Redémarrez votre service de processus multivoie avec la commande

Service multipathd restart

- Vérifiez que votre alias de volumes multivoies s’affiche correctement.

multipath -ll

- Répétez toutes les étapes pour tous les nœuds.

3.2. Partitionnement du disque partagé

Cette section explique comment utiliser l’utilitaire partitionné pour créer une partition unique sur un volume/un disque virtuel couvrant l’intégralité du disque.

Partitionnez chaque volume de base de données qui a été configuré à l’aide de device-mapper en exécutant la commande suivante :

$> parted -s /dev/mapper/<volume1> mklabel msdos

$> parted -s /dev/mapper/<volume1> primary 2048s 100%

Répétez cette opération pour tous les volumes requis.

-

Répétez les étapes ci-dessus pour tous les volumes et redémarrez le service multipathd sur tous les autres nœuds.

systemctl restart multipathd.service

-

Redémarrez le système si la partition que vous venez de créer ne s’affiche pas correctement.

3.3 Utilisation des règles udev pour les autorisations et la persistance des disques

Red Hat Enterprise Linux 7.x permet d’utiliser des règles udev pour s’assurer que le système gère correctement les autorisations des nœuds d’appareils. Dans ce cas, les autorisations pour les LUN/volumes détectés par le système d’exploitation doivent être correctement définies. Il est important de noter que les règles udev sont exécutées dans un ordre énuméré. Lors de la création de règles udev pour la définition des autorisations, veuillez inclure le préfixe 60- et ajouter .rules à la fin du nom de fichier.

- Créez un fichier 60-oracle-asmdevices.rules dans /etc/udev/rules.d

- Assurez-vous que chaque appareil de bloc comporte une entrée dans le fichier, comme illustré ci-dessous.

#---------------------start udev rule contents ------------------------#

KERNEL=="dm-*", ENV =="C1_OCR1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_OCR3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA3p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_DATA4p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO1p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_REDO2p?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_FRA?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

KERNEL=="dm-*", ENV =="C1_TEMP?", OWNER:="grid", GROUP:="asmadmin", MODE="0660"

- Exécutez « udevadm trigger » pour appliquer la règle.

- Copiez les règles udev sur tous les nœuds et exécutez « udevadm trigger » pour appliquer les règles.

4. Installation d’Oracle 12c Grid Infrastructure pour un cluster

4.1 Configurez les paramètres de l’horloge système pour tous les nœuds

Pour éviter les échecs lors de la procédure d’installation, configurez tous les nœuds avec les mêmes paramètres d’horloge système. Synchronisez l’horloge système de votre nœud à l’aide du service CTSS (Cluster Time Synchronization Service) intégré à Oracle 12c. Pour activer le service CTSS, désactivez le service ntpd (network time protocol daemon) du système d’exploitation à l’aide des commandes suivantes dans l’ordre indiqué :

-

systemctl stop chronyd.service

-

systemctl disable chronyd.service

-

mv /etc/chrony.conf /etc/ntp.chrony.orig

Sauf indication contraire, les étapes suivantes sont destinées au nœud un de votre environnement de clusters.

- Connectez-vous en tant qu’utilisateur root.

- Si vous n’êtes pas dans un environnement graphique, démarrez le système X Windows en saisissant : startx

- Ouvrez une fenêtre de terminal et saisissez : xhost +

- Montez le support Oracle Grid Infrastructure.

- Connectez-vous en tant qu’utilisateur Grid, par exemple : su - grid.

- Saisissez la commande suivante pour démarrer Oracle Universal Installer : /runInstaller

- Dans la fenêtre Select Configuration Option, sélectionnez Configure Grid Infrastructure for a Cluster, puis cliquez sur Next.

- Dans la fenêtre Cluster Configuration, sélectionnez Configure an Oracle Standalone Cluster, puis cliquez sur Next.

- Dans la fenêtre Grid Plug and Play Information, saisissez les informations suivantes :

-

Cluster Name : saisissez un nom pour le cluster.

-

SCAN Name : saisissez le nom enregistré dans le serveur DNS, qui est unique pour l’ensemble du cluster. Pour plus d’informations sur la configuration du nom SCAN, consultez la section « Configuration requise pour la résolution des adresses IP et des noms ».

-

SCAN Port : conservez le port par défaut 1521.

-

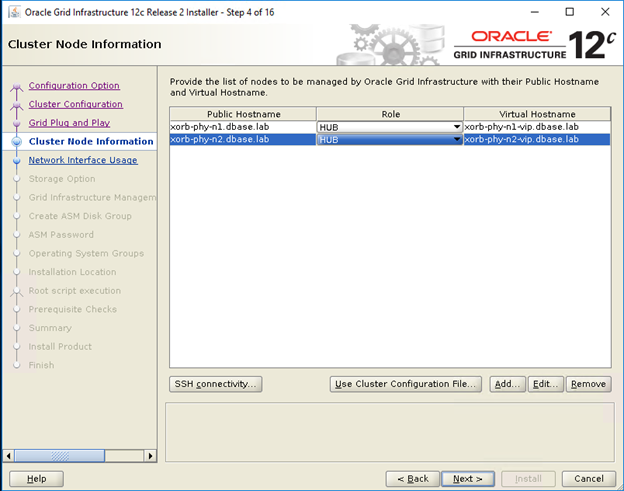

- Dans la fenêtre Cluster Node Information, cliquez sur Add pour ajouter des nœuds supplémentaires qui doivent être gérés par Oracle Grid Infrastructure.

- Saisissez les informations de nom d’hôte public pour les nœuds membres des clusters Hub et Leaf.

- Saisissez le rôle du nœud membre du cluster.

- Répétez les 3 étapes ci-dessus pour chaque nœud du cluster.

- Cliquez sur la connexion SSH et configurez la connexion SSH sans mot de passe en saisissant le mot de passe du système d’exploitation de l’utilisateur Grid, puis cliquez sur Setup.

- Cliquez sur OK, puis cliquez sur Next pour accéder à la fenêtre suivante.

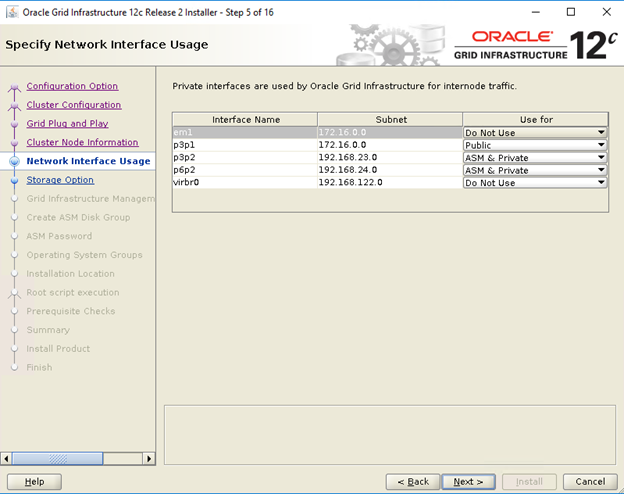

- Dans la fenêtre Specify Network Interface Usage, assurez-vous que les types d’utilisation de l’interface appropriés sont sélectionnés pour les noms d’interface. Dans la liste déroulante Use for, sélectionnez le type d’interface requis. Les options disponibles sont les suivantes : Public, Private ASM, ASM et Private. Cliquez sur Suivant.

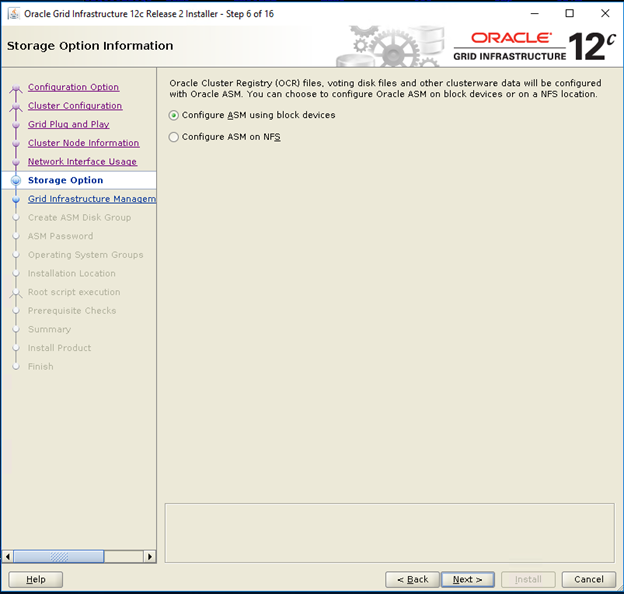

- Dans la fenêtre Storage option information, sélectionnez Configure ASM using block devices, puis cliquez sur Next.

- Dans la fenêtre Grid Infrastructure Management Repository Option, sélectionnez No pour Configure Grid Infrastructure Management, puis cliquez sur Next.

- Dans la fenêtre Create ASM Disk Group, saisissez les informations suivantes :

-

Disk Group Name : saisissez un nom, par exemple : OCR

-

Redundancy : pour les disques OCR et voting, sélectionnez High si cinq disques ASM sont disponibles, sélectionnez Normal si trois disques ASM sont disponibles ou sélectionnez External si un disque ASM est disponible (non recommandé).

-

- Dans la fenêtre ASM Password, sélectionnez l’option appropriée sous Specify the passwords for these accounts et saisissez les valeurs pertinentes pour le mot de passe. Cliquez sur Suivant.

- Dans la fenêtre Failure Isolation Support, sélectionnez Do Not use Intelligent Platform Management Interface (IPMI).

- Dans la fenêtre Management options, sélectionnez default, puis cliquez sur Next.

- Dans la fenêtre Privileged Operating Systems Groups, sélectionnez :

-

asmdba pour Oracle ASM DBA (OSASM) Group

-

asmoper pour Oracle ASM Operator (OSOPER) Group

-

asmdba pour Oracle ASM Administrator (OSDBA) Group

-

- Dans la fenêtre Specify Installation Location, spécifiez les valeurs de votre base Oracle et l’emplacement du logiciel, tels que configurés dans les Dell Oracle utilities RPM

- Base Oracle : /u01/app/grid

- Emplacement du logiciel : /u01/app/12.1.0/grid_1

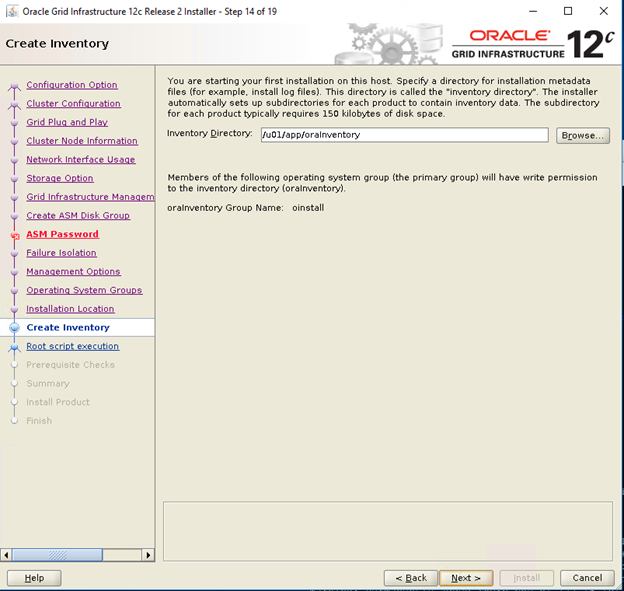

- Dans la fenêtre Create Inventory, spécifiez l’emplacement de votre répertoire d’inventaire. Cliquez sur Suivant.

L’emplacement par défaut basé sur le Dell Oracle utilities RPM pour le répertoire d’inventaire est /u01/app/oraInventory.

L’emplacement par défaut basé sur le Dell Oracle utilities RPM pour le répertoire d’inventaire est /u01/app/oraInventory.

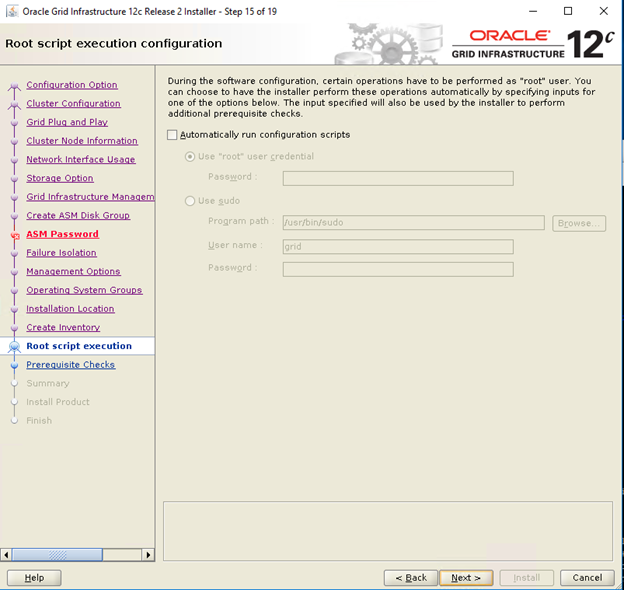

- Dans la fenêtre Root script execution configuration, désélectionnez Automatically run configuration scripts, puis cliquez sur Next.

- Dans la fenêtre Summary, vérifiez tous les paramètres et sélectionnez Install.

- Dans la fenêtre Install Product, vérifiez l’état de l’installation Grid Infrastructure.

- Dans la fenêtre Execute Configuration Scripts, exécutez les scripts root.sh sur les deux nœuds, puis cliquez sur OK.

- Dans la fenêtre Finish, cliquez sur Close.

5. Installation d’Oracle 12c Database

5.1. Installation du logiciel Oracle 12c Database (RDBMS)

Sauf indication contraire, les étapes suivantes concernent le nœud 1 de votre environnement de clusters.

- Connectez-vous en tant qu’utilisateur root et saisissez : xhost+.

- Montez le support Oracle 12c Database.

- Connectez-vous en tant qu’utilisateur Oracle en saisissant : su - oracle.

- Exécutez le script du programme d’installation à partir de votre support Oracle Database :

<CD_mount>/runInstaller

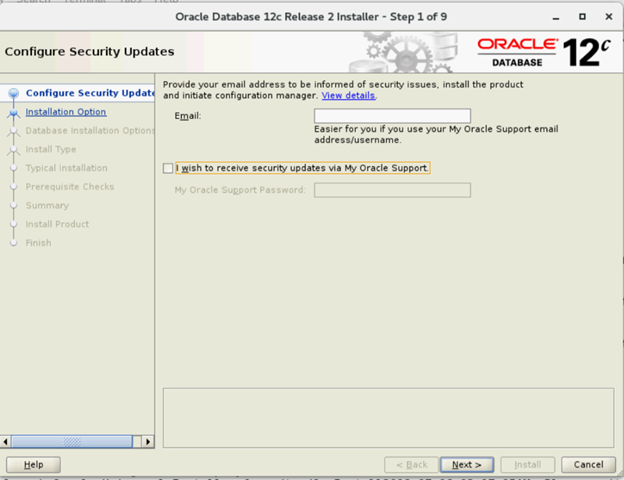

- Dans la fenêtre Configure Security Updates, saisissez vos informations d’identification My Oracle Support pour recevoir les mises à jour de sécurité, sinon cliquez sur Next.

- Dans la fenêtre Select Installation Option, sélectionnez Install database software only.

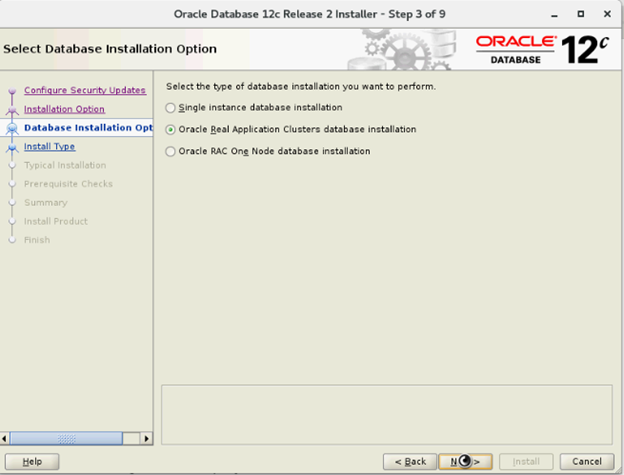

- Dans la fenêtre Select Database Installation Options, sélectionnez Oracle Real Application Clusters database installation, puis cliquez sur Next.

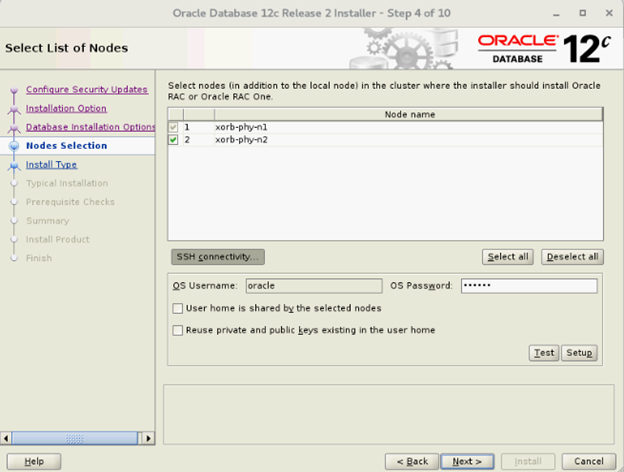

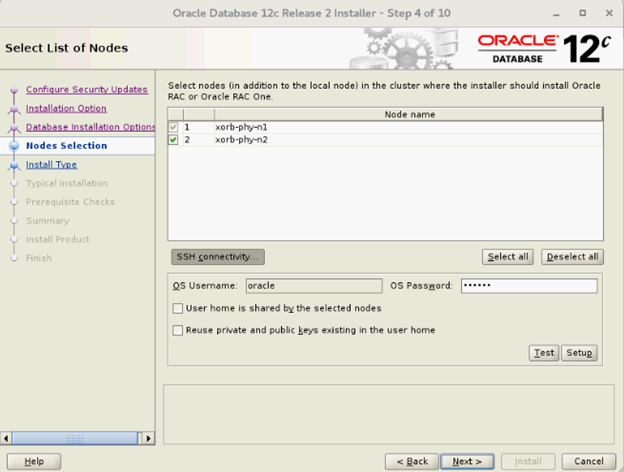

- Dans la fenêtre Select List of Nodes, sélectionnez tous les nœuds Hub et omettez les nœuds Leaf, puis cliquez sur SSH Connectivity et configurez votre connexion SSH sans mot de passe en saisissant le mot de passe du système d’exploitation de l’utilisateur Oracle et en sélectionnant Setup. Cliquez sur OK, puis sur Next pour accéder à la fenêtre suivante

- Dans la fenêtre Select Database Installation Options, sélectionnez Oracle Real Application Clusters database installation, puis cliquez sur Next.

- Dans la fenêtre Select List of Nodes, sélectionnez tous les nœuds Hub et omettez les nœuds Leaf, puis cliquez sur SSH Connectivity et configurez votre connexion SSH sans mot de passe en saisissant le mot de passe du système d’exploitation de l’utilisateur Oracle et en sélectionnant Setup. Cliquez sur OK, puis sur Next pour accéder à la fenêtre suivante

- Dans la fenêtre Select Database Edition, sélectionnez Enterprise Edition, puis cliquez sur Next.

- Dans la fenêtre Specify Installation Location, spécifiez l’emplacement de votre base Oracle configuré dans Dell Oracle utilities RPM.

- Oracle base : /u01/app/oracle

- Software location : /u01/app/oracle/product/12.1.0/dbhome_2

- Dans la fenêtre Privileged Operating System Groups, sélectionnez dba for Database Administrator (OSDBA) group, dba pour Database Operator (OSOPER) group, backupdba pour Database Backup and Recovery (OSBACKUPDBA) group, dgdba pour Data Guard administrative (OSDGDBA) group et kmdba pour Encryption Key Management administrative (OSKMDBA) group, puis cliquez sur Next.

- Dans la fenêtre Summary, vérifiez les paramètres et sélectionnez Install.

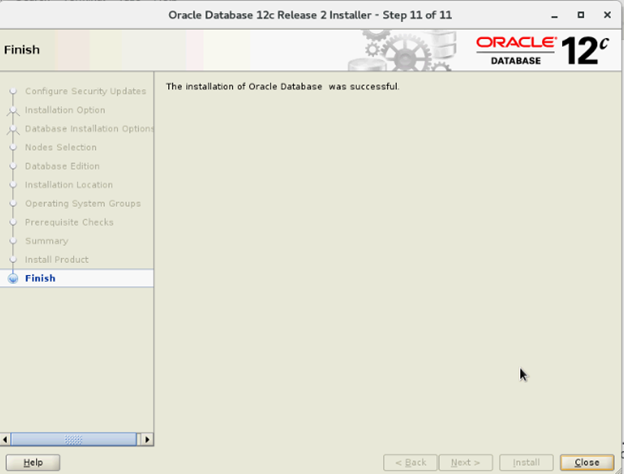

- À la fin du processus d’installation, l’Assistant Execute Configuration scripts s’affiche. Suivez les instructions de l’Assistant, puis cliquez sur OK.

- Dans la fenêtre Finish, cliquez sur Close.

6. Création d’un groupe de disques à l’aide de l’Assistant de configuration ASM (ASMCA)

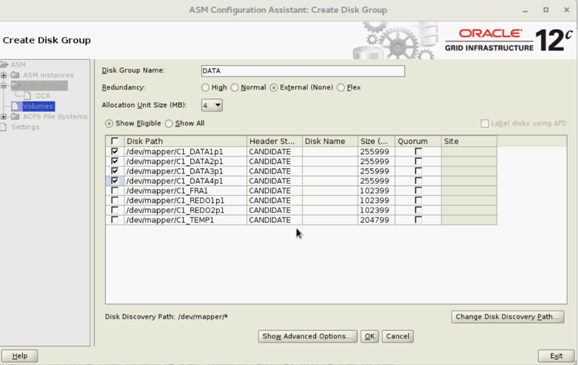

Cette section contient les procédures de création du groupe de disques ASM pour les fichiers de base de données et la FRA (Flashback Recovery Area).

- Connectez-vous en tant qu’utilisateur Grid, démarrez l’Assistant ASMCA à partir de /u01/app/12.2.0/grid/bin/asmca.

- Créez un groupe de disques « DATA » avec redondance externe en sélectionnant les disques candidats appropriés.

- Créez deux groupes de disques « REDO », REDO1 et REDO2, avec redondance externe en sélectionnant au moins un disque candidat par groupe de disques REDO.

- Créez un groupe de disques « FRA » avec redondance externe en sélectionnant les disques candidats appropriés.

- Créez un groupe de disques « TEMP » avec redondance externe en sélectionnant les disques candidats appropriés.

- Vérifiez tous les groupes de disques requis, puis cliquez sur Exit pour fermer l’utilitaire ASMCA.

- Définissez un niveau d’agrégation ASM précis pour les groupes de disques REDO, TEMP et FRA, en tant qu’utilisateur Grid, en utilisant les commandes ci-dessous.

SQL> ALTER DISKGROUP REDO ALTER TEMPLATE onlinelog ATTRIBUTES (fine)

SQL> ALTER DISKGROUP TEMP ALTER TEMPLATE tempfile ATTRIBUTES (fine)

7. Création d’une base de données à l’aide de DBCA

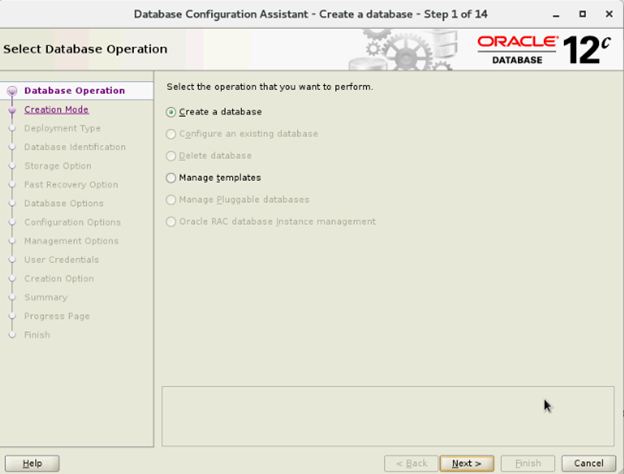

Sauf indication contraire, les étapes suivantes s’appliquent au nœud 1 de votre environnement de clusters.

- Connectez-vous en tant qu’utilisateur Oracle.

- À partir de $, exécutez l’utilitaire DBCA en saisissant : $/bin/dbca

- Dans la fenêtre Select Database Operation, sélectionnez Create Database, puis cliquez sur Next.

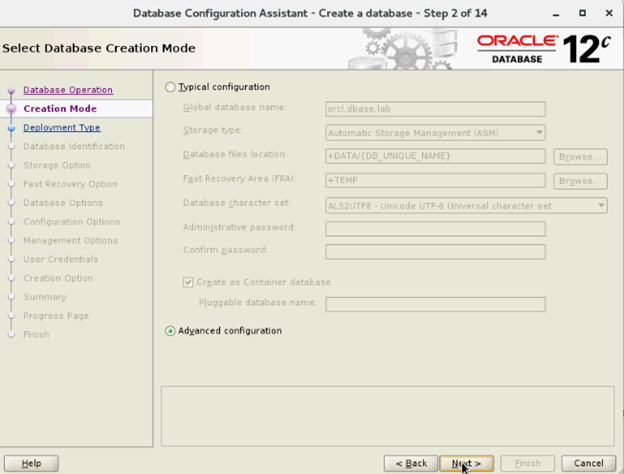

- Dans la fenêtre Select Creation Mode, sélectionnez Advanced Mode et cliquez sur Next.

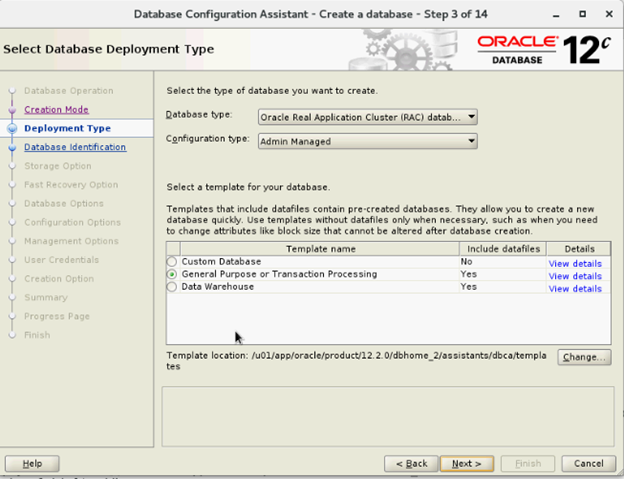

- Dans la fenêtre Select Database Deployment, sélectionnez Oracle Real Application Cluster (RAC) database dans Database type, Admin-managed pour Configuration type et sélectionnez le modèle, puis cliquez sur Next.

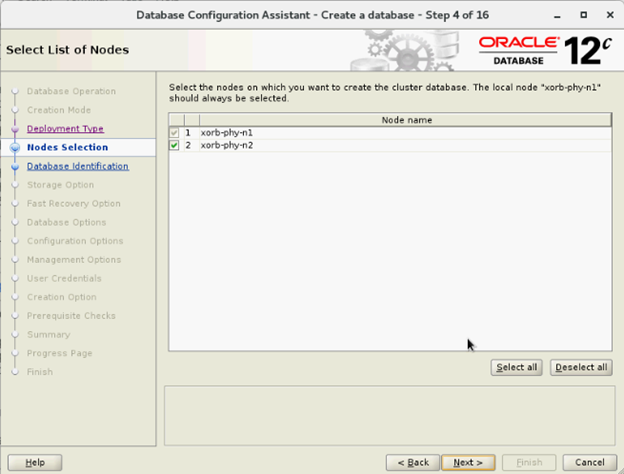

- Dans la fenêtre Select List of nodes, sélectionnez les nœuds, puis cliquez sur Next.

- Dans la fenêtre Specify Database Identification Details :

- Dans la fenêtre Storage Options, sélectionnez l’emplacement de stockage des fichiers de données et désélectionnez l’option Use Oracle- Managed Files (OMF) et cliquez sur Next.

- Dans la fenêtre Select Fast Recovery Option, sélectionnez Specify Fast Recovery Area location, puis cliquez sur Next.

- Dans la fenêtre Select Oracle Data Vault Config Option, sélectionnez les valeurs par défaut et cliquez sur Next.

- Dans la fenêtre Specify Configuration Options, définissez les valeurs SGA et PGA requises, puis cliquez sur Next.

- Dans la fenêtre Specify Management Options, sélectionnez default, puis cliquez sur Next.

- Dans la fenêtre Specify Database User Credentials, saisissez le mot de passe et cliquez sur Next.

- Dans la fenêtre Select Database Creation Options, cliquez sur Customize Storage Locations.

- Créez/Modifiez les groupes de journaux redo log en fonction des recommandations de conception suivantes :

| Nombre de groupes de journaux Redo | Nombre de threads | Emplacement du groupe de disques | Taille des journaux redo log |

| 1 | 1 | +REDO1 | 5 Go |

| 2 | 1 | +REDO2 | 5 Go |

| 3 | 1 | +REDO1 | 5 Go |

| 4 | 1 | +REDO2 | 5 Go |

| 5 | 2 | +REDO1 | 5 Go |

| 6 | 2 | +REDO2 | 5 Go |

| 7 | 2 | +REDO1 | 5 Go |

| 8 | 2 | +REDO2 | 5 Go |

- Dans la fenêtre Summary, cliquez sur Finish pour créer une base de données.

- Cliquez sur Close dans la fenêtre Finish à la fin de la création de la base de données.

Article Properties

Affected Product

Red Hat Enterprise Linux Version 7

Last Published Date

21 Feb 2021

Version

4

Article Type

How To