PowerEdge: Skalerbarhet av Dell Ready Solutions for HPC BeeGFS-lagring

Summary: Slik skalerer du Dell BeeGFS-lagringsløsningen med høy ytelse når det gjelder kapasitet eller ytelse, eller begge deler.

Instructions

Innholdsfortegnelse

- Innledning

- Basiskonfigurasjoner

- BeeGFS anvendelig plassberegning

- Skalerbare konfigurasjoner

- Karakterisering av ytelse

- Konklusjon og videre arbeid

Innledning

Denne bloggen drøfter skalerbarheten til Dell Ready Solutions for HPC BeeGFS-lagring, som ble annonsert nylig. BeeGFS-arkitekturen består av fire hovedtjenester, administrasjonstjenesten, metadatatjenesten, lagringstjenesten og klienttjenesten. Det er mulig å kjøre en hvilken som helst kombinasjon av disse fire hovedtjenestene, inkludert alle, på samme server, fordi rollene og maskinvaren ikke er tett integrert når det gjelder BeeGFS. I en "hyperkonvergerende løsning" kjører alle fire tjenestene på samme server. Denne konfigurasjonen anbefales ikke for ytelseskritiske miljøer fordi klientprogrammer vanligvis bruker ressurser som kan påvirke ytelsen til lagringstjenestene. Dell-løsningen bruker dedikerte lagringsservere og en metadata- og lagringsserver med to formål for å gi en skalerbar lagringsløsning med høy ytelse. Det er mulig å skalere systemet ved å legge til flere lagringsservere til et eksisterende system. I denne bloggen presenterer vi konfigurasjoner med ulikt antall lagringsservere og ytelsen som kan forventes med disse konfigurasjonene.

Basiskonfigurasjoner

BeeGFS-lagringsløsningen, som er utformet for å gi et arbeidsfilsystem med høy ytelse, bruker følgende maskinvarekomponenter:

- Administrasjonsserver

- R640, Dual Intel Xeon Gold 5218 2,3 GHz, 16 kjerner, 96 GB (12x 8 GB 2666 MT/s RDIMMs), 6 x 15k RPM 300 GB SAS, H740P

- Metadata og lagringsservere

- R740xd, 2 Intel Xeon Platinum 8268 CPU @ 2,90 GHz, 24 kjerner, 384 GB (12x 32 GB 2933 MT/s RDIMMs)

- BOSS-kort med 2 240 GB M.2 SATA SSD-disker i RAID 1 for OS

- 24x, Intel 1,6 TB, NVMe, Express-Flash for blandet bruk, 2,5 SFF-disker, programvare-RAID

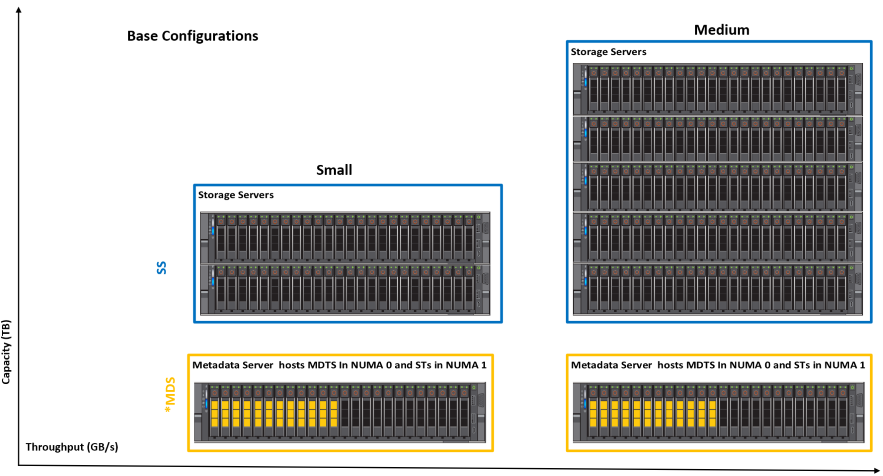

Administrasjonsserveren kjører overvåkingstjenesten BeeGFS. Metadataserveren bruker de 12 stasjonene på NUMA 0-sonen for å være vert for metadatamålene (MDT-er), mens de resterende 12 stasjonene på NUMA 1-sonen er vert for lagringsmålene (ST-er). En dedikert metadataserver brukes ikke fordi kravene til lagringskapasitet for BeeGFS-metadata er små. Metadata og lagringsmål og tjenester er isolert på separate NUMA-noder, slik at en betydelig separasjon av arbeidsbelastninger er etablert. Lagringsserverne som brukes i konfigurasjonen har tre lagringstjenester som kjører per NUMA-sone, seks totalt per server. Hvis du vil ha mer informasjon, kan du se kunngjøringsbloggen. Figur 1 viser de to basiskonfigurasjonene som er testet og validert ved Dell EMC HPC og AI Innovation Lab

Figur 1: Basiskonfigurasjoner

Den lille konfigurasjonen består av tre R740xd-servere. Den har 15 lagringsmål. Medium-konfigurasjonen har 6xR740xd-servere og har 33 lagringsmål. Brukeren kan starte med en "Liten" konfigurasjon eller med "Medium"-konfigurasjonen og kan legge til lagrings- eller metadataservere etter behov for å øke lagringsplassen og den generelle ytelsen, eller antall filer og metadataytelse. Tabell 1 viser ytelsesdata for basiskonfigurasjonene som har blitt testet og validert i stor grad ved Dell HPC og AI Innovation Lab.

| Basiskonfigurasjon | Liten | Middels | |

|---|---|---|---|

| Total U (MDS+SS) | 6U | 12U | |

| # av dedikerte lagringsservere | 2 | 5 | |

| # NVMe-disker for datalagring | 60 | 132 | |

| Anslått tilgjengelig plass | 1,6 TB | 86 TiB | 190 TiB |

| 3,2 TB | 173 TiB | 380 TiB | |

| 6,4 TB | 346 TiB | 761 TiB | |

| Topp sekvensiell lesing | 60,1 GB/s | 132,4 GB/s | |

| Topp sekvensiell skriving | 57,7 GB/s | 120,7 GB/s | |

| Tilfeldig lest | 1,80 millioner IOPS | 3,54 millioner IOPS | |

| Tilfeldig skriving | 1,84 millioner IOPS | 3,59 millioner IOPS | |

Tabell 1: Detaljer om kapasitet og ytelse for basiskonfigurasjoner

BeeGFS anvendelig plassberegning

Beregnet brukbar plass beregnes i TiB (siden de fleste verktøy viser brukbar plass i binære enheter) ved hjelp av følgende formel:

BeeGFS Usable Space in TiB= (0.99* # of Drives* size in TB * (10^12/2^40)

I formelen ovenfor er 0,99 faktoren som er kommet frem ved å anta konservativt at det er en 1% overhead fra filsystemet. For å komme frem til antall disker for lagring, er 12 disker fra MDS også inkludert. Dette skyldes at i MDS brukes de 12 stasjonene i NUMA-sone 0 til metadata og de 12 stasjonene i NUMA-sone 1 brukes til lagring. Den siste faktoren i formelen 10 ^ 12 / 2 ^ 40 er å konvertere brukbar plass fra TB til TiB.

Skalerbare konfigurasjoner

BeeGFS High-Performance Storage Solution er designet for å være fleksibel, og man kan enkelt og sømløst skalere ytelse og/eller kapasitet ved å legge til flere servere som vist nedenfor:

Figur 2: Eksempler på skalert konfigurasjon

Metadatadelen av stakken forblir den samme for alle konfigurasjonene ovenfor som er beskrevet i denne bloggen. Dette skyldes at kravene til lagringskapasitet for BeeGFS-metadata vanligvis er 0,5 % til 1 % av den totale lagringskapasiteten. Det avhenger imidlertid av antall kataloger og filer i filsystemet. Som en generell regel kan brukeren legge til en ekstra metadataserver når prosentandelen av metadatakapasiteten til lagringen faller under 1 %. Tabell 2 viser ytelsesdata for de ulike fleksible konfigurasjonene til BeeGFS-lagringsløsningen.

| Konfigurasjon | Liten | Liten +1 | Liten +2 | Middels | Middels +1 | |

|---|---|---|---|---|---|---|

| Total U (MDS+SS) | 6U | 8U | 10U | 12U | 14U | |

| # av dedikerte lagringsservere | 2 | 3 | 4 | 5 | 6 | |

| # NVMe-disker for datalagring | 60 | 84 | 108 | 132 | 156 | |

| Anslått tilgjengelig plass | 1,6 TB | 86 TiB | 121 TiB | 156 TiB | 190 TiB | 225 TiB |

| 3,2 TB | 173 TiB | 242 TiB | 311 TiB | 380 TiB | 449 TiB | |

| 6,4 TB | 346 TiB | 484 TiB | 622 TiB | 761 TiB | 898 TiB | |

| Topp sekvensiell lesing | 60,1 GB/s | 83,3 GB/s | 105,2 GB/s | 132,4 GB/s | 152,9 GB/s | |

| Topp sekvensiell skriving | 57,7 GB/s | 80,3 GB/s | 99,8 GB/s | 120,7 GB/s | 139,9 GB/s | |

Tabell 2: Detaljer om kapasitet og ytelse for skalerte konfigurasjoner

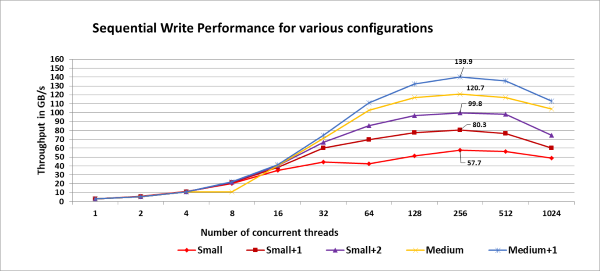

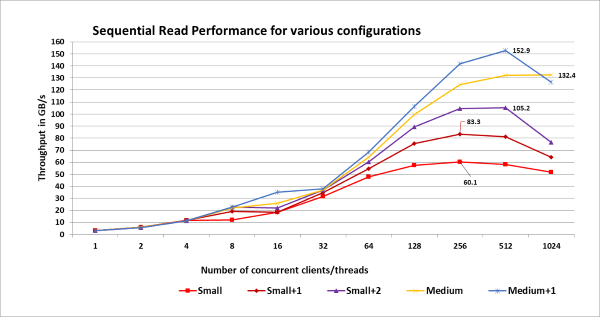

Karakterisering av ytelse

Ytelsen til de ulike konfigurasjonene ble testet ved å opprette lagringsgrupper. Den lille konfigurasjonen har 15 lagringsmål, og hver ekstra lagringsserver legger til ytterligere seks lagringsmål. Så for å teste ytelsen til de forskjellige konfigurasjonene ble lagringsgrupper opprettet fra 15 til 39 lagringsmål (trinn på seks for små, små + 1, små + 2, medium, middels + 1). For hver av disse puljene ble det kjørt tre iterasjoner av IOzone-referansen, hver med én til 1024 tråder (i potenser på to trinn). Testmetodikken som er vedtatt er den samme som beskrevet i kunngjøringsbloggen . Figur 3 og 4 viser henholdsvis skrive- og leseytelsen til de skalerbare konfigurasjonene, med topp ytelse for hver av konfigurasjonene uthevet for klar referanse:

Figur 3: Skrive ytelse for skalerbare konfigurasjoner.

Figur 4: Les ytelsen til skalerbare konfigurasjoner.

Merk:

Lagringsbassenget det refereres til, ble opprettet bare for det eksplisitte formål å karakterisere ytelsen til forskjellige konfigurasjoner. Mens vi gjorde ytelsesevalueringen av mediumkonfigurasjonen som er beskrevet i kunngjøringsbloggen, var alle de 33 målene bare i "standardutvalget". Utgangen av beegfs-ctl --liststoragepools Kommandoen nedenfor viser tildelingen av lagringsmålene:

# beegfs-ctl --liststoragepools Pool ID Pool Description Targets Buddy Groups ======= ================== ============================ ============================ 1 Default 1,2,3,4,5,6,7,8,9,10,11,12, 13,14,15,16,17,18,19,20,21, 22,23,24,25,26,27,28,29,30, 31,32,33

Konklusjon og videre arbeid

Denne bloggen drøftet skalerbarheten til Dell Ready Solutions for HPC BeeGFS-lagring og fremhevet ytelsen for sekvensiell lese- og skrivegjennomstrømming for ulike konfigurasjoner. Følg med for del 3 av denne bloggserien som vil diskutere flere funksjoner i BeeGFS og fremhever bruken av "StorageBench", den innebygde lagringsmålstandarden til BeeGFS. Som en del av de neste trinnene vil vi publisere en hvitbok senere med metadataytelsen, IOR N-1-ytelsesevaluering og med ytterligere detaljer om designhensyn, justering og konfigurasjon.

Referanser

[1] Dell Ready Solutions for HPC BeeGFS-lagring:

https://www.dell.com/support/article/sln319381/[2] BeeGFS-dokumentasjon:

https://www.beegfs.io/wiki/[3] Slik kobler du sammen to grensesnitt på samme delnett:

https://access.redhat.com/solutions/30564[4] PCI Express Direct Memory Access Reference Design using External Memory: https://www.intel.com/content/www/us/en/programmable/documentation/nik1412547570040.html#nik1412547565760