PowerEdge: Skalbarheten hos Dell Ready Solutions för HPC BeeGFS-lagring

Summary: Så här skalar du Dell BeeGFS-lagringslösningen med hög prestanda i termer av kapacitet eller prestanda, eller både och.

Instructions

Innehållsförteckning

- Introduktion

- Baskonfigurationer

- BeeGFS Beräkning av användbart utrymme

- Skalbara konfigurationer

- Karakterisering av prestanda

- Slutsats och framtida arbete

Introduktion

I den här bloggen diskuteras skalbarheten hos Dell Ready Solutions för HPC BeeGFS-lagring som tillkännagavs nyligen. BeeGFS-arkitekturen består av fyra huvudtjänster, hanteringstjänsten, metadatatjänsten, lagringstjänsten och klienttjänsten. Det är möjligt att köra vilken kombination som helst av dessa fyra huvudtjänster, inklusive dem alla, på samma server, eftersom rollerna och hårdvaran inte är tätt integrerade i fallet med BeeGFS. I en "hyperkonvergerad lösning" körs alla fyra tjänsterna på samma server. Den här konfigurationen rekommenderas inte för prestandakritiska miljöer eftersom klientprogram vanligtvis förbrukar resurser som kan påverka lagringstjänsternas prestanda. Dell-lösningen använder dedikerade lagringsservrar och en dubbel metadata- och lagringsserver för att tillhandahålla en högpresterande, skalbar lagringslösning. Det är möjligt att skala systemet genom att lägga till ytterligare lagringsservrar till ett befintligt system. I den här bloggen presenterar vi konfigurationer med olika antal lagringsservrar och den prestanda som kan förväntas med dessa konfigurationer.

Baskonfigurationer

BeeGFS-lagringslösningen, som är utformad för att tillhandahålla ett högpresterande skrapfilssystem, använder följande hårdvarukomponenter:

- Hanteringsserver

- R640, dubbla Intel Xeon Gold 5218 2,3 GHz, 16 kärnor, 96 GB (12 × 8 GB 2 666 MT/s RDIMM-moduler), 6 × 15 000 v/min 300 GB SAS, H740P

- Metadata- och lagringsservrar

- R740xd, 2 × Intel Xeon Platinum 8268 processor @ 2,90 GHz, 24 kärnor, 384 GB (12 × 32 GB 2 933 MT/s RDIMM-moduler)

- BOSS-kort med 2 × 240 GB M.2 SATA SSD-hårddiskar i RAID 1 för operativsystem

- 24 ×, Intel 1,6 TB, NVMe, Express Flash för blandad användning, 2,5 SFF-enheter, programvarubaserad RAID

Hanteringsservern kör övervakningstjänsten BeeGFS. Metadataservern använder de 12 enheterna i NUMA 0-zonen som värd för metadatamålen (MDT), medan de återstående 12 enheterna i NUMA 1-zonen är värdar för lagringsmålen (STs). En dedikerad metadataserver används inte eftersom kraven på lagringskapacitet för BeeGFS-metadata är små. Metadata och lagringsmål och -tjänster isoleras på separata NUMA-noder så att en betydande separation av arbetsbelastningar upprättas. De lagringsservrar som används i konfigurationen har tre lagringstjänster som körs per NUMA-zon, sex totalt per server. Mer information finns i blogginlägget om tillkännagivandet. Bild 1 visar de två baskonfigurationer som har testats och validerats vid Dell EMC HPC och AI Innovation Lab

Bild 1: Baskonfigurationer

Den lilla konfigurationen består av tre R740xd-servrar. Den har 15 lagringsmål. Den medelstora konfigurationen har 6xR740xd-servrar och har 33 lagringsmål. Användaren kan börja med en "liten" konfiguration eller med konfigurationen "medelstor" och kan lägga till lagrings- eller metadataservrar efter behov för att öka lagringsutrymmet och övergripande prestanda, eller antalet filer respektive metadataprestanda. Tabell 1 visar prestandadata för baskonfigurationerna som har testats och validerats i stor utsträckning av Dell HPC och AI Innovation Lab.

| Baskonfiguration | Liten | Medel | |

|---|---|---|---|

| Totalt U (MDS + SS) | 6U | 12U | |

| # av dedikerade lagringsservrar | 2 | 5 | |

| # NVMe-enheter för datalagring | 60 | 132 | |

| Uppskattat användbart utrymme | 1,6 TB | 86 TiB | 190 TiB |

| 3,2 TB | 173 TiB | 380 TiB | |

| 6,4 TB | 346 TiB | 761 TiB | |

| Högsta sekventiella läsning | 60,1 GB/s | 132,4 GB/s | |

| Maximalt antal sekventiella skrivningar | 57,7 GB/s | 120,7 GB/s | |

| Slumpmässig läsning | 1,80 miljoner IOPS | 3,54 miljoner IOPS | |

| Slumpmässig skrivning | 1,84 miljoner IOPS | 3,59 miljoner IOPS | |

Tabell 1: Information om kapacitet och prestanda för baskonfigurationer

BeeGFS Beräkning av användbart utrymme

Uppskattat användbart utrymme beräknas i TiB (eftersom de flesta verktyg visar användbart utrymme i binära enheter) med hjälp av följande formel:

BeeGFS Usable Space in TiB= (0.99* # of Drives* size in TB * (10^12/2^40)

I ovanstående formel är 0,99 den faktor som man kommer fram till genom att försiktigt anta att det finns en overhead på 1 % från filsystemet. För att komma fram till antalet enheter för lagring ingår även 12 enheter från MDS. Det beror på att de 12 enheterna i NUMA-zon 0 används för metadata och de 12 enheterna i NUMA-zon 1 används för lagring i MDS. Den sista faktorn i formeln 10^12/2^40 är att konvertera det användbara utrymmet från TB till TiB.

Skalbara konfigurationer

BeeGFS högpresterande lagringslösning är utformad för att vara flexibel och man kan enkelt och sömlöst skala prestanda och/eller kapacitet genom att lägga till ytterligare servrar enligt nedan:

Figur 2: Exempel på skalade konfigurationer

Metadatadelen av stacken förblir densamma för alla ovanstående konfigurationer som beskrivs i den här bloggen. Detta beror på att kraven på lagringskapacitet för BeeGFS-metadata vanligtvis är 0,5 % till 1 % av den totala lagringskapaciteten. Men det beror verkligen på antalet kataloger och filer i filsystemet. Som en allmän regel kan användaren lägga till ytterligare en metadataserver när procentandelen metadatakapacitet till lagringen sjunker under 1 %. Tabell 2 visar prestandadata för de olika flexibla konfigurationerna av BeeGFS-lagringslösningen.

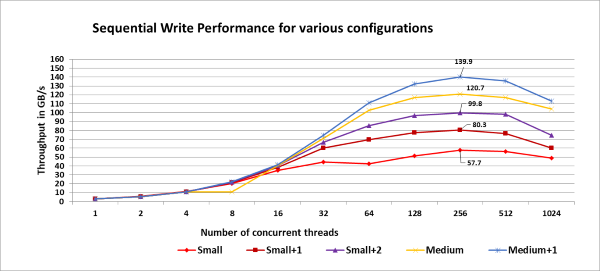

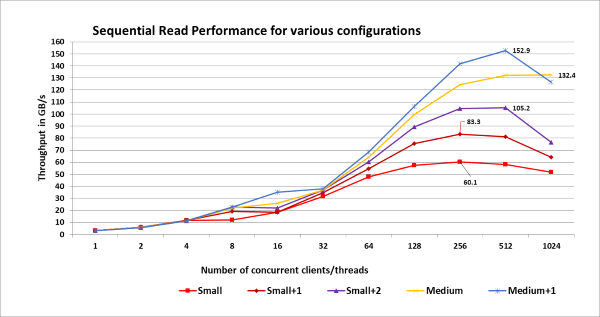

| Konfiguration | Liten | Liten +1 | Liten +2 | Medel | Medel +1 | |

|---|---|---|---|---|---|---|

| Totalt U (MDS + SS) | 6U | 8U | 10U | 12U | 14U | |

| # av dedikerade lagringsservrar | 2 | 3 | 4 | 5 | 6 | |

| # NVMe-enheter för datalagring | 60 | 84 | 108 | 132 | 156 | |

| Uppskattat användbart utrymme | 1,6 TB | 86 TiB | 121 TiB | 156 TiB | 190 TiB | 225 TiB |

| 3,2 TB | 173 TiB | 242 TiB | 311 TiB | 380 TiB | 449 TiB | |

| 6,4 TB | 346 TiB | 484 TiB | 622 TiB | 761 TiB | 898 TiB | |

| Högsta sekventiella läsning | 60,1 GB/s | 83,3 GB/s | 105,2 GB/s | 132,4 GB/s | 152,9 GB/s | |

| Maximalt antal sekventiella skrivningar | 57,7 GB/s | 80,3 GB/s | 99,8 GB/s | 120,7 GB/s | 139,9 GB/s | |

Tabell 2: Information om kapacitet och prestanda för skalade konfigurationer

Karakterisering av prestanda

Prestandan för de olika konfigurationerna testades genom att skapa lagringspooler. Den lilla konfigurationen har 15 lagringsmål och varje ytterligare lagringsserver lägger till ytterligare sex lagringsmål. Så för att testa prestandan för de olika konfigurationerna skapades lagringspooler från 15 till 39 lagringsmål (steg om sex för liten, liten+1, liten+2, medel, medel+1). För var och en av dessa pooler kördes tre iterationer av IOzone-riktmärket, var och en med en till 1024 trådar (i steg om två). Den testmetod som används är densamma som den som beskrivs i meddelandebloggen . Bild 3 och 4 visar skriv- och läsprestanda för de skalbara konfigurationerna, med toppprestanda för var och en av konfigurationerna markerade som referens:

Bild 3: Skrivprestanda för skalbara konfigurationer.

Figur 4: Läsprestanda för skalbara konfigurationer.

Obs!

Den lagringspool som hänvisas till skapades endast för det uttryckliga syftet att karakterisera prestandan hos olika konfigurationer. När prestandautvärderingen av medelkonfigurationen som beskrivs i blogginlägget gjordes, fanns alla 33 målen endast i standardpoolen. Utdata från beegfs-ctl --liststoragepools Kommandot nedan visar tilldelningen av lagringsmålen:

# beegfs-ctl --liststoragepools Pool ID Pool Description Targets Buddy Groups ======= ================== ============================ ============================ 1 Default 1,2,3,4,5,6,7,8,9,10,11,12, 13,14,15,16,17,18,19,20,21, 22,23,24,25,26,27,28,29,30, 31,32,33

Slutsats och framtida arbete

I den här bloggen diskuterades skalbarheten hos Dell Ready Solutions för HPC BeeGFS-lagring och prestandan för sekventiell läs- och skrivgenomströmning belystes för olika konfigurationer. Håll ögonen öppna för del 3 av denna bloggserie som kommer att diskutera ytterligare funktioner i BeeGFS och belysa användningen av "StorageBench", det inbyggda riktmärket för lagringsmål för BeeGFS. Som en del av nästa steg kommer vi att publicera ett informationsdokument senare med metadataprestanda, IOR N-1-prestandautvärdering och med ytterligare information om designöverväganden, justering och konfiguration.

Referenser

[1] Färdiga Dell-lösningar för HPC BeeGFS-lagring:

https://www.dell.com/support/article/sln319381/[2] BeeGFS-dokumentation:

https://www.beegfs.io/wiki/[3] Så här ansluter du två gränssnitt i samma subnät:

https://access.redhat.com/solutions/30564[4] PCI Express Direct Memory Access Reference Design med externt minne: https://www.intel.com/content/www/us/en/programmable/documentation/nik1412547570040.html#nik1412547565760